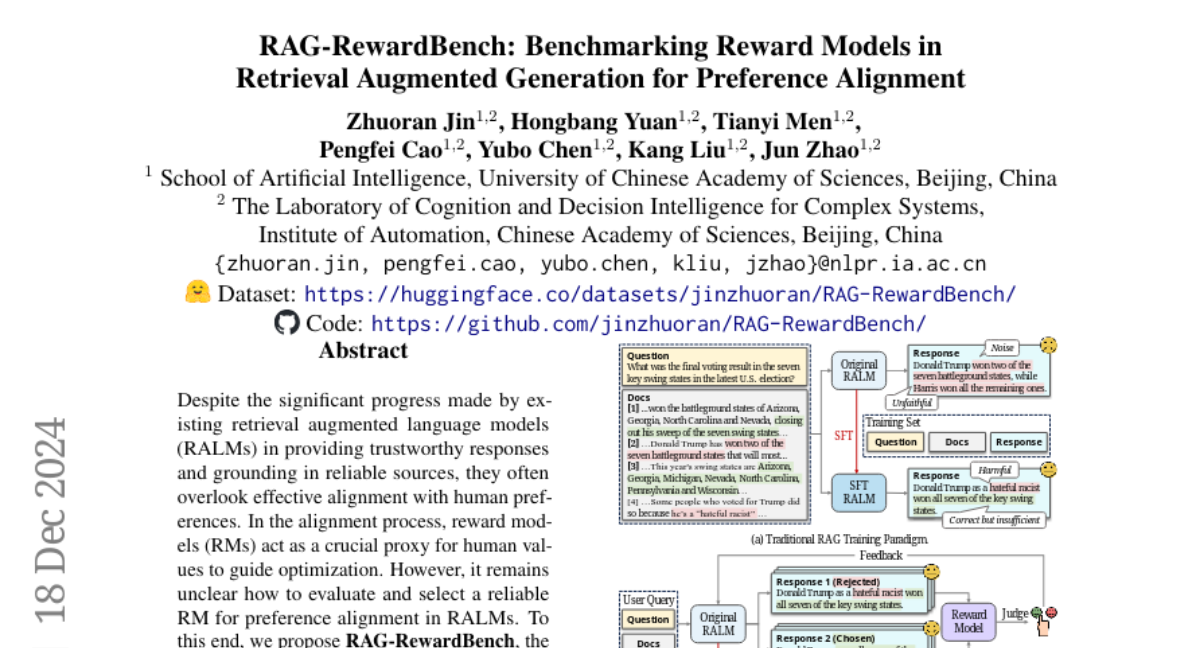

RAG-RewardBench: Оценка моделей вознаграждения в контексте генерации с использованием дополненной выборки

Несмотря на значительный прогресс, достигнутый существующими языковыми моделями с дополненной извлечением (RALMs) в обеспечении надежных ответов и оснований на надежных источниках, они часто упускают из виду эффективное согласование с предпочтениями человека. В процессе согласования модели вознаграждения (RMs) выступают в качестве важного прокси для человеческих ценностей, чтобы направлять оптимизацию. Однако до сих пор неясно, как оценить и выбрать надежную RM для согласования предпочтений в RALMs. В этой связи мы предлагаем RAG-RewardBench, первую оценочную таблицу для оценки RMs в условиях RAG. Сначала мы разрабатываем четыре ключевых и сложных сценария, специфичных для RAG, для оценки RMs, включая многоступенчатое рассуждение, детальную цитату, соответствующее воздержание и устойчивость к конфликтам. Затем мы включаем 18 подмножеств RAG, шесть извлекателей и 24 RALMs, чтобы увеличить разнообразие источников данных. Наконец, мы используем подход LLM-as-a-judge для повышения эффективности и результативности аннотирования предпочтений, демонстрируя сильную корреляцию с аннотациями человека. На основе RAG-RewardBench мы проводим всестороннюю оценку 45 RMs и выявляем их ограничения в сценариях RAG. Кроме того, мы также обнаруживаем, что уже обученные RALMs почти не показывают улучшения в согласовании предпочтений, подчеркивая необходимость перехода к обучению, основанному на предпочтениях. Мы публикуем нашу оценочную таблицу и код в открытом доступе по адресу https://huggingface.co/datasets/jinzhuoran/RAG-RewardBench/ для будущих исследований.