Обратное мышление делает LLM более сильными рассуждателями

Обратное мышление — это важный аспект человеческого рассуждения. Люди могут решать задачи не только от проблемы к решению, но и в обратном порядке: начиная с решения и возвращаясь к проблеме. Этот подход часто улучшает общую производительность рассуждений, так как позволяет проверять согласованность между прямым и обратным мышлением. В этой статье мы обсудим концепцию, представленную в работе "Reverse Thinking Makes LLMs Stronger Reasoners" и предложим подход, называемый Reverse-Enhanced Thinking (R,EV,T,HINK). Этот подход включает в себя методы аугментации данных и новые цели обучения, которые помогают языковым моделям (LLM) развивать способности к обратному мышлению.

Обратное мышление, как утверждает Карл Якоби, "инвертируй, всегда инвертируй". Оно играет ключевую роль в процессе рассуждения человека. Например, в простой математической задаче, когда Эмма имеет два яблока, а Джек три, можно сначала вычислить общее количество яблок, а затем проверить, правильно ли мы определили количество у Джека, используя обратное мышление. Если прямое рассуждение приводит к ошибочному ответу, обратное мышление помогает выявить несоответствие и пересмотреть решение.

Предыдущие исследования показали, что LLM могут извлечь пользу из комбинированного подхода к рассуждению, который включает как прямое, так и обратное мышление. Это особенно актуально в математических задачах, где структура задач позволяет легко проверять правильность ответов. Однако возникает вопрос: можно ли применить обратное мышление к более широкому кругу менее структурированных задач?

Обратное мышление как метод в LLM

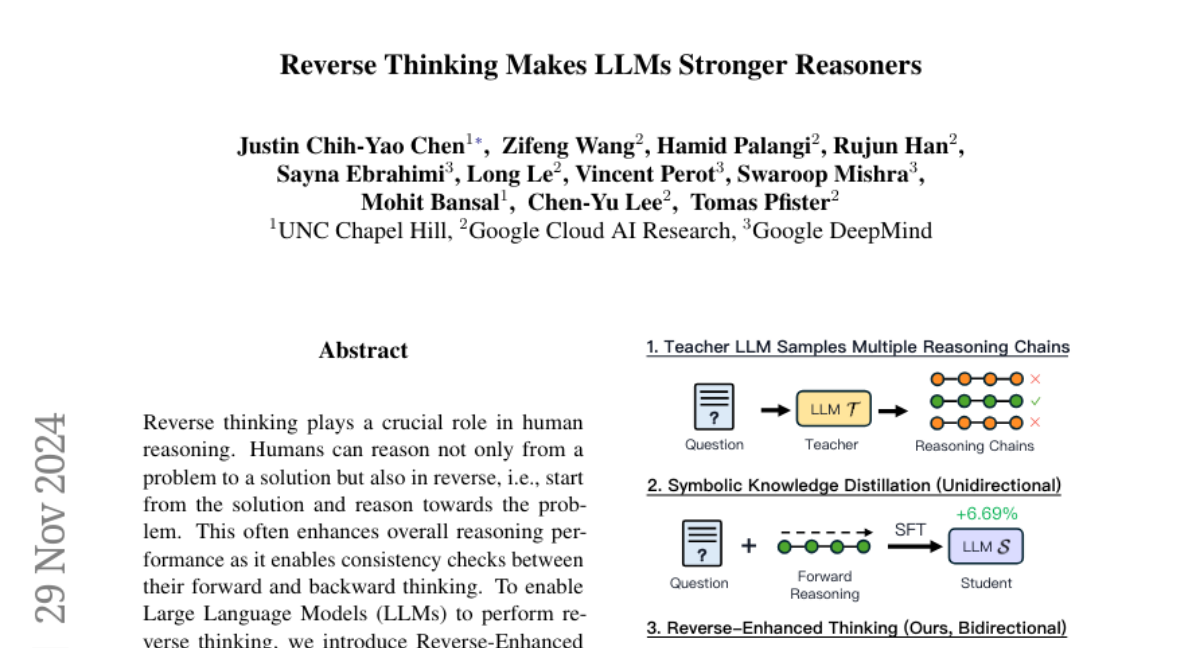

Для решения этого вопроса был предложен R,EV,T,HINK — фреймворк, который включает аугментацию данных и новые цели обучения, направленные на внедрение обратного мышления в языковые модели. Основная идея заключается в том, чтобы использовать более мощную учительскую модель для генерации структурированных данных, которые включают следующие компоненты:

- Исходный вопрос

- Прямое рассуждение

- Обратный вопрос

- Обратное рассуждение

Собранные данные позволяют обучать более компактную модель-студента с использованием трех задач в режиме многозадачного обучения:

- Генерация прямого рассуждения из вопроса

- Генерация обратного вопроса из вопроса

- Генерация обратного рассуждения из обратного вопроса

Таким образом, модель-студент обучается рассуждать в обоих направлениях, что значительно улучшает ее способность к решению задач.

Методология R,EV,T,HINK

1. Настройка проблемы

Сначала мы определяем набор данных, состоящий из пар "вопрос-ответ". Затем мы предполагаем наличие доступа к учительской модели, которая может генерировать ответы, но не предоставляет логитов. Наша цель — обучить модель-студента, улучшая ее способности к рассуждению.

2. Аугментация данных

Аугментация данных — это ключевой этап в R,EV,T,HINK. Мы начинаем с набора данных, состоящего из вопросов и ответов, и используем учительскую модель для генерации:

- Прямого рассуждения

- Обратного вопроса

- Обратного рассуждения

Мы отбираем только те примеры, где прямое рассуждение верно, и где обратное рассуждение соответствует исходному вопросу.

3. Цели обучения

Модель-студент обучается с использованием трех ключевых целей:

- Генерация прямого рассуждения из вопроса

- Генерация обратного вопроса из исходного вопроса

- Генерация обратного рассуждения из обратного вопроса

Эти цели помогают модели интернализировать процесс обратного рассуждения во время обучения, сохраняя при этом эффективность вычислений на этапе тестирования.

Экспериментальная установка

Для оценки R,EV,T,HINK мы применили его на 12 различных наборах данных, охватывающих общие рассуждения, математические задачи, логические рассуждения и выводы на естественном языке. Мы использовали две модели: Mistral-7B-Instruct и Gemma-7B-Instruct.

Результаты

Результаты показали, что R,EV,T,HINK значительно улучшает производительность модели-студента, обеспечивая средний прирост на 13.53% по сравнению с нулевым производством модели и 6.84% по сравнению с основными методами дистилляции знаний. Кроме того, R,EV,T,HINK демонстрирует высокую эффективность образцов, позволяя использовать всего 10% корректного прямого рассуждения из обучающих данных, чтобы превзойти стандартные методы дообучения, использующие в 10 раз больше данных.

Анализ и выводы

Общие выводы

R,EV,T,HINK продемонстрировала значительное улучшение в производительности на различных типах задач. Метод показал, что обучение обратному мышлению не только улучшает внутреннее рассуждение модели, но и способствует лучшей обобщаемости на невидимых наборах данных.

Ограничения

Несмотря на успехи, следует отметить, что учительская модель, используемая в R,EV,T,HINK, может по-прежнему генерировать предвзятые ответы. Следовательно, модели-студенты, созданные через дистилляцию, могут унаследовать эти нежелательные черты. Это подчеркивает необходимость дальнейших исследований для эффективной оценки и минимизации предвзятости в LLM.

Заключение

R,EV,T,HINK является значительным шагом вперед в области языковых моделей, позволяя им развивать способности к обратному мышлению. Этот подход не только улучшает производительность на широком спектре задач, но и демонстрирует эффективность в использовании ограниченных данных. В будущем стоит рассмотреть возможность интеграции R,EV,T,HINK в существующие модели для дальнейшего улучшения их рассуждающих способностей.