MIVE: Новый Подход и Бенчмарк для Мульти-Инстанционного Видеомонтажа

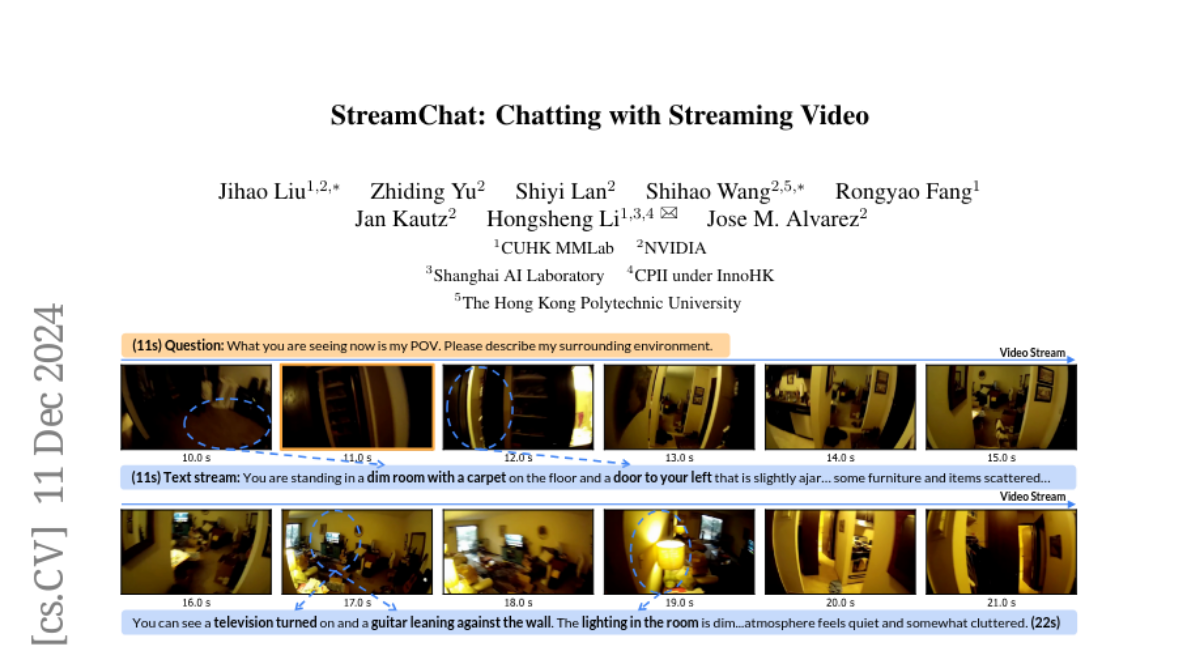

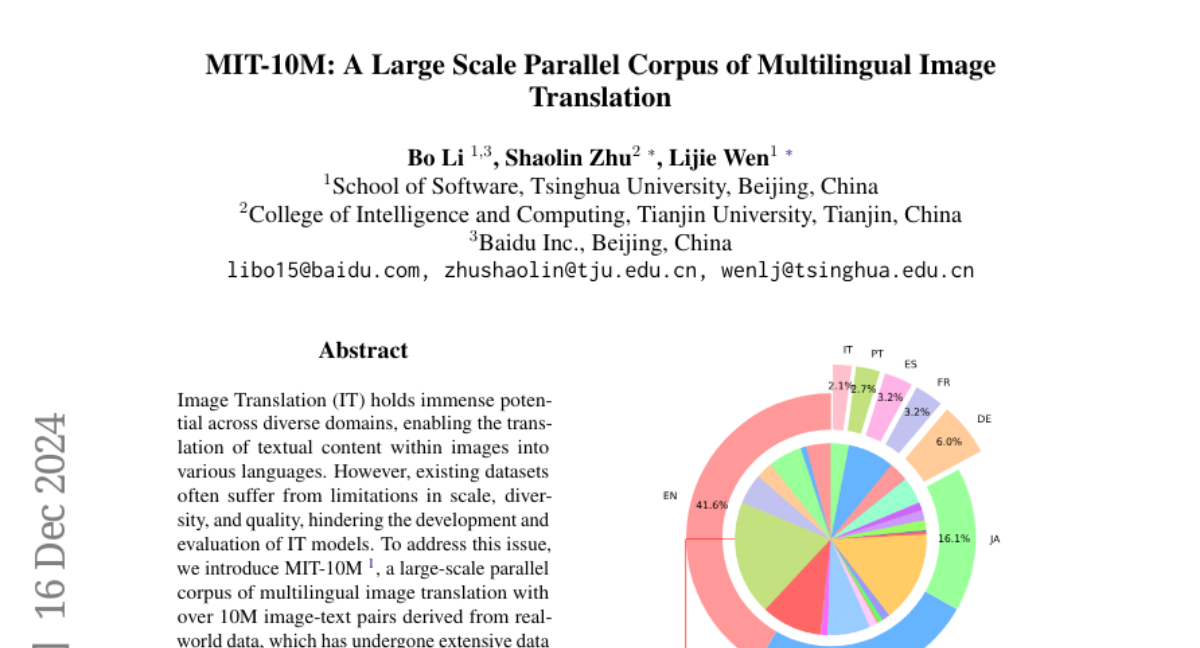

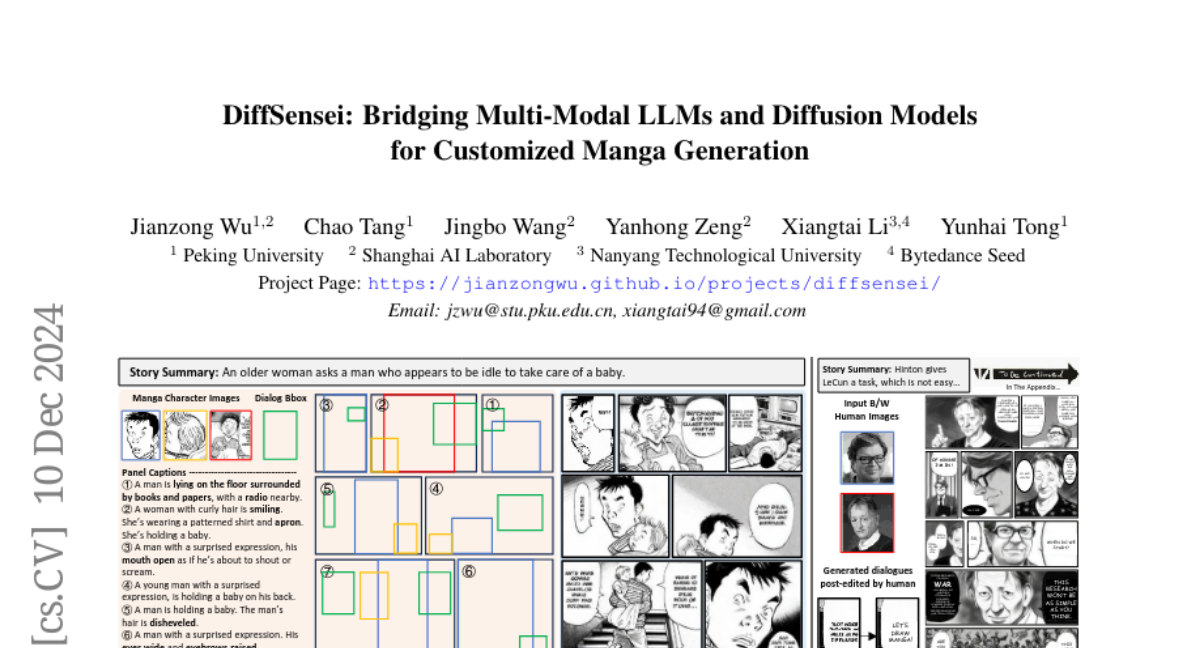

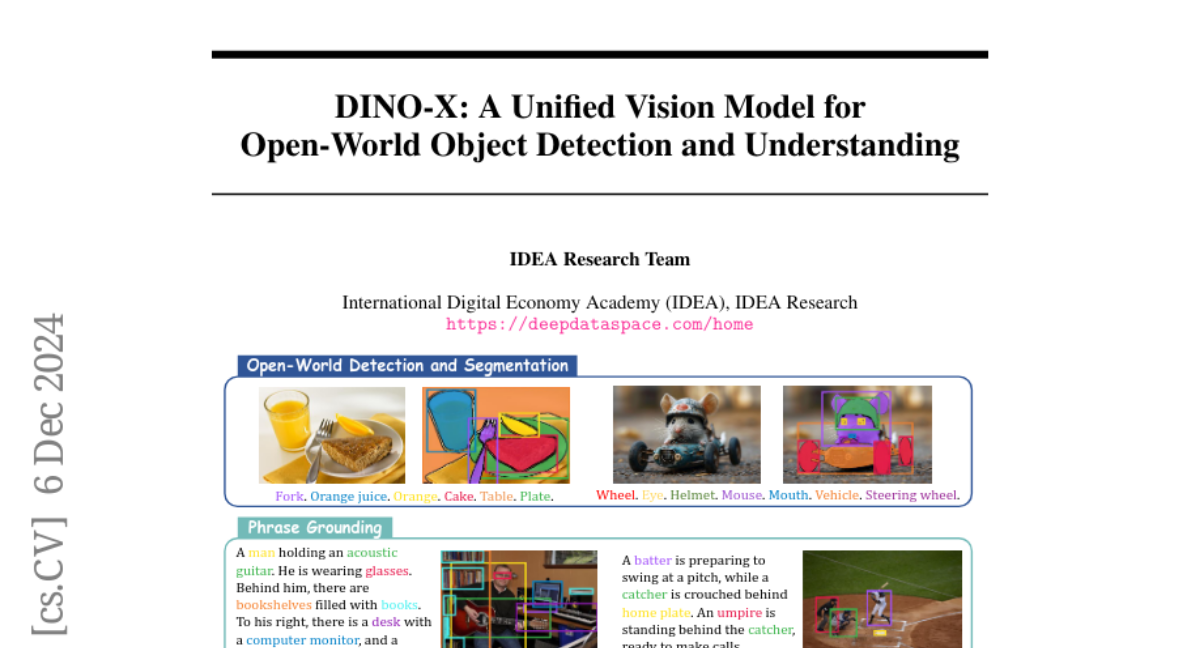

Недавние методы видеомонтажа на основе ИИ позволили пользователям редактировать видео с помощью простых текстовых подсказок, значительно упрощая процесс редактирования. Однако недавние методы видеомонтажа без предварительной тренировки в основном сосредоточены на глобальных изменениях или редактировании одного объекта, что может привести к нежелательным изменениям в других частях видео. Когда несколько объектов требуют локализованных изменений, существующие методы сталкиваются с такими проблемами, как неточное редактирование, утечка редактирования и нехватка подходящих датасетов и метрик для оценки. Чтобы преодолеть эти ограничения, мы предлагаем нулевую многокомпонентную видеомонтажную структуру, названную MIVE. MIVE — это универсальная маско-ориентированная структура, не предназначенная для конкретных объектов (например, людей). MIVE вводит два ключевых модуля: (i) Разделенное многокомпонентное выборка (DMS), чтобы предотвратить утечку редактирования, и (ii) Вероятностное перераспределение на основе объектов (IPR), чтобы обеспечить точную локализацию и достоверное редактирование. Кроме того, мы представляем наш новый датасет MIVE с разнообразными видеосценариями и вводим Оценку точности между экземплярами (CIA) для оценки утечки редактирования в задачах многокомпонентного видеомонтажа. Наши обширные качественные, количественные и пользовательские исследования демонстрируют, что MIVE значительно превосходит современные передовые методы по верности редактирования, точности и предотвращению утечек, устанавливая новый стандарт для многокомпонентного видеомонтажа. Страница проекта доступна по адресу https://kaist-viclab.github.io/mive-site/.