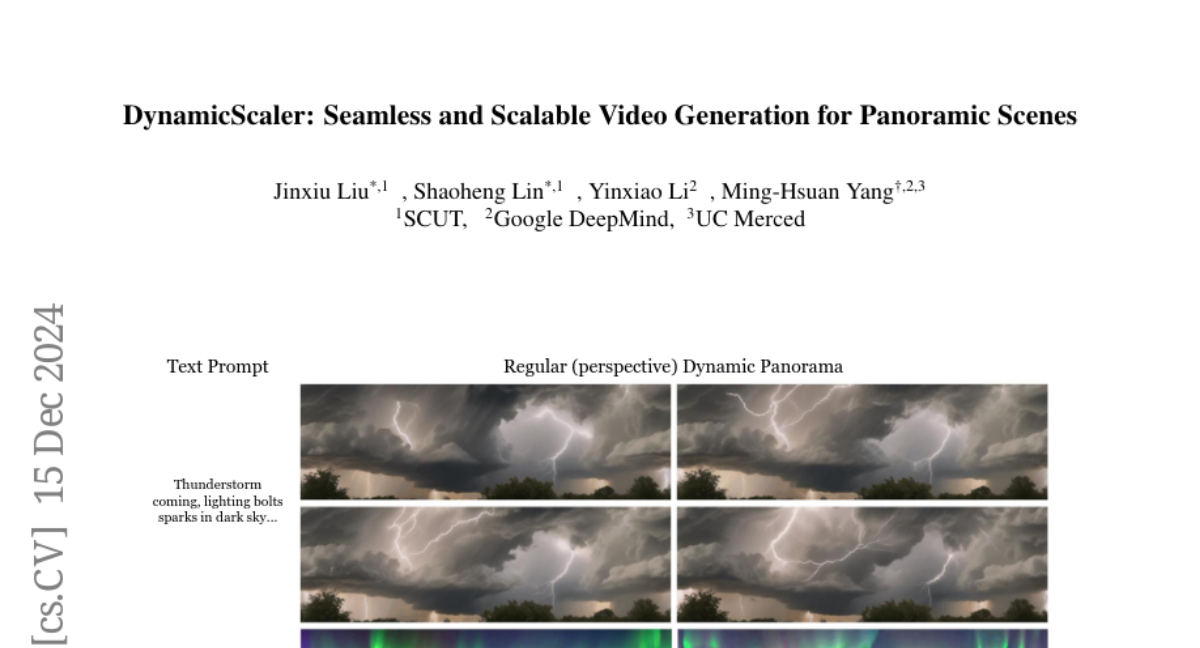

DynamicScaler: Бесшовная и Масштабируемая Генерация Видео для Панорамных Сцен

С increasing требованием к погружающим AR/VR приложениям и пространственному интеллекту возросла необходимость в создании видеосодержимого высокого качества на уровне сцен и 360° панорамного видео. Однако большинство моделей диффузии видео ограничены разрешением и соотношением сторон, что ограничивает их применимость для синтеза динамического контента на уровне сцен. В этой работе мы предлагаем DynamicScaler, который решает эти проблемы, позволяя осуществлять пространственно масштабируемый и панорамный динамический синтез сцен, сохраняя согласованность в панорамных сценах произвольного размера. В частности, мы представляем Denoiser с Сдвигом Смещения, облегчающий эффективное, синхронное и согласованное уменьшение шума панорамных динамических сцен с помощью модели диффузии с фиксированным разрешением через бесшовное вращающееся окно, что обеспечивает бесшовные переходы границ и согласованность по всему панорамному пространству, учитывая различные разрешения и соотношения сторон. Кроме того, мы используем механизм Глобального Направления Движения, чтобы обеспечить как локальную детализацию, так и глобальную непрерывность движения. Обширные эксперименты показывают, что наш метод обеспечивает превосходное качество контента и движения при генерации панорамного видео на уровне сцен, предлагая решение без необходимости в обучении, эффективное и масштабируемое для создания погружающих динамических сцен с постоянным потреблением VRAM независимо от разрешения выходного видео. Наша страница проекта доступна по адресу https://dynamic-scaler.pages.dev/.