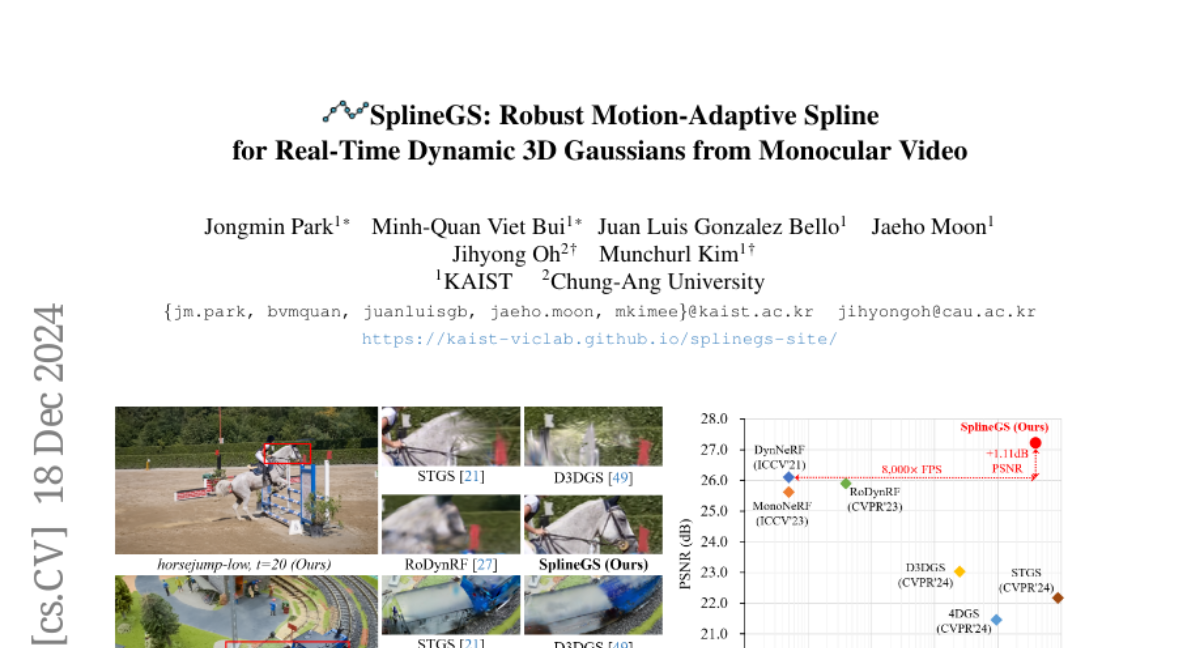

SplineGS: Новая эра синтеза новизны в динамических сценах

Синтезирование новых видов из монокулярных видео в естественной обстановке представляет собой сложную задачу из-за динамики сцены и отсутствия многоугловых подсказок. Для решения этой проблемы мы предлагаем SplineGS, свободную от COLMAP динамическую 3D Gaussian Splatting (3DGS) архитектуру для высококачественной реконструкции и быстрой отрисовки из монокулярных видео. В ее основе лежит новый метод Motion-Adaptive Spline (MAS), который представляет собой непрерывные динамические 3D Gaussian траектории с использованием кубических сплайнов Эрмита с малым числом контрольных точек. Для MAS мы вводим метод Motion-Adaptive Control points Pruning (MACP), чтобы смоделировать деформацию каждой динамической 3D Gaussian при различных движениях, постепенно уменьшая количество контрольных точек, сохраняя при этом целостность динамического моделирования. Кроме того, мы представляем стратегию совместной оптимизации для оценки параметров камеры и 3D Gaussian атрибутов, используя фотометрию и геометрическую согласованность. Это устраняет необходимость в предварительной обработке Structure-from-Motion и повышает устойчивость SplineGS в реальных условиях. Эксперименты показывают, что SplineGS значительно превосходит современные методы по качеству синтеза новых видов для динамических сцен из монокулярных видео, достигая скорости отрисовки в тысячи раз быстрее.