ReCapture: Генерация Видео с Новыми Траекториями Камеры для Пользовательских Видео

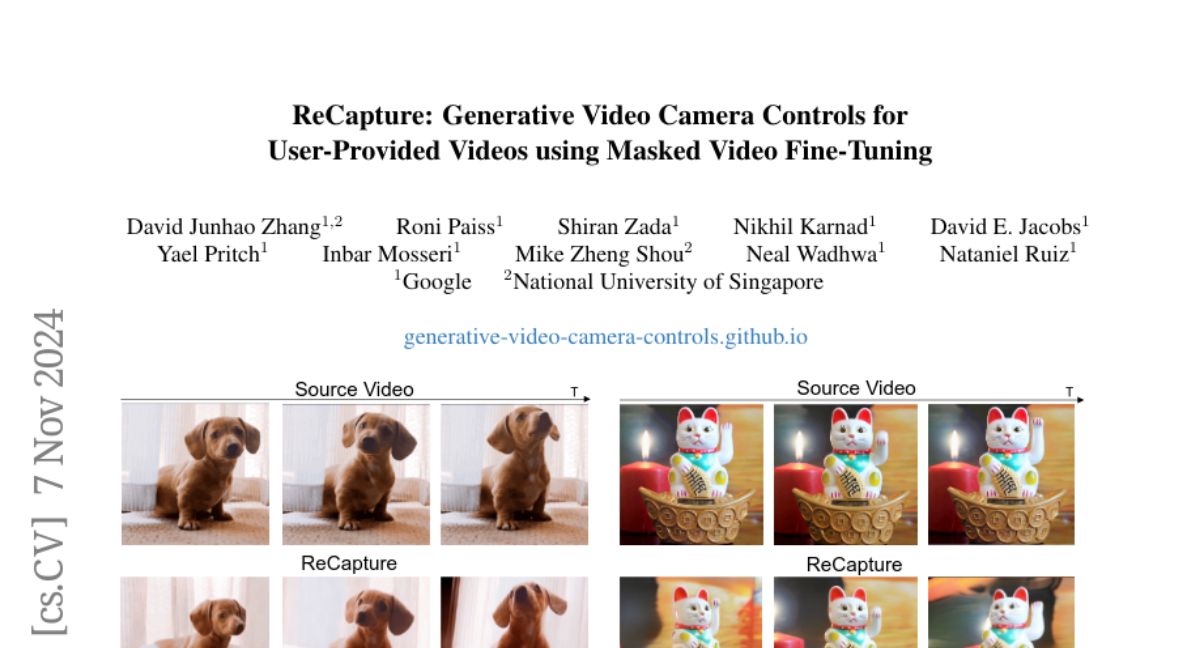

В последнее время в области моделирования видео произошли значительные прорывы, позволяющие управлять траекториями камеры в сгенерированных видео. Однако, эти методы не могут быть напрямую применены к пользовательским видео, которые не были созданы с помощью видео модели. В этой статье мы представляем ReCapture, метод, который позволяет генерировать новые видео с новыми траекториями камеры из одного пользовательского видео. Наш метод позволяет повторно генерировать исходное видео, сохраняя все его существующие движения сцены, но с совершенно новых углов и с кинематографическими движениями камеры. Более того, мы можем правдоподобно "догадываться" о частях сцены, которые не были видны в исходном видео.

Основные Концепции

Генерация Якорного Видео

Первый этап нашего метода включает в себя создание "якорного видео" с новой траекторией камеры. Это достигается двумя способами:

-

Моделирование Последовательности Облаков Точек: Мы используем оценку глубины для преобразования каждого кадра исходного видео в облако точек в 3D пространстве. Затем, симулируя движение камеры, мы рендерим облако точек, получая новый вид видео. Этот метод хорошо подходит для простых движений камеры, таких как панорамирование, наклон и зум.

-

Мульти-вью Диффузионные Модели: Для более сложных движений камеры, включающих значительные вращения, мы используем мульти-вью диффузионные модели. Эти модели обучены на множестве изображений с различных углов, что позволяет им генерировать новые виды сцены, даже если они не были видны в исходном видео.

Маскированная Видео Тонкая Настройка

Второй этап нашего метода фокусируется на улучшении качества якорного видео и его временной согласованности:

-

Контекстно-осведомленный Пространственный LoRA: Мы вводим пространственную адаптацию низкого ранга (LoRA) для улучшения визуального качества и соответствия контексту исходного видео. Эта адаптация обучается на увеличенных кадрах, извлеченных из исходного видео, что позволяет модели лучше понимать внешний вид субъекта и фон.

-

Временной LoRA с Маскированием: Для обеспечения временной согласованности мы применяем временную адаптацию LoRA, которая обучается на якорном видео с использованием маскированной потери. Маскирование исключает неизвестные области из вычисления потерь, позволяя модели сосредоточиться на известных и значимых регионах.

-

Удаление Размытости: После обучения обоих LoRA, мы используем видео диффузионную модель для генерации финального видео с новой траекторией камеры. Для дальнейшего улучшения качества и устранения размытости мы применяем метод SDEdit, который использует пространственный LoRA для сохранения оригинального внешнего вида субъекта.

Эксперименты и Результаты

Мы провели обширные качественные и количественные оценки, сравнивая наш метод с ведущими базовыми моделями для синтеза новых видов в существующих видео. Наш метод показал превосходные результаты в плане сохранения согласованности субъекта, качества движения и визуальной эстетики, что подтверждается как автоматическими метриками, так и пользовательскими исследованиями.

Качественная Оценка

Сравнение с Generative Camera Dolly показало, что наш метод точнее следует заданной траектории камеры, создает меньше артефактов и имеет меньше размытости. Даже при значительных изменениях позиции камеры, наш метод сохраняет движение и внешний вид субъекта, в то время как Dolly страдает от значительных артефактов.

Количественная Оценка

На датасете Kubric-4D наш метод превзошел существующие методы 4D реконструкции и генерации, демонстрируя превосходство в метриках PSNR, SSIM и LPIPS, особенно в областях окклюзии. На VBench наш метод также показал лучшие результаты в большинстве измерений, включая согласованность субъекта, отсутствие мерцания и временную плавность.

Агляция

Агляция показала важность каждого компонента нашего метода. Использование временного LoRA с маскированием значительно улучшило временную согласованность и визуальное качество. Добавление контекстно-осведомленного пространственного LoRA дополнительно повысило визуальное качество и согласованность субъекта, а применение SDEdit позволило уменьшить артефакты и улучшить общее качество видео.

Заключение

ReCapture предлагает новый подход к генерации видео с новыми траекториями камеры, используя сильный приоритет видео моделей и избегая необходимости в больших объемах 4D обучающих данных. Наш метод демонстрирует удивительную способность к обобщению на различные видео и сцены, сохраняя сложное движение сцены и детали, что делает его мощным инструментом для создания кинематографических видео из пользовательских источников.