Улучшение способности следовать сложным инструкциям у больших языковых моделей через обратный перевод ограничений

Большие языковые модели (LLM) за последние годы достигли впечатляющих результатов в различных задачах обработки естественного языка, от создания текста до анализа данных. Однако, несмотря на эти успехи, они все еще сталкиваются с трудностями при следовании инструкциям, которые содержат сложные ограничения по формату, длине или стилю. Традиционные методы обучения на инструкциях, такие как постобучение на парах инструкция-ответ, генерируемых продвинутыми LLM, часто не дают желаемых результатов, поскольку даже самые продвинутые модели не всегда могут точно следовать сложным инструкциям.

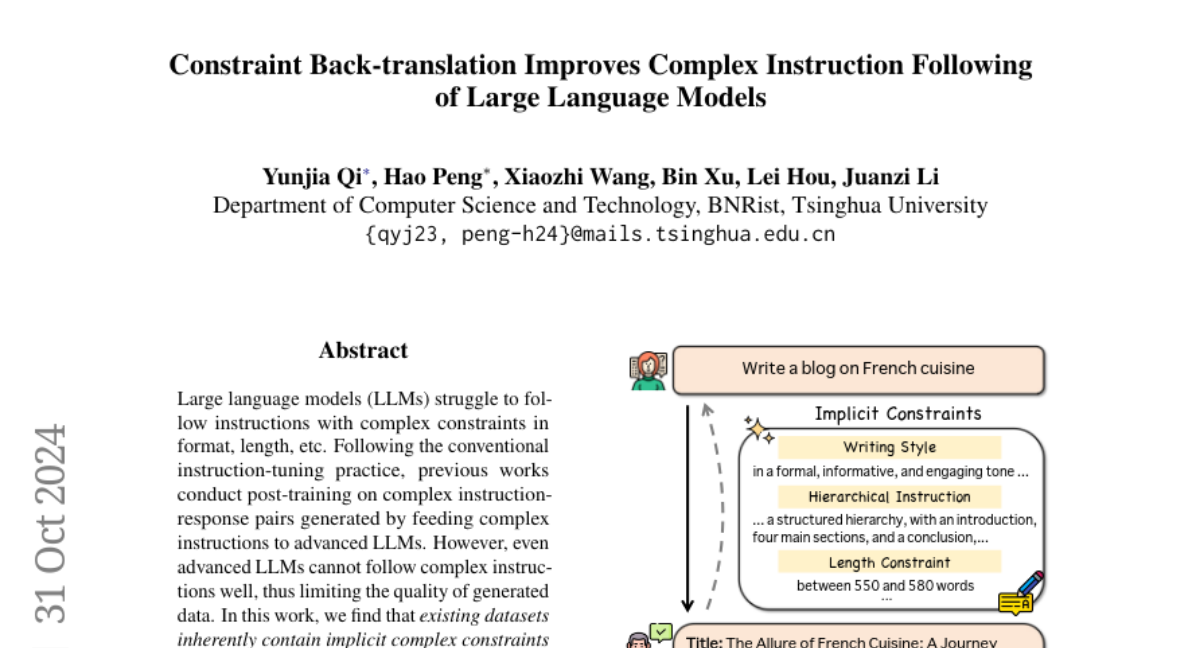

В данной статье мы рассмотрим новый подход, предложенный в исследовании "Constraint Back-translation Improves Complex Instruction Following of Large Language Models" (Qi et al., 2024). Этот метод, названный обратным переводом ограничений, предлагает эффективный способ генерации данных для обучения, который позволяет улучшить способность LLM следовать сложным инструкциям.

Обратный перевод ограничений

Основная концепция

Обратный перевод ограничений (Constraint Back-translation, CBT) основан на идее, что в существующих наборах данных уже содержатся ответы, которые неявно соответствуют сложным ограничениям. Вместо того чтобы генерировать новые инструкции и ответы, CBT использует уже имеющиеся высококачественные пары инструкций и ответов, добавляя к ним ограничения, которые уже выполняются ответом.

Процесс

-

Сбор данных: Используются существующие наборы данных с высококачественными парами инструкций и ответов.

-

Обратный перевод ограничений: Для каждой пары инструкция-ответ используется продвинутая LLM (в данном случае Llama3-70B-Instruct) для генерации ограничений, которые уже выполняются ответом. Это позволяет избежать шума в данных, так как ограничения уже подтверждены ответом.

-

Комбинация ограничений: Сгенерированные ограничения комбинируются для создания новых инструкций с множественными ограничениями. Это делается для того, чтобы модель обучалась на более сложных сценариях.

Преимущества

- Снижение шума: Поскольку ограничения уже выполняются ответом, генерируемые данные содержат меньше ошибок.

- Экономия ресурсов: Не требуется генерировать новые ответы, что значительно снижает затраты на вычислительные ресурсы.

- Качество данных: Данные, созданные таким образом, обладают высокой точностью и соответствием реальным сценариям использования.

Эксперименты и результаты

Построение набора данных C-RAB

Для демонстрации эффективности метода CBT был создан набор данных C-RAB (Complex Response Annotation by Back-translation). В него включены 13,500 экземпляров, где каждый экземпляр содержит инструкцию, ответ и набор ограничений, которые ответ уже удовлетворяет. Этот набор данных был использован для постобучения нескольких базовых моделей LLM.

Обучение моделей

Модели обучались на смешанном наборе данных, включающем C-RAB и ShareGPT. Использовались как стандартные методы обучения с учителем (SFT), так и обратное обучение (reverse training), где модели обучались генерировать ограничения на основе инструкций и ответов.

Оценка

Модели оценивались на двух бенчмарках: IFEval и FollowBench. Результаты показали, что:

- Модели, обученные на C-RAB, значительно улучшили свою способность следовать сложным инструкциям по сравнению с базовыми моделями.

- Обратное обучение оказалось эффективным дополнительным методом, улучшающим понимание ограничений моделями.

Анализ

Анализ показал, что модели, обученные с использованием CBT, не только лучше следуют сложным инструкциям, но и демонстрируют улучшение в общей способности следовать инструкциям, что было подтверждено на бенчмарке AlpacaEval.

Заключение

Метод обратного перевода ограничений представляет собой инновационный подход к улучшению способности LLM следовать сложным инструкциям. Он позволяет эффективно использовать существующие данные, снижает шум и затраты на генерацию новых данных. В результате, модели, обученные с использованием CBT, демонстрируют значительные улучшения в выполнении задач с множественными ограничениями, что открывает новые возможности для их применения в реальных сценариях, где точность и соответствие инструкциям критически важны.

Этот метод не только улучшает качество ответов моделей, но и способствует более глубокому пониманию ограничений, что делает LLM более полезными и приспособленными к разнообразным задачам, требующим точного следования инструкциям.