I,NST-IT: Усовершенствование многомодального понимания экземпляров через явную настройку визуальных подсказок

Совсем недавно большие многомодальные модели (LMMs) достигли значительных успехов благодаря развитию настройки инструкций. Эти модели могут обрабатывать изображения и видео на общем уровне, но все еще сталкиваются с трудностями в понимании на уровне экземпляров, что требует более тонкого понимания и согласования. Понимание на уровне экземпляров является ключевым, поскольку оно фокусируется на конкретных элементах, которые представляют интерес для пользователей.

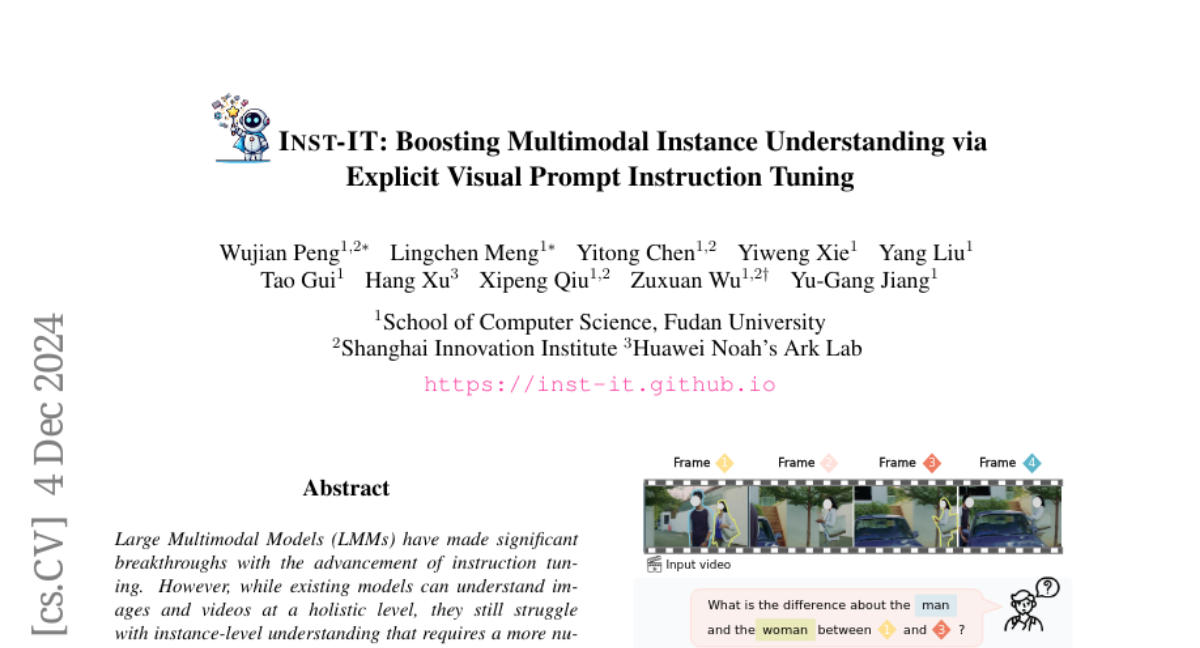

В этой статье мы представим новый подход, называемый I,NST-IT, который включает в себя автоматизированный процесс аннотирования, использующий GPT-4o для извлечения информации на уровне экземпляров из изображений и видео через явные визуальные подсказки. Мы разработали I,NST-IT как решение для улучшения возможностей LMMs в понимании экземпляров через явную настройку визуальных подсказок.

Проблема понимания на уровне экземпляров

Понимание на уровне экземпляров относится к способности моделей осознавать атрибуты конкретных экземпляров в изображении или видео, а также взаимодействия между ними. Это требует от моделей демонстрации нюансированного понимания и точного согласования. В последние годы в сообществе компьютерного зрения было предпринято множество усилий для достижения этой цели через задачи, такие как детекция объектов, сегментация экземпляров и отслеживание объектов.

Даже с развитием LMMs, существующие модели по-прежнему испытывают трудности с пониманием конкретного контента на уровне экземпляров. Это ограничивает их способность к тонкому пониманию визуальных входов. В то время как некоторые исследования уже начали изучать многомодальное понимание экземпляров, большинство из них сосредоточено на изображениях, оставляя видео менее исследованным.

Подход I,NST-IT

Чтобы продвинуть многомодальное понимание экземпляров как для изображений, так и для видео, мы сосредоточились на трех ключевых аспектах: оценочном бенчмарке, наборе данных для настройки инструкций и рецепте обучения.

Автоматизированный процесс аннотирования

Мы начали с разработки автоматизированного процесса аннотирования, который предоставляет детализированные аннотации для изображений и видео, с особым акцентом на отдельные экземпляры. Этот процесс включает в себя использование визуальных подсказок для выделения экземпляров интереса. Мы применили метод визуального подсказывания Set-of-Marks (SoM), который накладывает числовые идентификаторы на каждый экземпляр. Это позволяет GPT-4o генерировать точные аннотации, охватывающие несколько аспектов, включая аннотации на уровне экземпляров, аннотации на уровне кадров, описания временных изменений, аннотации на уровне видео и открытые вопросы с ответами.

Бенчмарк I,NST-IT

На основе вышеупомянутого процесса аннотирования мы тщательно спроектировали I,NST-IT Bench — бенчмарк для диагностики многомодальных моделей в понимании на уровне экземпляров. Он включает в себя 1000 образцов тестирования для изображений и 1000 для видео. Мы провели обширные оценки на I,NST-IT Bench и обнаружили, что существующие открытые модели показывают ограниченные результаты в понимании отдельных экземпляров.

Набор данных I,NST-IT

Для решения этой проблемы мы применили наш процесс аннотирования данных, чтобы создать I,NST-IT Dataset, который включает в себя 21 тысячу видео и 51 тысячу изображений. Этот набор данных содержит 207 тысяч аннотаций на уровне кадров, 21 тысячу аннотаций на уровне видео и 335 тысяч пар вопросов и ответов. Это первый набор данных для настройки инструкций, который предоставляет детализированные аннотации, сосредотачиваясь на экземплярах интереса как для изображений, так и для видео.

Рецепт непрерывной настройки инструкций

Мы также предложили рецепт непрерывной настройки инструкций, который эффективно сочетает наш набор данных понимания экземпляров с другими общими данными для настройки инструкций. Включив этот небольшой объем данных, улучшенные модели демонстрируют сильные результаты не только на I,NST-IT Bench, но также на нескольких широко используемых бенчмарках для понимания изображений и видео, таких как AI2D и Egoschema.

Экспериментальные результаты

Результаты экспериментов показывают, что с помощью I,NST-IT наши модели не только достигают выдающихся результатов на I,NST-IT Bench, но также демонстрируют значительные улучшения на различных общих бенчмарках для понимания изображений и видео. Это подчеркивает, что наш набор данных не только улучшает понимание на уровне экземпляров, но и укрепляет общие возможности понимания изображений и видео.

Заключение

Понимание на уровне экземпляров, которое включает в себя детекцию, сегментацию и анализ взаимосвязей между объектами, является долгожданной целью исследований в области компьютерного зрения. В этой статье мы представили I,NST-IT Bench, тщательно подобранный бенчмарк для оценки способностей многомодального понимания экземпляров. Мы также собрали I,NST-IT Dataset, первый набор данных для настройки инструкций с явным визуальным подсказыванием и аннотациями.

С помощью I,NST-IT мы продемонстрировали, что улучшение понимания на уровне экземпляров через явную настройку визуальных подсказок является эффективной стратегией для повышения общего пространственно-временного понимания. В будущем мы планируем расширить наш подход, чтобы охватить более сложные сценарии и улучшить общие возможности моделей.