BrushEdit: Инновационная платформа для редактирования изображений

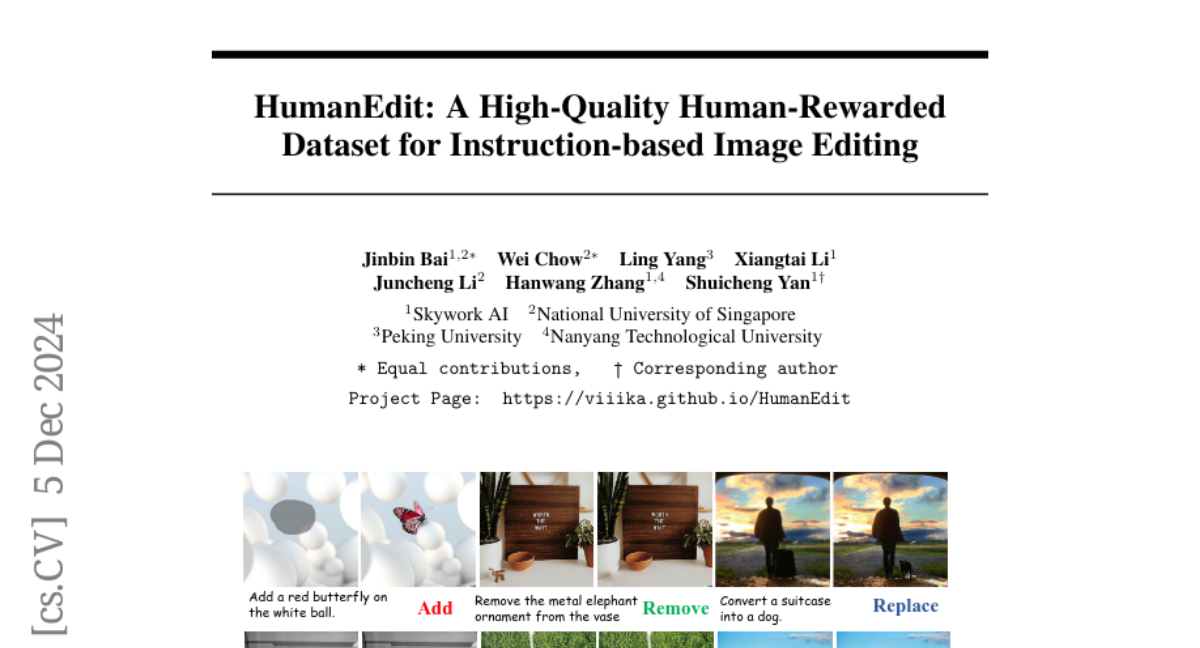

Редактирование изображений значительно продвинулось с развитием диффузионных моделей, использующих как основанные на инверсии, так и основанные на инструкциях методы. Тем не менее, современные подходы, основанные на инверсии, сталкиваются с большими модификациями (например, добавлением или удалением объектов) из-за структурированного характера инверсионного шума, что затрудняет значительные изменения. В то же время, методы, основанные на инструкциях, часто ограничивают пользователей черным ящиком операций, ограничивая прямое взаимодействие для уточнения областей редактирования и интенсивности. Чтобы устранить эти ограничения, мы предлагаем BrushEdit, новую парадигму редактирования изображений, основанную на инпейнтинге и основанную на инструкциях, которая использует мультимодальные большие языковые модели (MLLM) и модели инпейнтинга изображений для обеспечения автономного, удобного для пользователя и интерактивного редактирования на основе свободных инструкций. В частности, мы разрабатываем систему, обеспечивающую редактирование свободных инструкций, интегрируя MLLM и двойную ветвь модели инпейнтинга изображений в рамках агентно-сотрудничающей структуры для выполнения классификации категорий редактирования, идентификации основных объектов, получения масок и инпейнтинга областей редактирования. Обширные эксперименты показывают, что наша структура эффективно комбинирует MLLM и модели инпейнтинга, достигая превосходных результатов по семи метрикам, включая сохранение регионов маски и согласованность эффекта редактирования.