Введение в IOPO: Оптимизация предпочтений входа-выхода для улучшения следования инструкциям в LLM

В мире больших языковых моделей (LLM), где точность следования инструкциям становится ключевым фактором, особенно в условиях возрастающей сложности задач, возникает потребность в эффективных методах улучшения этого аспекта. Данная статья знакомит читателей с новым подходом, известным как Input-Output Preference Optimization (IOPO), который обещает значительно повысить способность LLM следовать сложным инструкциям.

Сложность инструкций и существующие проблемы

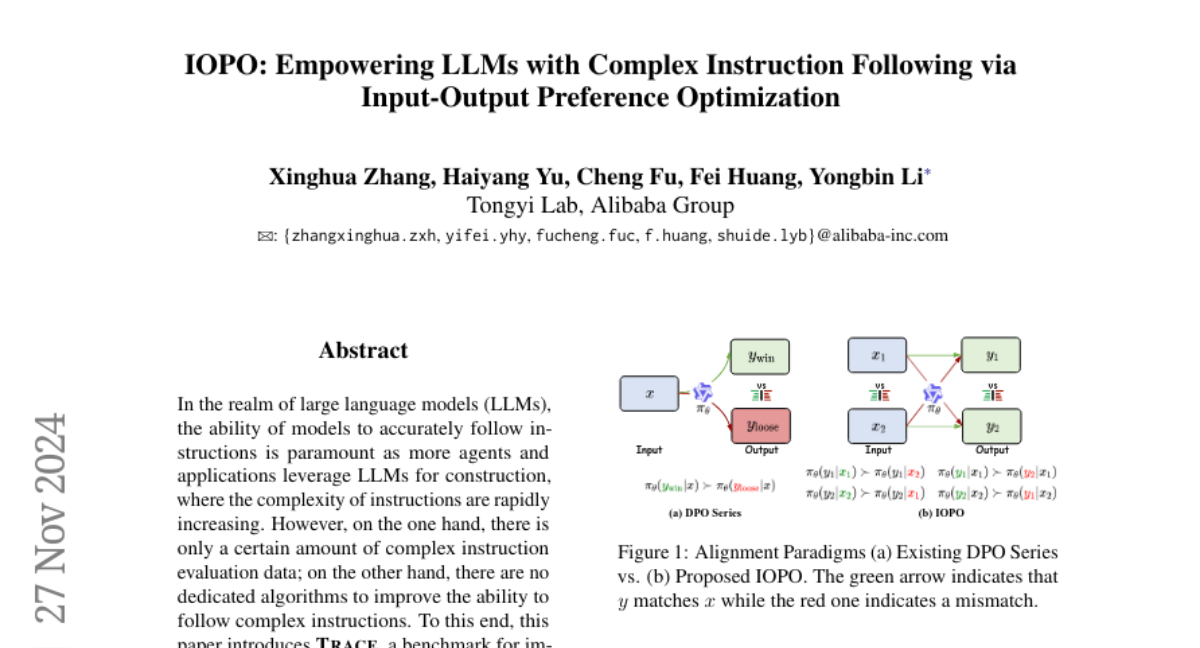

С развитием LLM и их интеграцией в различные приложения, требования к их способности понимать и выполнять инструкции становятся все более высокими. Сложные инструкции, включающие множество ограничений и условий, представляют собой особую сложность. Однако, существующие методы, такие как Supervised Fine-Tuning (SFT) и Direct Preference Optimization (DPO), не всегда справляются с этой задачей наилучшим образом.

- SFT обучает модель на примере выполнения инструкций, но не учитывает предпочтения в ответах.

- DPO оптимизирует модель, чтобы она предпочитала определенные ответы, но не рассматривает детали инструкций.

Представление TRACE: Бенчмарк для оценки следования сложным инструкциям

Для оценки и улучшения способности LLM следовать сложным инструкциям, авторы статьи вводят TRACE — бенчмарк, который содержит 120 тысяч обучающих примеров и 1 тысячу примеров для оценки. TRACE разработан для автоматического построения инструкций с множественными ограничениями, что позволяет более точно оценивать и улучшать модели.

Конструкция TRACE

TRACE включает в себя:

- Таксономия ограничений: Разработана система классификации ограничений, включающая 5 типов и 26 измерений.

- Расширение ограничений: Процесс, в котором простые инструкции преобразуются в более сложные, включая множество ограничений.

- Структурирование инструкций: Разделение инструкций на описание задачи, ограничения и входные данные.

- Контроль качества: Проверка инструкций на валидность и полноту.

- Генерация и оценка ответов: Создание ответов на инструкции и их оценка по степени соответствия ограничениям.

IOPO: Новый подход к оптимизации

IOPO предлагает новый взгляд на оптимизацию предпочтений, учитывая как входные данные (инструкции), так и выходные (ответы). В отличие от DPO, который фокусируется только на предпочтениях в ответах, IOPO:

- Учитывает входные данные: Модель учитывает не только предпочтения в ответах, но и детали инструкций, что позволяет лучше понимать и выполнять сложные задачи.

- Использует пары предпочтений: Вводится понятие пары предпочтений, где одна инструкция может иметь несколько ответов, и модель учится выбирать наиболее подходящий.

Эксперименты и результаты

Эксперименты, проведенные на TRACE и других бенчмарках, показали, что IOPO значительно улучшает способность LLM следовать сложным инструкциям. В частности, IOPO показал улучшение на 8.15% и 2.18% по сравнению с SFT и DPO на внутренних данных, и на 6.29% и 3.13% на внешних данных соответственно.

Заключение

IOPO представляет собой инновационный подход к оптимизации предпочтений в LLM, который обещает улучшить их способность выполнять сложные инструкции. Введение TRACE как бенчмарка для оценки и улучшения моделей открывает новые возможности для исследований в области машинного обучения и искусственного интеллекта. В будущем ожидается дальнейшее развитие методов, направленных на улучшение понимания и выполнения сложных инструкций LLM, что будет способствовать их более широкому и эффективному применению в различных областях.