LLaVA-o1: Пошаговое рассуждение для моделей видео-языка

В последние годы крупные языковые модели (LLM) показали значительные успехи в области рассуждений, особенно благодаря методам масштабирования в реальном времени, как это демонстрирует модель OpenAI o1. Однако, несмотря на эти достижения, модели видео-языка (VLM) часто сталкиваются с трудностями при выполнении систематического и структурированного рассуждения, особенно в задачах, связанных с сложным визуальным вопросно-ответным взаимодействием. В данной статье мы представим LLaVA-o1, новую VLM, разработанную для автономного многоступенчатого рассуждения.

Модели, такие как OpenAI o1, демонстрируют сильные способности к систематическому и глубокому рассуждению, что подтверждает эффективность масштабирования в реальном времени для языковых моделей. Однако, для полного понимания мира и расширения когнитивных способностей моделей, важно также учитывать визуальную информацию. Следовательно, разработка мультимодальной модели, которая интегрирует язык и зрение, и при этом обеспечивает эффективное систематическое и глубокое рассуждение, имеет огромное значение.

Ранние открытые модели видео-языка в основном использовали прямой подход к предсказанию, генерируя краткие ответы сразу после получения вопроса. Основным ограничением этого подхода является отсутствие структурированного процесса рассуждения, что делает его менее эффективным для задач, требующих логического мышления. Недавние исследования показали, что внедрение метода Chain-of-Thought (CoT) рассуждения значительно улучшает способности модели к ответам на вопросы. Однако даже с применением CoT, большинство VLM часто производят ошибки или генерируют ложные выводы в процессе рассуждения.

LLaVA-o1: Структурированное Рассуждение

LLaVA-o1 предлагает новый подход к рассуждению, который отличается от традиционного метода CoT. Вместо того чтобы просто подсказывать модели думать шаг за шагом, LLaVA-o1 самостоятельно участвует в последовательных этапах суммирования, интерпретации визуальной информации, логического рассуждения и генерации заключений. Этот структурированный подход позволяет LLaVA-o1 значительно улучшить точность на задачах, требующих интенсивного рассуждения.

Сбор данных и обучение модели

Для достижения этой цели мы собрали датасет LLaVA-o1-100k, который включает образцы из различных источников VQA (Visual Question Answering) и предоставляет структурированные аннотации рассуждений. Кроме того, мы предложили метод поиска лучших решений на уровне этапов в реальном времени, который позволяет эффективно масштабировать выводы модели.

Результаты

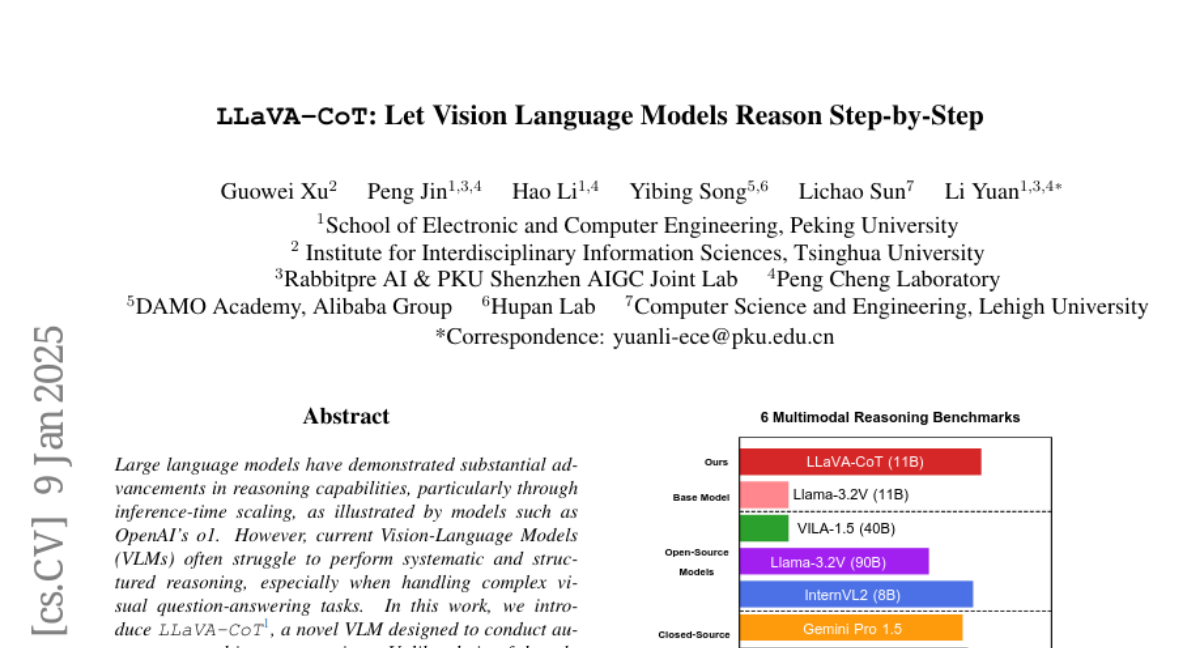

С помощью всего лишь 100 тысяч обучающих образцов и простого, но эффективного метода масштабирования в реальном времени, LLaVA-o1 не только превосходит базовую модель на 8.9% по широкому спектру мультимодальных задач рассуждения, но и обходит по производительности более крупные и даже закрытые модели, такие как Gemini-1.5-pro, GPT-4o-mini и Llama-3.2-90B-Vision-Instruct.

Заключение

LLaVA-o1 устанавливает новый стандарт для мультимодального рассуждения в VLM, предлагая надежную производительность и масштабируемость, особенно в реальном времени. Наша работа открывает путь для дальнейших исследований в области структурированного рассуждения в VLM, включая потенциальное расширение с использованием внешних верификаторов и применение методов обучения с подкреплением для дальнейшего улучшения сложных мультимодальных способностей рассуждения.