MIT-10M: Новый стандарт в области перевода изображений

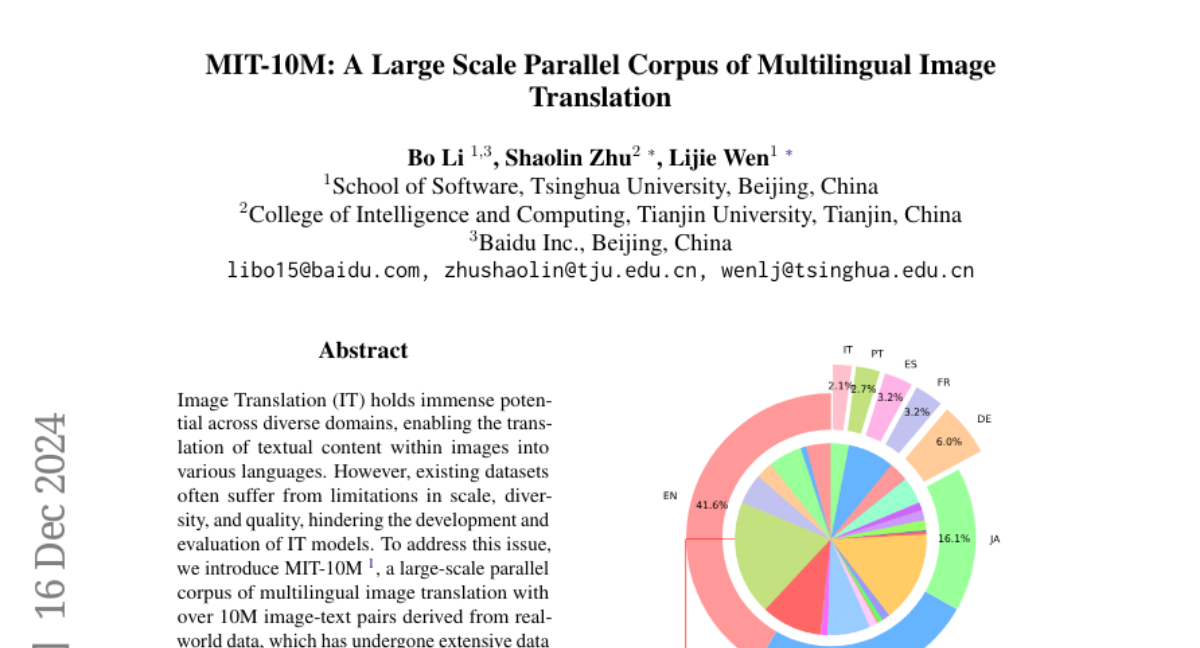

Перевод изображений (IT) обладает огромным потенциалом в различных областях, позволяя переводить текстовое содержание внутри изображений на различные языки. Однако существующие наборы данных часто страдают от ограничений по масштабу, разнообразию и качеству, что препятствует разработке и оценке моделей IT. Чтобы решить эту проблему, мы представляем MIT-10M, крупномасштабный параллельный корпус многоязычного перевода изображений с более чем 10 миллионами пар изображений и текста, полученных из реальных данных, которые прошли тщательную очистку и проверку многоязычного перевода. Он содержит 840 тысяч изображений трех размеров, 28 категорий, задачи с тремя уровнями сложности и 14 языков пар изображений и текста, что является значительным улучшением существующих наборов данных. Мы проводим обширные эксперименты для оценки и обучения моделей на MIT-10M. Экспериментальные результаты ясно показывают, что наш набор данных обладает высокой адаптивностью при оценке производительности моделей в решении сложных задач перевода изображений в реальном мире. Более того, производительность модели, дообученной на MIT-10M, утроилась по сравнению с базовой моделью, что дополнительно подтверждает ее превосходство.