VisionArena: Новая эра взаимодействия пользователей с моделями визуального языка

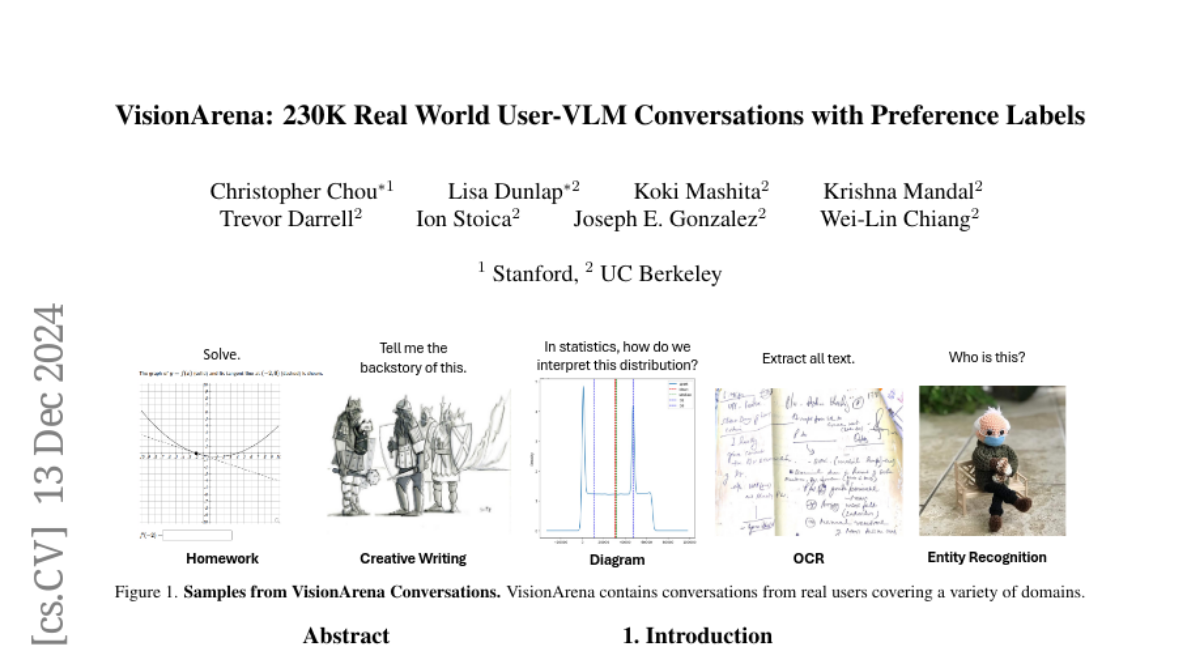

С растущим принятием и возможностями моделей зрения-языка (VLM) возникает необходимость в контрольных показателях, которые отражают аутентичные взаимодействия пользователей с VLM. В ответ мы создаем VisionArena, набор данных из 230K реальных разговоров между пользователями и VLM. Собранный на платформе Chatbot Arena - открытой платформе, где пользователи взаимодействуют с VLM и подают голосование за предпочтения - VisionArena охватывает 73K уникальных пользователей, 45 VLM и 138 языков. Наш набор данных содержит три подсета: VisionArena-Chat, 200K одиночных и многоповоротных разговоров между пользователем и VLM; VisionArena-Battle, 30K разговоров, сравнивающих двух анонимных VLM с голосами предпочтений пользователей; и VisionArena-Bench, автоматическая оценка из 500 различных пользовательских запросов, которые эффективно приближаются к живым рейтингам моделей Chatbot Arena. Кроме того, мы подчеркиваем виды вопросов, задаваемых пользователями, влияние стиля ответов на предпочтения и области, где модели часто терпят неудачу. Мы обнаруживаем, что задачи с открытым окончанием, такие как создание подписей и юмор, сильно зависят от стиля, а текущие VLM испытывают трудности с пространственным мышлением и планированием задач. Наконец, мы показываем, что дообучение той же основной модели на VisionArena-Chat превосходит Llava-Instruct-158K, с увеличением на 17 пунктов в MMMU и на 46 пунктов в оценке WildVision. Набор данных доступен на https://huggingface.co/lmarena-ai.