Масштабирование поиска во время вывода с помощью модели Vision Value для улучшения визуального восприятия

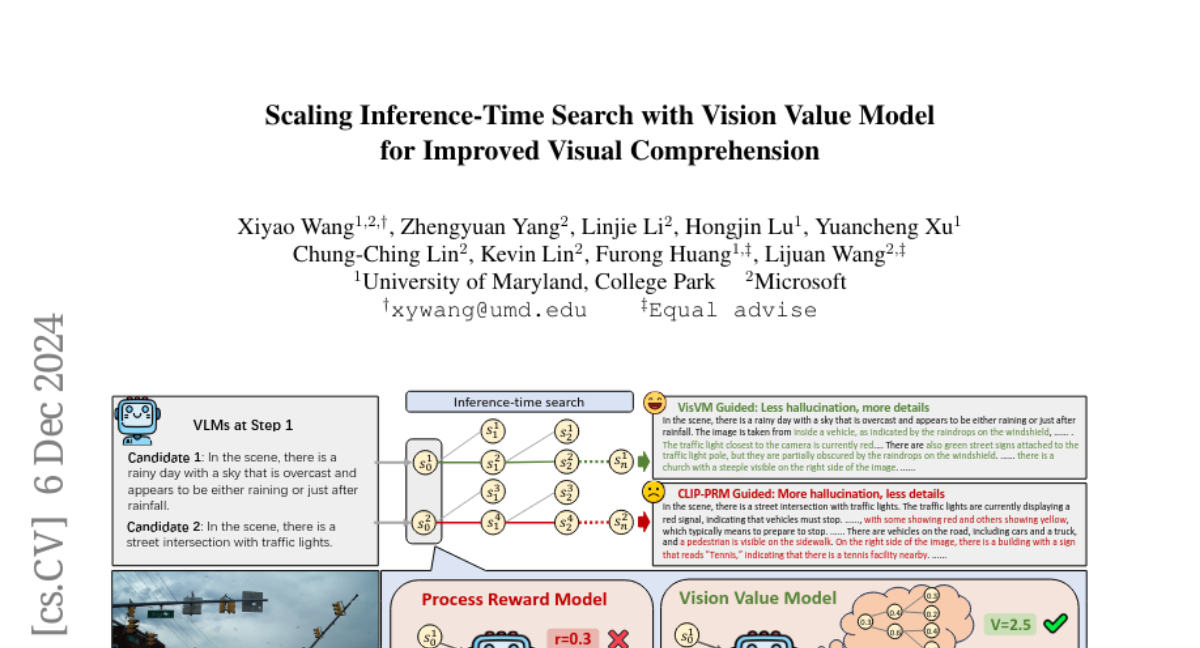

Модели визуального языка (VLMs) достигли значительных успехов в выполнении многомодальных задач, таких как описание изображений и ответ на визуальные вопросы. Эти достижения обусловлены использованием больших наборов данных, состоящих из пар изображений и текстов, и эффективных методов обучения. Однако, несмотря на эти успехи, VLMs по-прежнему сталкиваются с проблемами, связанными с визуальными галлюцинациями и недостаточной детализацией при описании изображений. В данной статье мы представим модель Vision Value Model (VisVM), которая направлена на улучшение качества ответов VLMs за счет оптимизации поиска во время вывода.

Проблема визуальных галлюцинаций

Визуальные галлюцинации возникают, когда модели генерируют информацию, которая не соответствует содержимому изображения. Например, модель может описывать объекты или сцены, которых нет на изображении. Это ограничивает практическое применение VLMs в реальных условиях. Увеличение объема и качества обучающих данных может помочь, но это требует значительных затрат на аннотацию и обработку данных.

Подход к решению проблемы

Мы предлагаем использовать VisVM для оценки качества генерируемых предложений не только на текущем шаге, но и для предсказания качества последующих предложений, что позволяет избежать галлюцинаций и генерировать более детализированные описания. VisVM использует подход обучения с временной разностью (TD learning) для предсказания долгосрочной ценности текущего состояния, что позволяет модели избегать предложений, которые могут привести к галлюцинациям в будущем.

Архитектура Vision Value Model

VisVM основан на двух основных принципах:

-

Долгосрочная оценка: Вместо того чтобы полагаться только на локальную награду текущего предложения, VisVM предсказывает будущие последствия для поддержания согласованности и качества ответа.

-

Учет визуальных концепций: Наградная функция должна учитывать комплексные визуальные концепции, чтобы снизить вероятность галлюцинаций. Для этого мы используем метрику CLIP для оценки сходства между текстом и изображением.

Обучение VisVM

Обучение VisVM включает в себя использование триплетов, состоящих из текущего предложения, следующего предложения и связанного изображения. Мы генерируем разнообразные наборы ответов с помощью VLMs и используем их для обучения VisVM, чтобы точно моделировать долгосрочную ценность предложений.

Поиск во время вывода с использованием VisVM

После обучения VisVM мы используем его в качестве сигнала для управления поиском VLM во время вывода. Мы реализуем температурное декодирование, чтобы обеспечить разнообразие среди кандидатов на ответ на каждом шаге поиска. На каждом шаге поиска мы выбираем предложение с наивысшей оценкой VisVM.

Экспериментальные результаты

Мы провели ряд экспериментов для оценки эффективности VisVM в сравнении с другими методами поиска, такими как жадное декодирование и поиск на основе CLIP. Результаты показали, что поиск, управляемый VisVM, значительно улучшает качество ответов VLMs, снижая количество галлюцинаций и увеличивая детализацию описаний.

Оценка качества ответов

Мы провели оценку качества с использованием человеческих аннотаторов и модели GPT-4. Ответы, сгенерированные с помощью VisVM, были предпочтительнее в 66% случаев по сравнению с другими методами. Это подтверждает, что VisVM способен генерировать более точные и детализированные описания.

Уменьшение визуальных галлюцинаций

Мы также оценили степень визуальных галлюцинаций в сгенерированных ответах. Используя метрики CHAIRS и MMHal, мы обнаружили, что VisVM-управляемый поиск значительно снижает уровень галлюцинаций по сравнению с другими методами.

Самообучение VLMs

Одним из наиболее многообещающих результатов является возможность использования описаний, сгенерированных VisVM, в качестве высококачественных данных для обучения с учителем. Мы провели дообучение VLM на основе данных, сгенерированных VisVM, и получили улучшение производительности на 10.8% по сравнению с базовой моделью.

Заключение

В этой работе мы представили Vision Value Model (VisVM) как эффективный инструмент для улучшения визуального восприятия VLMs. Наши эксперименты показали, что использование VisVM для управления поиском во время вывода приводит к значительному улучшению качества ответов, снижению визуальных галлюцинаций и увеличению детализации описаний. Мы также продемонстрировали потенциал VisVM в качестве компонента для самообучения VLMs, что открывает новые возможности для дальнейшего развития и улучшения многомодальных моделей.