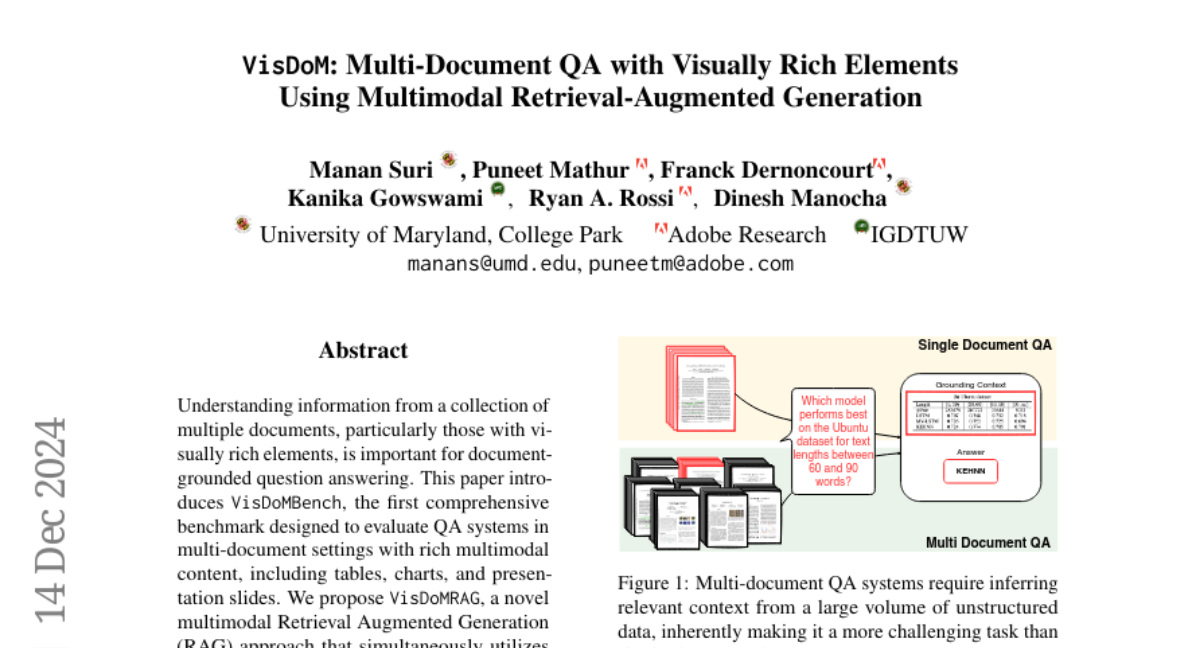

VisDoM: Мультимодальное QA с визуально насыщенными элементами

Понимание информации из коллекции нескольких документов, особенно тех, которые содержат визуально насыщенные элементы, важно для ответа на вопросы, основанные на документах. Эта статья представляет VisDoMBench, первый всесторонний бенчмарк, предназначенный для оценки систем QA в условиях многодокументной среды с богатым мультимодальным контентом, включая таблицы, диаграммы и слайды презентаций. Мы предлагаем VisDoMRAG, новый многомодальный подход к увеличению извлечения (RAG), который одновременно использует визуальное и текстовое RAG, комбинируя надежные возможности визуального извлечения с сложным языковым рассуждением. VisDoMRAG использует многоступенчатый процесс рассуждения, охватывающий отбор доказательств и последовательное рассуждение для параллельных текстовых и визуальных RAG-потоков. Ключевым новшеством VisDoMRAG является его механизм слияния модальностей с ограничениями по согласованности, который согласует процессы рассуждения между модальностями в моментInference для получения связного окончательного ответа. Это приводит к повышенной точности в сценариях, где критическая информация распределена между модальностями, и улучшенной проверяемости ответов за счет неявной атрибуции контекста. Через обширные эксперименты с использованием открытых и проприетарных больших языковых моделей мы оценили современные методы документального QA на VisDoMBench. Обширные результаты показывают, что VisDoMRAG превосходит однородные и длинные контекстные базовые LLM на 12-20% в конце концов многомодального документального QA.