Усиление способностей к мультимодальному рассуждению с помощью оптимизации смешанных предпочтений

В современном мире искусственного интеллекта (AI) и машинного обучения (ML), где большие языковые модели (LLM) становятся все более сложными и мощными, возникает необходимость в моделях, способных не только обрабатывать текст, но и понимать визуальную информацию. Мультимодальные большие языковые модели (MLLMs) представляют собой инновационный подход, объединяющий обработку текста и изображений, что позволяет моделям лучше понимать контекст и выполнять задачи, требующие комплексного анализа. Однако, несмотря на значительные достижения, эти модели сталкиваются с проблемой распределения сдвигов (distribution shifts), что ограничивает их способность к мультимодальному рассуждению, особенно в задачах, связанных с цепочкой рассуждений (Chain-of-Thought, CoT).

С развитием LLM, которые демонстрируют впечатляющие результаты в обработке естественного языка, стало очевидно, что их обучение может быть расширено на мультимодальные данные. Преобладающая парадигма обучения включает в себя предварительное обучение (pre-training) и контролируемую настройку (supervised fine-tuning, SFT), что позволяет моделям адаптироваться к новым задачам. Однако, несмотря на эти усилия, открытые мультимодальные модели все еще демонстрируют ограниченные способности к рассуждению, особенно когда дело доходит до сложных задач, требующих логического мышления и интерпретации визуальных данных.

Проблема распределения сдвигов

Распределение сдвигов между обучением и выводом является ключевой проблемой для MLLMs. Во время обучения модель использует учительское принуждение (teacher forcing), где она предсказывает следующий токен на основе предыдущих истинных токенов. Однако во время вывода модель должна предсказывать каждый токен на основе собственных предыдущих предсказаний, что приводит к сдвигу распределения. Это особенно критично при использовании CoT, где модель должна генерировать длинные обоснования, что усугубляет проблему сдвига распределения, так как модель часто отклоняется от правильного пути рассуждения.

Решение с помощью оптимизации предпочтений

Для решения этой проблемы введена концепция оптимизации предпочтений (Preference Optimization, PO), которая вдохновлена подходами в NLP, направленными на улучшение выравнивания модели с желаемыми шаблонами рассуждений. В частности, метод прямой оптимизации предпочтений (Direct Preference Optimization, DPO) позволяет моделям учиться на сигналах предпочтений, генерируя ответы, которые лучше соответствуют требованиям пользователя. Это заложило основу для использования подкрепления обучения с обратной связью от человека (Reinforcement Learning from Human Feedback, RLHF) в MLLMs, хотя его применение для усиления мультимодального рассуждения остается малоизученным.

Создание данных предпочтений

Чтобы эффективно применить PO, необходимо создать высококачественный набор данных предпочтений. Авторы статьи разработали автоматизированный конвейер для создания данных, который позволяет генерировать MMPR — мультимодальный набор данных предпочтений для рассуждений. Этот набор данных включает примеры с четкими истинными ответами и примеры без них, используя различные стратегии для создания предпочтительных и отвергнутых ответов:

- Dropout Next Token Prediction (DropoutNTP) для примеров без четких истинных ответов, где модель генерирует продолжение без доступа к изображению, что часто приводит к галлюцинациям.

- Correctness-based pipeline для примеров с четкими истинными ответами, где правильные ответы используются как предпочтительные, а неправильные — как отвергнутые.

Mixed Preference Optimization (MPO)

Для усиления мультимодального рассуждения авторы предложили новый метод, названный Mixed Preference Optimization (MPO). Этот метод сочетает в себе потери SFT и различные потери PO, чтобы улучшить эффективность обучения. MPO включает:

- Preference Loss: Используется DPO для обучения модели относительным предпочтениям между парами ответов.

- Quality Loss: Используется BCO (Binary Classifier Optimization) для оценки абсолютного качества отдельных ответов.

- Generation Loss: Используется SFT для обучения модели процессу генерации предпочтительных ответов.

Результаты экспериментов

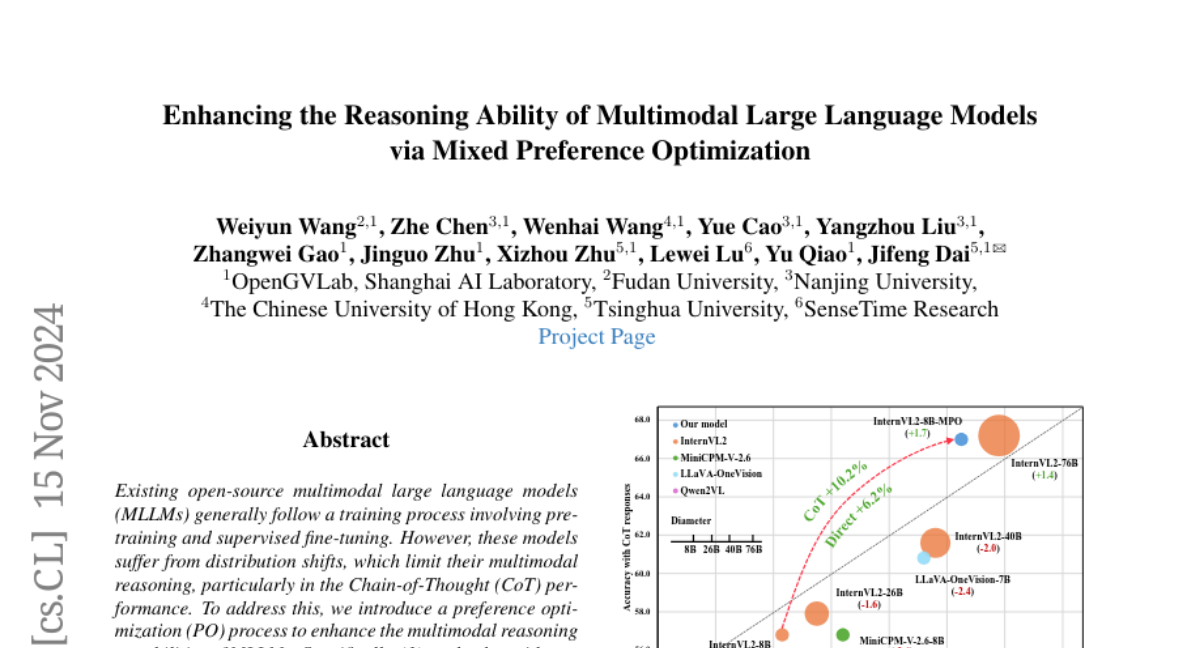

Эксперименты показали, что модель, обученная с использованием MPO, демонстрирует значительное улучшение по сравнению с базовой моделью и моделями, обученными только с использованием SFT. В частности, модель InternVL2-8B-MPO достигла точности 67.0% на бенчмарке MathVista, что на 8.7% выше, чем у InternVL2-8B, и сравнима с производительностью модели в 10 раз большего размера, InternVL2-76B.

Заключение

Исследование показывает, что применение PO и создание специализированных наборов данных для мультимодальных задач могут значительно улучшить способности MLLMs к рассуждению. Это открывает новые горизонты для разработки более интеллектуальных и адаптивных систем, способных понимать и интерпретировать сложные мультимодальные данные. В будущем такие подходы могут быть расширены для решения еще более сложных задач, включая научные исследования, образование и творческие индустрии.