GATE OpenING: Обширный Бенчмарк для Оценки Генерации Интерливированных Изображений и Текста

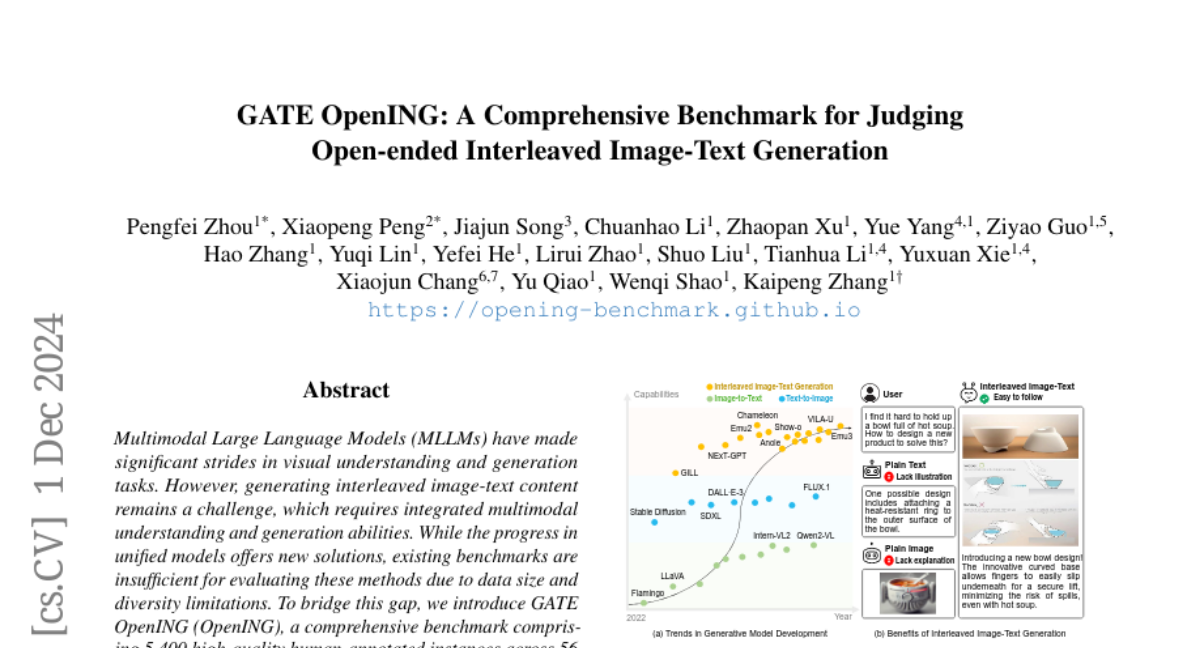

С развитием многомодальных больших языковых моделей (MLLMs) в области визуального восприятия и генерации контента, возникает необходимость в более сложных задачах, таких как интерливированная генерация изображений и текста. Эти задачи требуют интеграции понимания и генерации на нескольких уровнях, что представляет собой значительную проблему для современных моделей. Несмотря на достижения в создании унифицированных моделей, существующие бенчмарки не могут адекватно оценить их возможности из-за ограничений по размеру и разнообразию данных. В этой статье мы представляем GATE OpenING — новый бенчмарк, состоящий из 5400 высококачественных аннотированных примеров, охватывающий 56 реальных задач.

Проблема определения

Задача интерливированной генерации изображений и текста заключается в создании последовательности текстов и изображений на основе заданного запроса. Каждый многомодальный агент получает входной запрос, который может быть текстовым или комбинированным, и генерирует последовательность, состоящую из текстовых сегментов и изображений. Цель состоит в том, чтобы найти оптимальную последовательность, которая соответствует заданным критериям, включая семантическую согласованность и целостность.

Создание данных

Сбор и аннотирование данных для интерливированной генерации изображений и текста — это сложная задача из-за нехватки высококачественных данных и трудностей в согласовании мультимодальных данных из различных источников. Для создания OpenING была разработана эффективная аннотационная система, включающая в себя несколько этапов: концептуализация, сбор данных, аннотирование, фильтрация и обработка. В результате был собран набор данных, состоящий из 5400 аннотированных экземпляров, охватывающий 23 мета-темы и 56 задач.

Аннотационная система

Аннотационная система OpenING включает в себя команду профессиональных аннотаторов, которые работают под контролем экспертов по данным. Каждый экземпляр проходит через несколько этапов проверки, чтобы гарантировать высокое качество аннотаций. В случае нехватки данных, аннотаторы использовали контент, сгенерированный GPT-4 и Stable Diffusion, что также помогло улучшить качество данных.

Инструмент оценки: IntJudge

Для оценки методов открытой интерливированной генерации был представлен IntJudge — модель оценки, которая достигает 82.42% согласия с человеческими оценками. IntJudge был обучен с использованием усовершенствованной аннотационной системы и показывает значительное превосходство над оценками, основанными на GPT, на 11.34%. Это делает IntJudge надежным инструментом для оценки качества интерливированной генерации.

Архитектура IntJudge

IntJudge использует подход, называемый Reference-Augmented Generation (RAG), который позволяет масштабировать набор данных для обучения. Модель обучается на комбинации аннотированных парных данных и данных RAG, что позволяет достичь высокой точности и согласованности в оценках.

Эксперименты и результаты

В рамках OpenING были проведены обширные эксперименты с использованием различных методов интерливированной генерации. Результаты показали, что текущие методы все еще имеют значительные недостатки в качестве и согласованности контента. Основные выводы включают:

- Генерация последовательного и высокого качества интерливированного контента остается сложной задачей для всех моделей.

- Интегрированные пайплайны, такие как Gemini+Flux, показывают лучшие результаты по сравнению с энд-то-энд моделями.

- Генерация текстов с помощью GPT может быть более информативной, чем аннотированные ответы, однако аннотированные изображения все еще предпочтительнее для генерации изображений.

Оценка моделей

В ходе экспериментов были протестированы 10 различных методов генерации, которые были разделены на три категории: интегрированные пайплайны, двухступенчатые генераторы и энд-то-энд генераторы. Результаты оценивались по нескольким критериям, включая качество, согласованность и соответствие.

Выводы

OpenING представляет собой значительный шаг вперед в области оценки интерливированной генерации изображений и текста. Он преодолевает ограничения существующих бенчмарков, предлагая более разнообразные данные и задачи. Введение модели IntJudge позволяет более точно оценивать качество генерации, что в свою очередь способствует дальнейшему развитию многомодальных моделей.

Перспективы

В будущем необходимо увеличить размер и разнообразие наборов данных, что позволит улучшить практическую значимость бенчмарков для интерливированной генерации. Ожидается, что OpenING вдохновит дальнейшие исследования в области MLLMs и поддержит развитие моделей оценки для мультимодальной генерации.