AV-OdysseyBench: Понимают ли ваши мультимодальные LLM действительно аудиовизуальную информацию?

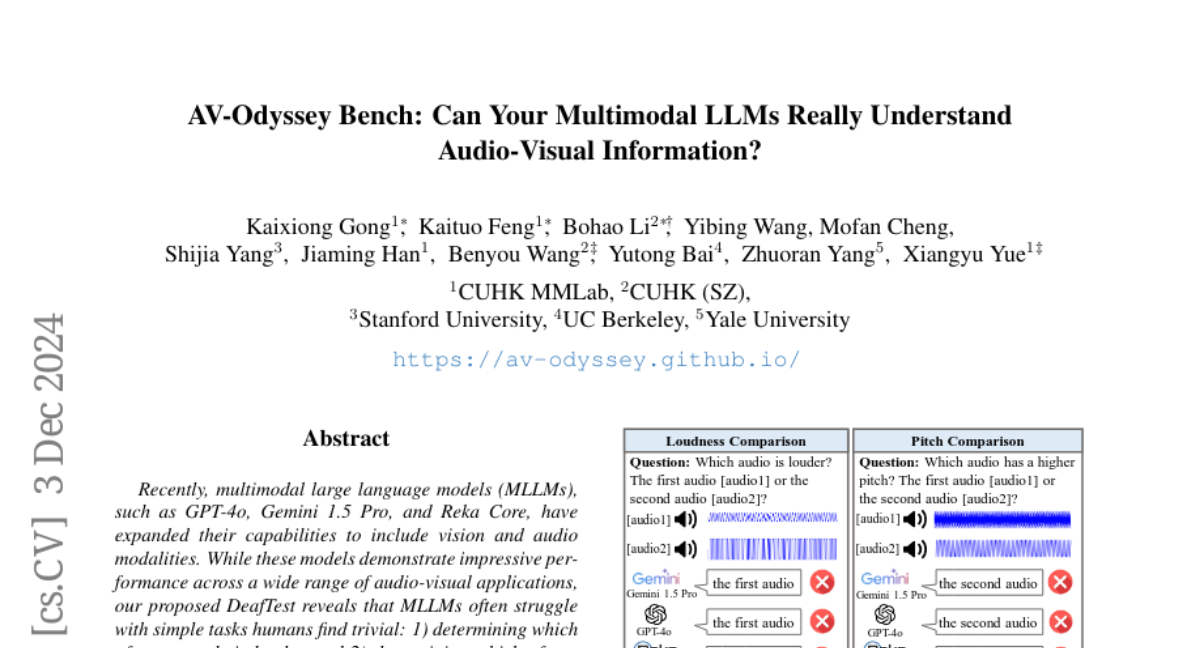

Совсем недавно мультимодальные большие языковые модели (MLLM), такие как GPT-4o, Gemini 1.5 Pro и Reka Core, значительно расширили свои возможности, включая в себя визуальные и аудиомодальности. Эти модели демонстрируют впечатляющие результаты в различных аудиовизуальных приложениях. Однако, как показывает наш тест DeafTest, MLLM часто сталкиваются с трудностями при выполнении простых задач, которые для человека кажутся тривиальными, например, определение, какой из двух звуков громче, или какой звук имеет более высокий тон.

Вдохновленные этими наблюдениями, мы представляем AV-Odyssey Bench — обширную аудиовизуальную платформу для оценки способности MLLM действительно понимать аудиовизуальную информацию. Этот бенчмарк охватывает 4555 тщательно разработанных задач, каждая из которых включает текстовые, визуальные и аудиокомпоненты. Для успешного вывода ответов модели должны эффективно использовать подсказки как из визуальных, так и из аудиовходов.

Мультимодальные большие языковые модели

Мультимодальные большие языковые модели представляют собой новый этап в развитии искусственного интеллекта. Они объединяют текстовые, визуальные и аудиоданные, что позволяет им решать более сложные задачи, чем традиционные модели, которые работают только с одним типом данных. Например, Vision-Language Models (VLM) уже продемонстрировали свои возможности в области визуального восприятия и могут выполнять такие задачи, как подсчет объектов на изображениях, решение геометрических задач и обработка табличных данных.

С добавлением аудиомодальности, такие модели, как GPT-4o и Gemini 1.5, расширили свои горизонты, что дало возможность решать задачи, связанные с автоматическим распознаванием речи (ASR), автоматическим переводом речи (AST) и аудиовизуальным аннотированием. Однако большинство предыдущих мультимодальных бенчмарков сосредоточены на визуальном решении задач, что приводит к недостаточной оценке аудиовизуального понимания.

DeafTest и его значение

Чтобы оценить базовые аудиовосприятия MLLM, мы разработали DeafTest — набор из четырех простых аудиозадач. Эти задачи включают:

- Подсчет количества звуков.

- Сравнение громкости двух звуков.

- Сравнение высоты звуков.

- Сравнение длительности звуков.

Наша гипотеза заключалась в том, что MLLM могут не справляться с этими базовыми задачами в силу своих тренировочных целей, которые в основном сосредоточены на высокоуровневом семантическом соответствии между различными модальностями.

Результаты тестирования показали, что, несмотря на способность распознавать сложный речевой контент, MLLM не достигают ожидаемых результатов в задачах подсчета звуков. Лучший результат среди протестированных моделей составил лишь 81%, в то время как люди могут легко достичь 100%. Более того, модели оказались нечувствительными к громкости звуков, что также указывает на их ограничения.

AV-Odyssey Bench: Структура и задачи

AV-Odyssey Bench — это всеобъемлющий аудиовизуальный бенчмарк, разработанный для проверки MLLM на способности интегрировать информацию из различных модальностей. Он включает 4555 вопросов, охватывающих 26 различных задач, каждая из которых построена с учетом трех критических компонентов: текста, изображения/видео и аудиоклипа.

Основные характеристики AV-Odyssey Bench:

- Комплексные аудиохарактеристики: Бенчмарк охватывает широкий спектр звуковых атрибутов, включая тембр, тон, пространственные характеристики и временные динамики.

- Широкие домены: Задачи охватывают разнообразные области, такие как музыка, повседневная жизнь и транспорт.

- Переплетенные текстовые, аудиальные и визуальные компоненты: Все входные данные подаются в MLLM в переплетенном формате, что позволяет моделям более эффективно интегрировать информацию.

Задачи AV-Odyssey Bench

Задачи в AV-Odyssey Bench делятся на несколько категорий, включая:

- Задачи на тембр: Соответствие аудиовизуальных пар (например, звук рыка льва и изображения льва).

- Задачи на тон: Оценка анализа настроений речи и понимания мемов.

- Задачи на мелодию: Оценка понимания мелодии и соответствия музыки и танца.

- Пространственные задачи: Оценка способности MLLM определять расстояние до источника звука или 3D-угол.

- Временные задачи: Оценка временной корреляции между аудиовходами и визуальной информацией.

- Задачи на галлюцинацию: Оценка проблемы галлюцинации в аудиовизуальном рассуждении.

- Сложные задачи: Задачи, требующие интегрированного анализа и рассуждения на основе как визуальных, так и аудиовходов.

Процесс сбора данных и контроль качества

Для создания AV-Odyssey Bench мы использовали два основных подхода:

- Сбор данных: Мы собрали аудиоклипы из открытых наборов данных и соответствующие визуальные данные из интернета для автоматической генерации вопросов и вариантов ответов. Человеческие эксперты провели пост-оценку и отфильтровали низкокачественные вопросы.

- Контроль качества: Мы проверили все отобранные вопросы с помощью моделей VLM и аудио-LLM, чтобы убедиться, что они не могут быть решены с помощью одноканальных подходов.

Результаты и анализ

В результате тестирования MLLM на AV-Odyssey Bench мы сделали несколько ключевых выводов:

- Ограниченные способности MLLM: В целом, текущие MLLM все еще не способны эффективно обрабатывать сложные задачи интеграции аудиовизуальной информации.

- Нехватка базовых аудиовосприятий: Модели продемонстрировали слабые результаты в задачах, связанных с базовыми аудиовосприятиями, что может препятствовать их способности интегрировать аудиовизуальную информацию.

- Различия между закрытыми и открытыми моделями: Разрыв между производительностью закрытых и открытых моделей оказался относительно небольшим, что подтверждает сложность задач в AV-Odyssey Bench.

Заключение

В этой работе мы представили AV-Odyssey Bench как комплексный инструмент для оценки возможностей MLLM в понимании аудиовизуальной информации. Мы выявили текущие ограничения MLLM и надеемся, что AV-Odyssey Bench станет ценным ресурсом для сообщества, способствуя развитию MLLM и в конечном итоге приведет к созданию более мощных и человечных систем аудиовизуального понимания.