AV-OdysseyBench: Понимают ли ваши мультимодальные LLM действительно аудиовизуальную информацию?

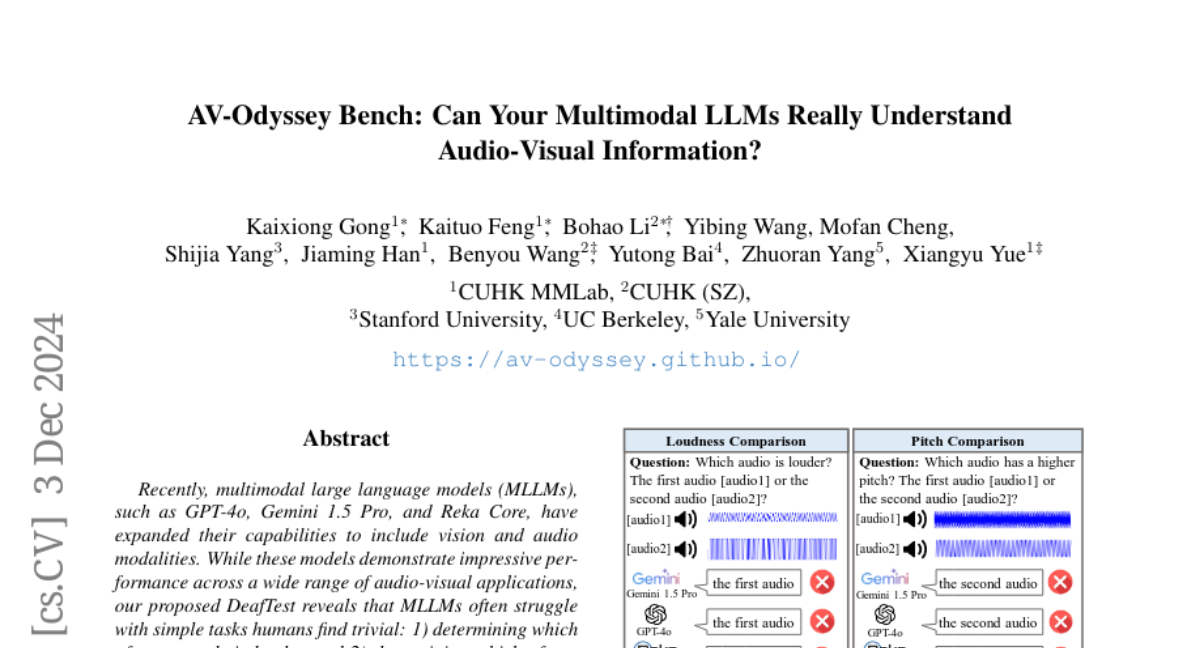

Недавно мультимодальные большие языковые модели (MLLM), такие как GPT-4o, Gemini 1.5 Pro и Reka Core, расширили свои возможности, включая визуальные и аудиомодальности. Хотя эти модели демонстрируют впечатляющие результаты в широком спектре аудиовизуальных приложений, наш предложенный DeafTest показывает, что MLLM часто испытывают трудности с простыми задачами, которые люди считают тривиальными: 1) определить, какой из двух звуков громче, и 2) определить, какой из двух звуков имеет более высокий тон. Мотивированные этими наблюдениями, мы представляем AV-Odyssey Bench, комплексный аудиовизуальный бенчмарк, разработанный для оценки способности MLLM действительно понимать аудиовизуальную информацию. Этот бенчмарк включает 4555 тщательно разработанных задач, каждая из которых включает текстовые, визуальные и аудиокомпоненты. Для успешного вывода ответов модели должны эффективно использовать подсказки как из визуальных, так и из аудиовходов. Чтобы обеспечить точную и объективную оценку ответов MLLM, мы структурировали вопросы в формате множественного выбора, что устраняет необходимость в человеческой оценке или оценке с помощью LLM. Мы оцениваем ряд закрытых и открытых моделей и суммируем наблюдения. Раскрывая ограничения текущих моделей, мы стремимся предоставить полезную информацию для будущего сбора данных и разработки моделей.