Символическая Оптимизация Предпочтений с Демонстрациями (SymDPO): Усиление Контекстно-Ориентированного Обучения Мультимодальных Моделей

С развитием языковых моделей (LLM) и их способностью к обучению в контексте (ICL), исследователи начали адаптировать эти методы для создания крупных мультимодальных моделей (LMM), которые могут эффективно обучаться на нескольких модальностях данных, таких как текст и изображения. Однако, несмотря на прогресс, существующие LMM часто не могут адекватно использовать визуальный контекст в демонстрациях, предпочитая следовать текстовым шаблонам. Это явление, известное как "пренебрежение визуальным контекстом", ограничивает их способность к полноценному мультимодальному обучению.

В этой статье мы представляем метод Символической Оптимизации Предпочтений с Демонстрациями (SymDPO), который направлен на решение проблемы пренебрежения визуальным контекстом в LMM. SymDPO использует символы для замены текстовых ответов в демонстрациях, заставляя модели более внимательно анализировать визуальные элементы и устанавливать связи между изображениями и символами, что способствует более глубокому пониманию мультимодального контекста.

Проблема Пренебрежения Визуальным Контекстом

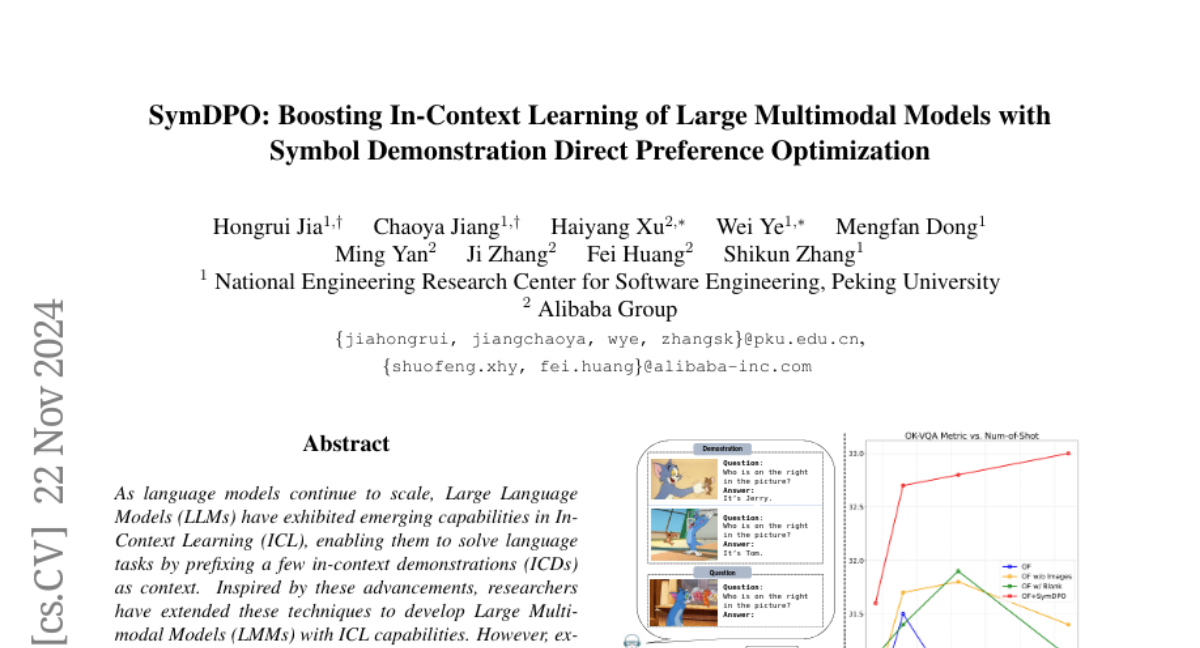

LMM, несмотря на их потенциал, часто не могут эффективно интегрировать визуальную информацию из демонстраций. Это приводит к тому, что модели генерируют ответы, основываясь в основном на текстовых шаблонах, игнорируя критически важную визуальную информацию. Например, как показано на рисунке 1, модель OpenFlamingo неправильно отвечает на вопрос, кто находится справа на изображении, следуя текстовым подсказкам, а не визуальному контексту.

Символическая Оптимизация Предпочтений с Демонстрациями (SymDPO)

Основные Принципы

SymDPO предлагает новый подход к оптимизации предпочтений, заменяя текстовые ответы в демонстрациях на символы, которые не имеют семантического значения в контексте вопроса. Это вынуждает модель искать ответы, основываясь на визуальной информации, а не на текстовых шаблонах. В результате, модель должна интерпретировать изображения и связывать их с символами для правильного ответа.

Конструкция Датасета

Для создания датасета SymDPO используется следующий процесс:

- Сбор данных: Собираются пары изображений и вопросов-ответов из различных VQA датасетов.

- Формирование ICL формата: Вопросы группируются по типам задач, и для каждой группы создаются демонстрации в формате ICL.

- Замена ответов на символы: В демонстрациях ответы заменяются на символы, не имеющие семантического значения.

Примеры и Результаты

На рисунке 2 показано сравнение стандартного подхода DPO и SymDPO. В SymDPO ответы заменяются на символы, что требует от модели глубокого понимания визуального контекста для правильного ответа. Эксперименты показали, что SymDPO значительно улучшает понимание мультимодального контекста, как видно из улучшений в различных бенчмарках, таких как COCO Caption, Flickr-30K и VQAv2.

Эксперименты и Результаты

Настройки Экспериментов

Мы использовали модели Open-Flamingo и IDEFICS для оценки эффективности SymDPO. Модели обучались на датасетах, содержащих 872,000 элементов, с выборкой 10,000 для обучения. Использовался метод линейного аннеалинга для настройки скорости обучения, и обучение проводилось на 8 NVIDIA A100 GPU.

Основные Результаты

SymDPO показал значительное улучшение по сравнению с другими методами DPO, такими как VideoDPO и MIA-DPO. Например, на бенчмарке COCO Caption модель Open-Flamingo с SymDPO достигла CIDEr 93.8, что на 4.8 балла выше, чем базовая модель.

Абляционные Исследования

Эффективность SymDPO

Сравнение SymDPO с общим подходом DPO показало, что SymDPO значительно улучшает производительность моделей, подтверждая важность символической замены ответов.

Исследование Пренебрежения Визуальным Контекстом

Удаление изображений из демонстраций привело к значительному снижению производительности моделей, обученных с SymDPO, что подтверждает, что улучшения связаны с лучшим использованием визуальной информации.

SymDPO vs. Символическая Настройка

Сравнение с методом символической настройки (SymTune) показало, что SymDPO превосходит его по всем бенчмаркам, что объясняется более эффективным использованием предпочтений в обучении.

Интеграция SymDPO и Общего DPO

Исследование различных пропорций SymDPO и общего DPO в обучающем датасете показало, что оптимальное соотношение составляет около 70% символических данных для большинства задач, обеспечивая наилучшую производительность.

Заключение

SymDPO предлагает мощный подход к улучшению мультимодального обучения, заставляя модели более эффективно использовать визуальный контекст. Эксперименты подтверждают, что SymDPO способствует значительным улучшениям в понимании и использовании мультимодальной информации, делая LMM более контекстно-ориентированными и способными к более точному ответу на вопросы в мультимодальных сценариях.