LLM2CLIP: Как мощные языковые модели улучшают визуальные представления

В последние годы мультимодальные модели, такие как CLIP, стали неотъемлемой частью машинного обучения, предоставляя возможность взаимодействия между визуальными и текстовыми данными. CLIP, разработанный OpenAI, использует контрастивное обучение для выравнивания изображений и текстов в общем пространстве признаков, что позволяет выполнять множество задач, включая классификацию без обучения, обнаружение объектов, сегментацию и кросс-модальное восстановление. Однако, несмотря на свои впечатляющие возможности, CLIP имеет ограничения, особенно в обработке длинных и сложных текстов.

Проблемы и ограничения CLIP

CLIP, хотя и мощный, страдает от следующих ограничений:

- Ограниченная длина текста: CLIP может обрабатывать только 77 токенов, что делает его неспособным к эффективной обработке длинных текстов.

- Ограниченное понимание контекста: Текстовый энкодер CLIP не обладает глубоким пониманием контекста, что ограничивает его способность к интерпретации сложных описаний изображений.

- Отсутствие открытого знания: CLIP не обладает знаниями об общем мире, что снижает его способность к инференции и пониманию за пределами обучающих данных.

Введение LLM2CLIP

LLM2CLIP представляет собой новый подход к улучшению CLIP с помощью крупных языковых моделей (LLMs). Основная идея заключается в том, чтобы использовать мощные возможности LLM для улучшения текстового энкодера CLIP, что позволяет:

- Обработка длинных текстов: LLM могут обрабатывать гораздо более длинные тексты, чем CLIP, что расширяет возможности модели.

- Улучшение понимания контекста: Благодаря своей обученной на огромных объемах данных архитектуре, LLM предоставляют более глубокое понимание языка и контекста.

- Интеграция открытого знания: LLM обладают обширными знаниями об общем мире, что позволяет им добавлять дополнительную информацию в процесс обучения CLIP.

Основные этапы LLM2CLIP:

-

Фин-тьюнинг LLM: LLM настраивается на контрастивное обучение с использованием изображений и их описаний, чтобы улучшить дискриминативность выходных признаков.

-

Использование LLM как учителя: Настроенный LLM используется как учитель для визуального энкодера CLIP, обучая его на более богатых и сложных текстовых данных.

-

Эффективное обучение: Обучение LLM2CLIP проводится таким образом, чтобы минимизировать дополнительные затраты на вычисления, сохраняя при этом высокую эффективность.

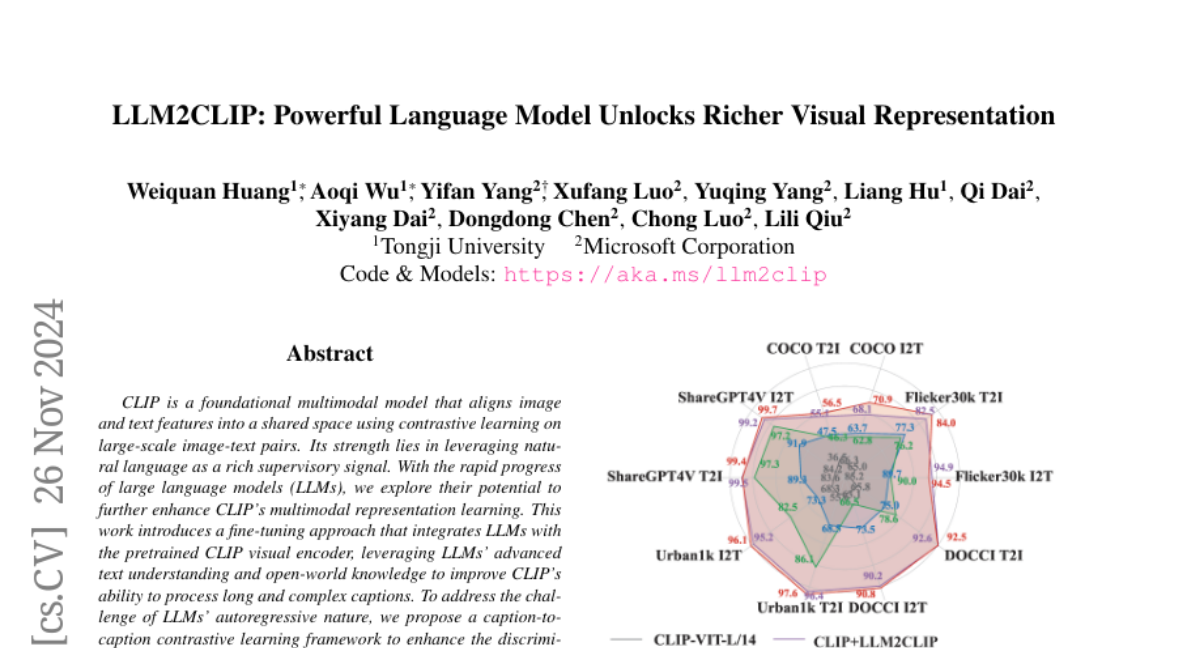

Эксперименты и результаты

Эксперименты показали, что LLM2CLIP значительно улучшает производительность CLIP:

- Повышение точности: На задачах восстановления текста и изображений LLM2CLIP показал улучшение на 16.5% по сравнению с предыдущими моделями.

- Кросс-языковые возможности: Благодаря знаниям LLM, CLIP, обученный только на английском, смог эффективно работать с китайскими текстами, что подчеркивает способность LLM передавать знания между языками.

- Мультимодальные задачи: При интеграции в модели, такие как Llava 1.5, LLM2CLIP последовательно превосходил оригинальный CLIP по большинству метрик.

Заключение

LLM2CLIP открывает новые горизонты в мультимодальном обучении, демонстрируя, как интеграция крупных языковых моделей может значительно улучшить визуальные представления и расширить возможности существующих моделей. Этот подход не только улучшает понимание длинных текстов, но и позволяет моделям использовать обширное знание мира, что делает их более универсальными и эффективными для широкого спектра задач. В будущем LLM2CLIP может стать основой для создания еще более мощных мультимодальных систем, способных к более глубокому пониманию и взаимодействию между различными формами данных.