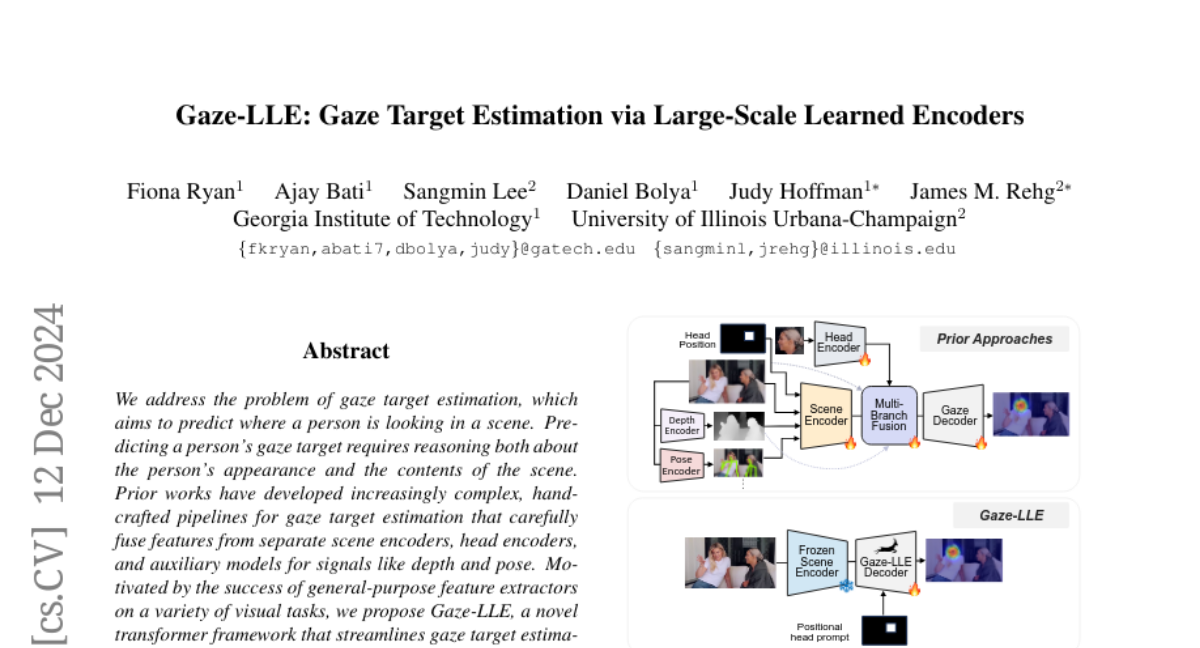

Gaze-LLE: Эффективная оценка целевого взгляда с помощью крупномасштабных обученных энкодеров

Мы рассматриваем проблему оценки целевого взгляда, которая направлена на предсказание того, куда смотрит человек в сцене. Для предсказания целевого взгляда человека требуется рассуждение как о внешнем виде человека, так и о содержании сцены. Ранее разработанные работы создали все более сложные ручные схемы для оценки целевого взгляда, которые тщательно объединяют признаки из различных кодировщиков сцен, кодировщиков головы и вспомогательных моделей для сигналов, таких как глубина и положение. Побуждаемые успехом универсальных экстракторов признаков в различных визуальных задачах, мы предлагаем Gaze-LLE — новую трансформерную структуру, которая упрощает оценку целевого взгляда, используя признаки из замороженного DINOv2 кодировщика. Мы извлекаем одно представление признака для сцены и применяем специфичный для человека позиционный запрос для декодирования взгляда с помощью легковесного модуля. Мы демонстрируем передовые достижения в нескольких бенчмарках по оценке взгляда и предоставляем обширный анализ для проверки наших проектных решений. Наш код доступен по адресу: http://github.com/fkryan/gazelle .