ITACLIP: Совершенствование обучения без учителя для семантической сегментации

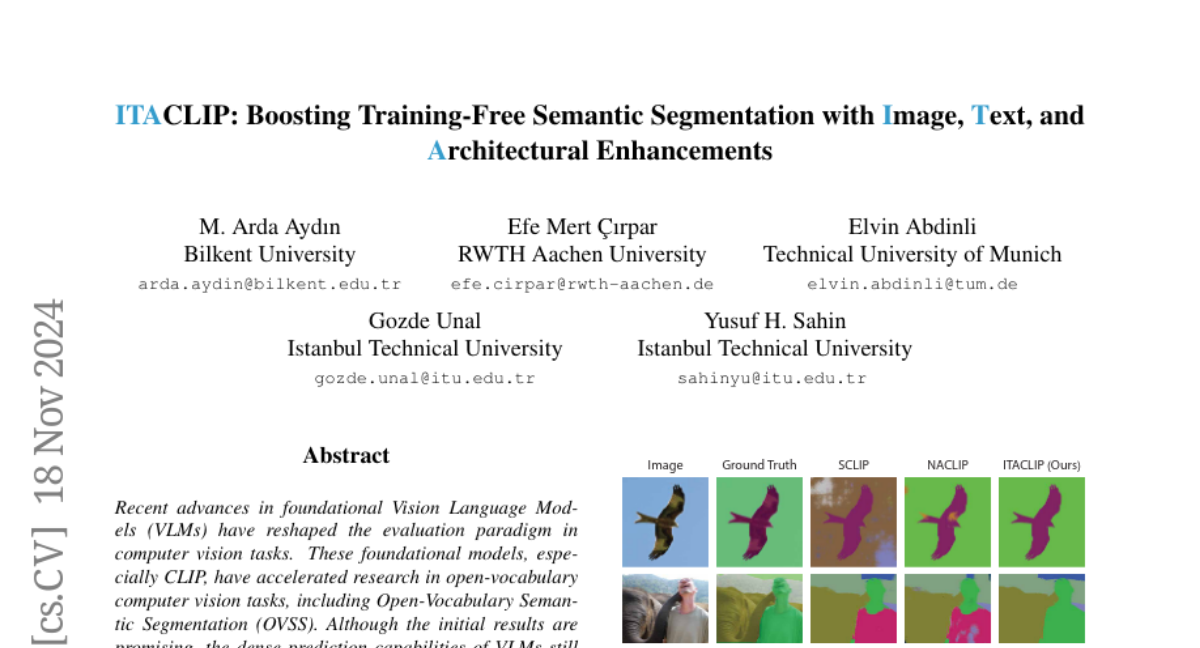

Недавние достижения в области фундаментальных моделей языка и зрения (VLMs) изменили парадигму оценки в задачах компьютерного зрения. Эти фундаментальные модели, особенно CLIP, ускорили исследования в области открытого словаря задач компьютерного зрения, включая семантическую сегментацию с открытым словарём (OVSS). Хотя первоначальные результаты обнадёживают, возможности плотного предсказания VLMs всё ещё требуют дальнейшего улучшения. В этом исследовании мы повышаем производительность семантической сегментации CLIP за счёт введения новых модулей и модификаций: 1) Архитектурные изменения в последнем слое ViT и включение карт внимания из средних слоёв вместе с последним слоем. 2) Инженерия изображений: применение аугментации данных для обогащения представлений входных изображений. 3) Использование больших языковых моделей (LLMs) для генерации определений и синонимов для каждого названия класса, чтобы использовать возможности CLIP с открытым словарём. Наш метод без обучения, ITACLIP, превосходит текущие лучшие подходы на бенчмарках сегментации, таких как COCO-Stuff, COCO-Object, Pascal Context и Pascal VOC. Наш код доступен по адресу: https://github.com/m-arda-aydn/ITACLIP.