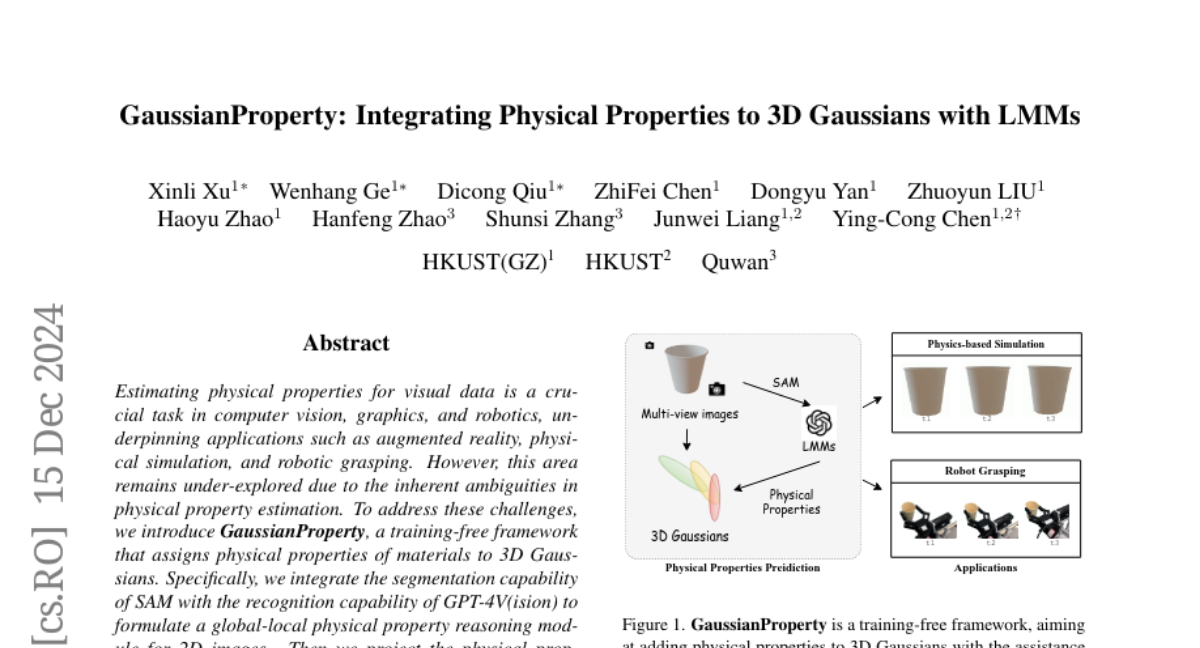

GaussianProperty: Интеграция физических свойств в 3D Гауссианы с помощью LMM

Оценка физических свойств для визуальных данных является важной задачей в области компьютерного зрения, графики и робототехники, которая лежит в основе таких приложений, как дополненная реальность, физическое моделирование и захват объектов роботами. Тем не менее, эта область остается недостаточно исследованной из-за врожденных неопределенностей в оценке физических свойств. Чтобы справиться с этими проблемами, мы представляем GaussianProperty, безтренировочную структуру, которая задает физические свойства материалов для 3D-гауссианов. В частности, мы интегрируем возможности сегментации SAM с возможностью распознавания GPT-4V(ision) для формирования глобально-локального модуля рассуждений о физических свойствах для 2D-изображений. Затем мы проецируем физические свойства из многослойных 2D-изображений на 3D-гауссианы, используя стратегию голосования. Мы демонстрируем, что 3D-гауссианы с аннотациями физических свойств позволяют применять в физическом динамическом моделировании и захвате объектов роботами. Для физического динамического моделирования мы используем метод точечных материалов (MPM) для реалистичного динамического моделирования. Для захвата объектов роботами мы разрабатываем стратегию прогнозирования силы захвата, которая оценивает безопасный диапазон сил, необходимых для захвата объекта на основе оцененных физических свойств. Широкие эксперименты по сегментации материалов, физическому динамическому моделированию и захвату объектов роботами подтверждают эффективность нашего предлагаемого метода, подчеркивая его важную роль в понимании физических свойств из визуальных данных. Онлайн-демо, код, больше кейсов и аннотированные наборы данных доступны на https://Gaussian-Property.github.io.