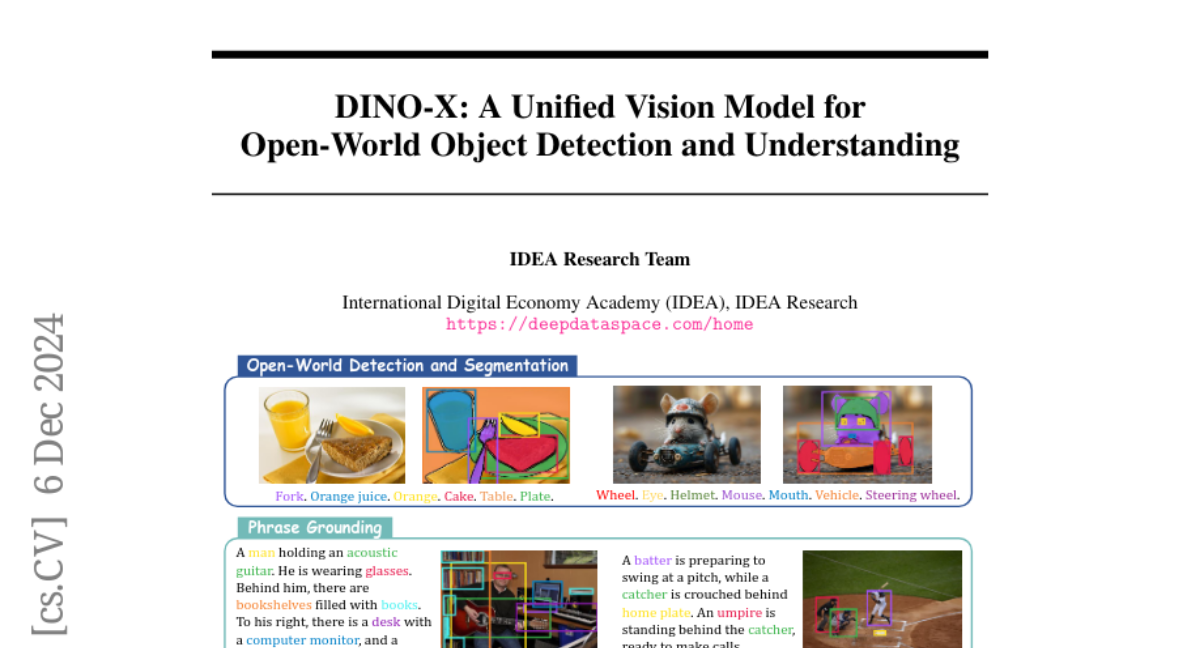

DINO-X: Объединённая модель для открытого мира объектного распознавания и понимания

В последние годы объектное распознавание переживает значительный прогресс, переходя от моделей с закрытым набором к моделям с открытым набором, способным идентифицировать объекты по заданным пользователем подсказкам. Такие модели находят применение в различных областях, от робототехники до автономных транспортных средств, улучшая их адаптивность и восприятие окружающего мира. В данной статье мы представляем DINO-X, разработанную IDEA Research, как новую вершину в области открытого мира объектного распознавания и понимания.

DINO-X использует архитектуру кодировщика-декодера на основе Transformer, аналогичную Grounding DINO 1.5, и предоставляет уникальную возможность обнаружения объектов без необходимости в подсказках, а также поддерживает множество задач восприятия и понимания объектов.

Основные концепции DINO-X

Архитектура модели

DINO-X включает в себя два варианта: Pro и Edge. DINO-X Pro предлагает расширенные возможности восприятия для различных сценариев, в то время как DINO-X Edge оптимизирован для быстрого вывода и лучше подходит для развертывания на устройствах с ограниченными ресурсами.

DINO-X Pro

-

Текстовые подсказки: Используется предобученная модель CLIP для кодирования текстовых подсказок, что обеспечивает лучшую эффективность и производительность при обучении на различных открытых бенчмарках.

-

Визуальные подсказки: Модель поддерживает визуальные подсказки, используя методы из T-Rex2, позволяя пользователям указывать объекты через визуальные примеры.

-

Кастомизированные подсказки: Введение кастомизированных подсказок позволяет модели адаптироваться к специфическим сценариям, таким как обнаружение объектов в узкоспециализированных областях или выполнение конкретных функций.

DINO-X Edge

-

Эффективность: Использует EfficientViT в качестве основы для эффективного извлечения признаков и интегрирует архитектуру кодировщика-декодера Transformer для ускорения вывода.

-

Дистилляция знаний: Знания из модели Pro передаются модели Edge через дистилляцию, что позволяет достичь высоких результатов при меньших вычислительных затратах.

Многофункциональные головы

DINO-X не ограничивается только обнаружением объектов, но также поддерживает:

-

Box Head: для предсказания координат ограничивающих рамок объектов.

-

Mask Head: для генерации масок сегментации объектов.

-

Keypoint Head: для определения ключевых точек объектов, таких как позы человека или рук.

-

Language Head: для генерации описательных подписей к объектам и ответов на вопросы, связанные с объектами.

Поддержка открытого мира

DINO-X разработана для работы в открытом мире, где объекты могут быть обнаружены без предварительно заданных категорий. Это достигается за счет:

- Универсальной объектной подсказки: Поддержка обнаружения любых объектов в изображении без необходимости в предоставлении подсказок пользователем.

Датасет и обучение модели

Для улучшения способности модели к открытому словарному обнаружению был создан датасет Grounding-100M, содержащий более 100 миллионов высококачественных образцов. Обучение на таком масштабном датасете позволило DINO-X получить фундаментальное представление на уровне объектов, что обеспечивает возможность интеграции различных голов восприятия для выполнения множества задач.

Результаты и сравнения

DINO-X Pro демонстрирует превосходные результаты на бенчмарках COCO, LVIS-minival и LVIS-val, особенно выделяясь в обнаружении редких классов объектов. Модель Edge также показывает высокую производительность при значительном ускорении вывода, что делает её пригодной для использования на устройствах с ограниченными ресурсами.

Заключение

DINO-X представляет собой значительный шаг вперед в области объектного распознавания и понимания, предлагая универсальную платформу, способную выполнять множество задач без необходимости в специфических подсказках. Это открывает новые горизонты для применения в реальном мире, где точность и универсальность являются ключевыми факторами.