ITACLIP: Совершенствование обучения без учителя для семантической сегментации

В последние годы в области компьютерного зрения произошли значительные изменения, благодаря появлению фундаментальных моделей, таких как CLIP (Contrastive Language-Image Pre-Training). Эти модели, обученные на огромных наборах данных изображений и текстов, демонстрируют впечатляющие результаты в различных задачах, включая открытую семантическую сегментацию (Open-Vocabulary Semantic Segmentation, OVSS). Однако, несмотря на их успех в классификации изображений, их способность к плотным предсказаниям, необходимым для сегментации, требует дальнейшего улучшения.

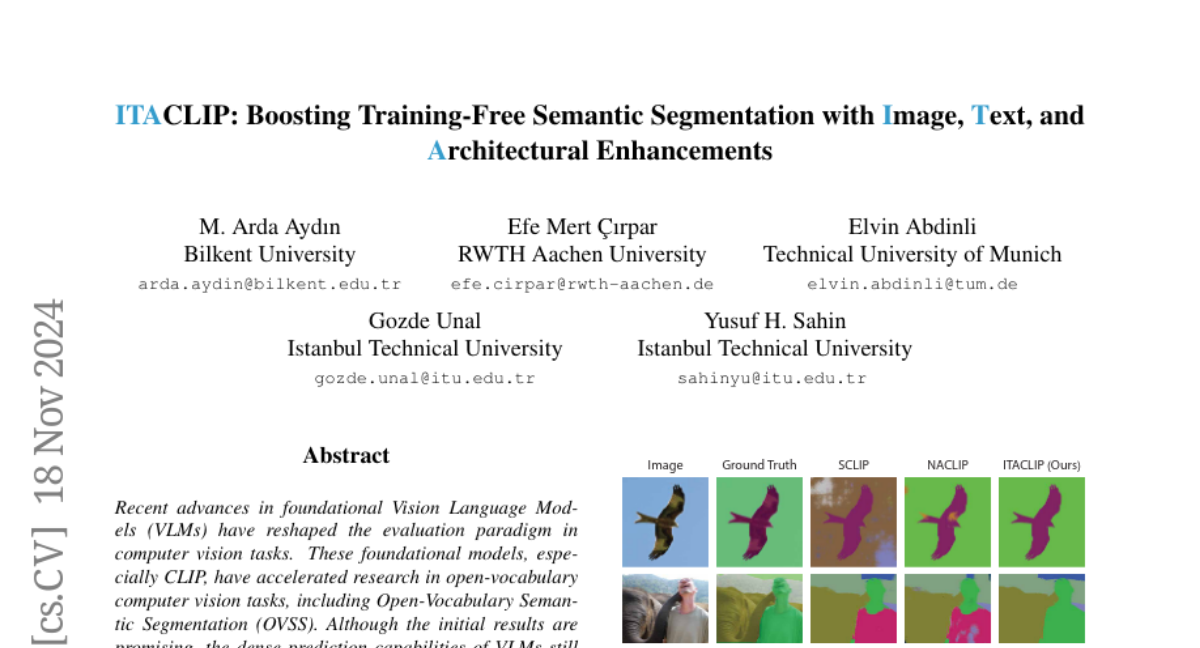

В этом исследовании мы представляем ITACLIP — метод, который улучшает способности CLIP к семантической сегментации без дополнительного обучения. ITACLIP включает в себя три основных компонента:

- Архитектурные изменения в последнем слое ViT (Vision Transformer) и интеграцию карт внимания из средних слоев с последним слоем.

- Инженерия изображений с использованием аугментаций данных для обогащения входных изображений.

- Использование LLM (Large Language Models) для генерации определений и синонимов для каждого класса, что позволяет использовать возможности CLIP для работы с открытым словарём.

Наш подход превосходит текущие методы на таких бенчмарках, как COCO-Stuff, COCO-Object, Pascal Context и Pascal VOC.

Методология

1. Архитектурные изменения

Self-Self Attention

Изначальный механизм внимания в CLIP предназначен для предсказаний на уровне изображения, что не оптимально для задач плотных предсказаний, таких как сегментация. Мы внедряем концепцию self-self attention, где каждый патч изображения обращает внимание на себя и семантически связанные патчи, что приводит к более локализованным картам внимания.

Удаление блока Feed-Forward

В последнем слое ViT мы убираем блок Feed-Forward Network (FFN), поскольку его параметры оптимизированы для задач на уровне изображения, а не для сегментации.

Интеграция карт внимания из средних слоев

Мы объединяем внимание последнего слоя с вниманием из выбранных промежуточных слоев, что позволяет использовать богатую информацию, заложенную в различных слоях модели.

2. Инженерия изображений

Вместо того чтобы подавать только исходное изображение в визуальный энкодер CLIP, мы также используем аугментированные изображения для обогащения и разнообразия представлений изображения. Аугментации делятся на две категории:

- Не изменяющие пространственную структуру: Гауссово размытие и преобразование в оттенки серого.

- Изменяющие пространственную структуру: Горизонтальное и вертикальное отражение.

3. Генерация вспомогательных текстов с помощью LLM

Используя LLaMa 3, мы генерируем определения и синонимы для каждого класса, что позволяет CLIP лучше понимать и классифицировать объекты в открытой словарной среде. Эти текстовые представления интегрируются с исходными названиями классов для улучшения сегментации.

Эксперименты и результаты

Наборы данных

Мы оценивали наш метод на четырех общих бенчмарках семантической сегментации: COCO-Stuff, COCO-Object, Pascal Context и Pascal VOC, используя их официальные валидационные наборы.

Основные результаты

ITACLIP превосходит текущие методы на всех четырех датасетах, демонстрируя значительное улучшение по метрике mean Intersection over Union (mIoU).

Анализ

Self-Self Attention

Мы обнаружили, что использование q-q и k-k внимания в последнем блоке self-attention дает наилучшие результаты.

Удаление FFN

Удаление FFN в последнем слое улучшило производительность модели на всех датасетах.

Выбор промежуточных слоев

Анализ показал, что использование внимания из 7-го, 8-го и 10-го слоев в дополнение к финальному слою дает оптимальные результаты.

Влияние инженерии изображений и генерации вспомогательных текстов

Оба модуля оказали положительное влияние на производительность сегментации.

Постобработка

Применение Pixel-Adaptive Mask Refinement (PAMR) для уменьшения шума в предсказаниях улучшило результаты, но даже без PAMR ITACLIP демонстрирует конкурентоспособные результаты.

Значение шага слайда

Меньшие значения шага слайда улучшают производительность, но увеличивают вычислительные затраты.

Гиперпараметры

Мы исследовали влияние коэффициентов инженерии изображений (λ) и вспомогательных текстов (α), обнаружив, что наши методы устойчивы к изменениям в пределах указанного диапазона.

Заключение

ITACLIP представляет собой значительный шаг вперед в области обучения без учителя для семантической сегментации. Наш подход, объединяющий архитектурные изменения, инженерию изображений и использование LLM для генерации вспомогательных текстов, показал превосходные результаты на различных бенчмарках. Эти методы и модули могут быть интегрированы в другие задачи компьютерного зрения, предлагая новые возможности для улучшения качества предсказаний без необходимости дополнительного обучения.