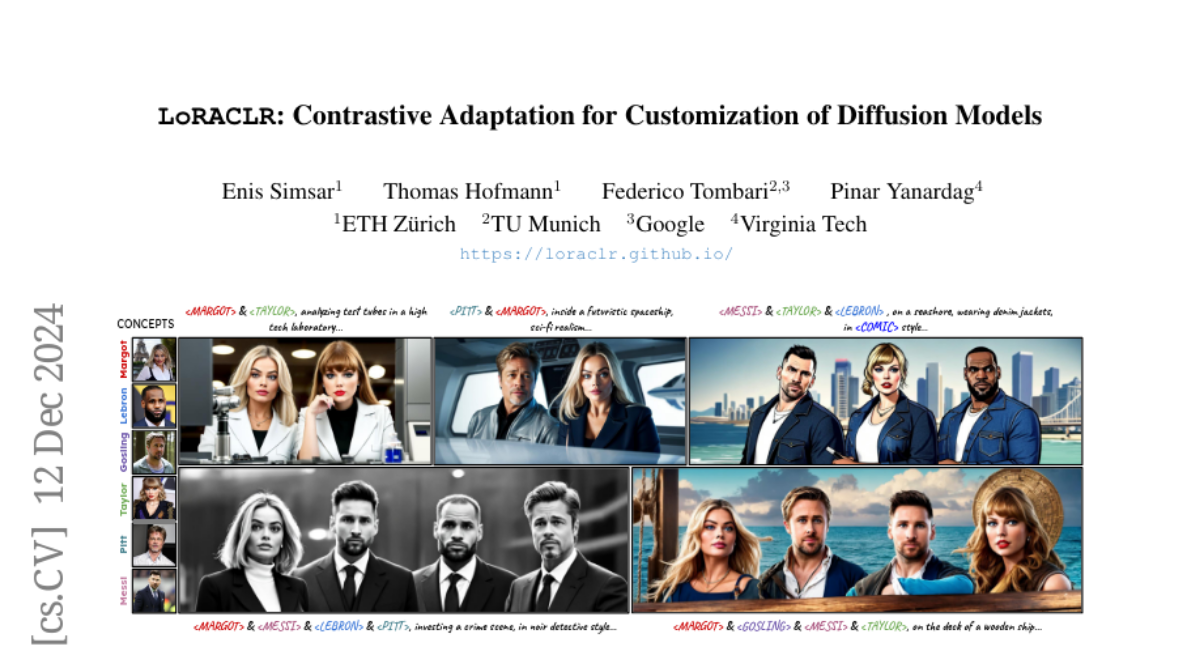

LoRACLR: Контрастивная Адаптация для Кастомизации Диффузионных Моделей

Недавние достижения в настройке текстов на изображения позволили создавать высококачественные, насыщенные контекстом персонализированные изображения, позволяя конкретным концепциям появляться в различных сценариях. Однако существующие методы сталкиваются с трудностями при комбинировании нескольких персонализированных моделей, что часто приводит к запутыванию атрибутов или требует отдельного обучения для сохранения уникальности концепций. Мы представляем LoRACLR, новый подход к генерации изображений с несколькими концепциями, который объединяет несколько моделей LoRA, каждая из которых настроена для конкретной концепции, в единую модель без дополнительной индивидуальной настройки. LoRACLR использует контрастивную задачу для выравнивания и объединения пространств весов этих моделей, обеспечивая совместимость при минимизации интерференции. Устанавливая четкие, но согласованные представления для каждой концепции, LoRACLR позволяет эффективно и масштабируемо композитировать модели для высококачественного синтеза изображений с несколькими концепциями. Наши результаты подчеркивают эффективность LoRACLR в точном объединении нескольких концепций, что предоставляет новые возможности для персонализированной генерации изображений.