LoRACLR: Контрастивная Адаптация для Кастомизации Диффузионных Моделей

Современные достижения в области генерации изображений на основе текстовых подсказок с использованием диффузионных моделей, таких как Stable Diffusion, DALL-E 2 и Imagen, произвели революцию в синтезе изображений. Эти модели позволяют создавать высококачественные изображения, соответствующие заданным текстовым описаниям. Однако, несмотря на их успехи, существующие методы кастомизации сталкиваются с проблемами при комбинировании нескольких персонализированных моделей, что может приводить к путанице атрибутов и необходимости отдельного обучения для сохранения уникальности концепций.

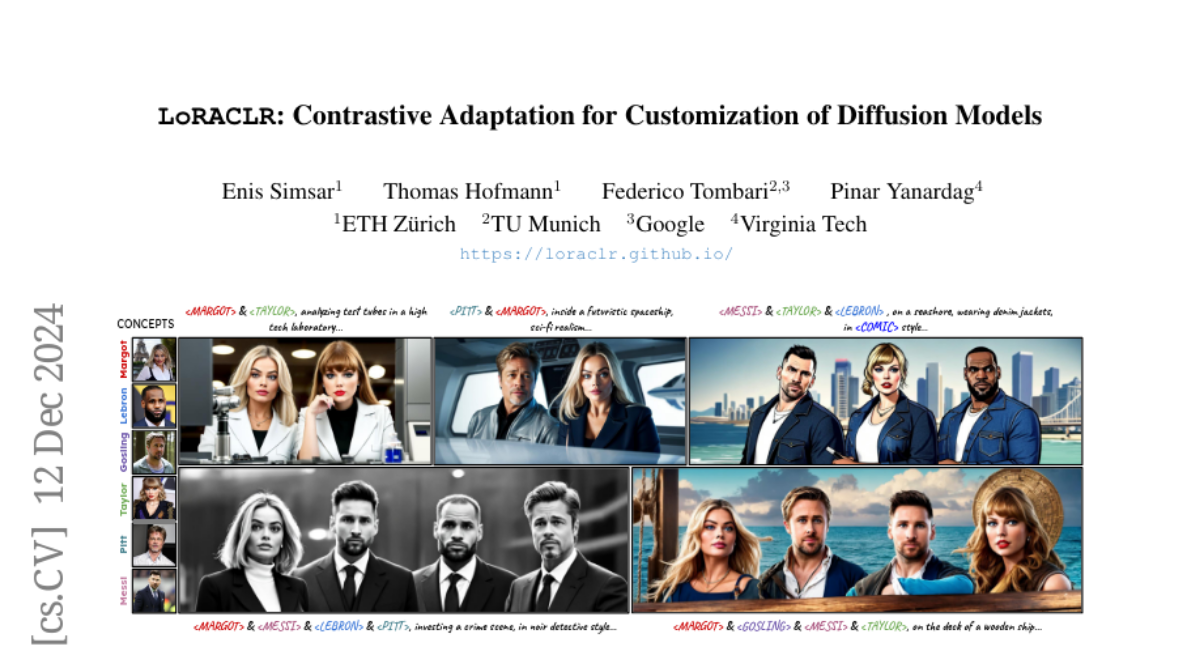

В этой статье мы представляем LoRACLR, новый подход к генерации изображений с несколькими концепциями, который объединяет несколько моделей LoRA, каждая из которых настроена на отдельную концепцию, в единую модель без дополнительной индивидуальной настройки. Используя контрастивную цель для выравнивания и слияния пространств весов этих моделей, LoRACLR обеспечивает совместимость и минимизирует интерференцию. Это позволяет эффективно и масштабируемо композировать модели для синтеза изображений с высоким качеством.

Проблематика и Цели

Существующие методы кастомизации изображений часто требуют одновременного обучения на нескольких концепциях или нуждаются в оптимизации для каждой отдельной картинки. Это усложняет процесс и ограничивает возможности генерации изображений, когда необходимо объединить несколько различных концепций в одном изображении.

LoRACLR решает эти проблемы, позволяя комбинировать несколько моделей LoRA в единую модель, способную точно генерировать несколько концепций одновременно. Наша цель — создать метод, который позволит использовать уже существующие модели LoRA без необходимости повторного обучения или доступа к исходным данным.

Сопутствующие Исследования

Генерация Изображений на Основе Текста

Генерация изображений на основе текста достигла значительных успехов благодаря разработке как GAN (Generative Adversarial Networks), так и диффузионных моделей. Ранние методы, основанные на GAN, сосредоточились на генерации изображений, основываясь на классах или текстовых атрибутах. В последние годы акцент сместился на крупномасштабные диффузионные модели, которые обеспечивают более точный и детализированный синтез изображений.

Персонализированная Генерация Изображений и Кастомизация

Персонализированная генерация изображений направлена на внедрение пользовательских концепций, которые могут использоваться в различных контекстах. Ранние методы, такие как Textual Inversion и DreamBooth, создали основу для обучения представлений из ограниченного набора изображений. Однако, комбинирование нескольких концепций остается открытой проблемой в области синтеза изображений.

Объединение Нескольких Концепций

Комбинирование моделей LoRA для контроля стиля и содержания является сложной задачей. Существующие методы часто сталкиваются с ограничениями, такими как интерференция функций и необходимость в специализированных вариантах LoRA. LoRACLR использует контрастивную цель для выравнивания пространств весов специализированных моделей LoRA, что позволяет создать согласованные композиции с минимальной интерференцией.

Методология LoRACLR

Основные Принципы LoRACLR

LoRACLR работает в два этапа:

- Генерация концептуально специфичных представлений с использованием индивидуально обученных моделей LoRA.

- Объединение этих представлений в единую модель с использованием контрастивной цели.

На первом этапе каждая модель LoRA создает пары входных и выходных признаков для различных концепций, устанавливая положительные и отрицательные пары. На втором этапе эти представления объединяются в единую модель, что позволяет выполнять синтез изображений с несколькими концепциями.

Контрастивная Цель

Контрастивная цель LoRACLR направлена на привлечение положительных пар, генерируемых одной и той же моделью LoRA, и отталкивание отрицательных пар, генерируемых различными моделями. Это достигается с помощью контрастивной потерь, которая минимизирует расстояние между выходными признаками одной и той же концепции и максимизирует расстояние между выходными признаками различных концепций.

Объединение на Основе Дельты

LoRACLR использует аддитивную дельту для объединения моделей LoRA без изменения базовых весов. Это позволяет сохранить целостность каждой модели, обеспечивая совместимость и минимальные изменения в весах.

Эксперименты

Данные и Метрики

Для всех экспериментов использовалась модель Stable Diffusion с высококачественной генерацией изображений. Мы оценивали нашу методику по нескольким ключевым метрикам: текстовому выравниванию, выравниванию изображения и выравниванию идентичности. Эти метрики позволяют оценить, насколько хорошо сгенерированные изображения соответствуют заданным текстовым подсказкам и сохраняют уникальность концепций.

Качественные Результаты

LoRACLR продемонстрировала способность сохранять индивидуальные идентичности при генерации изображений как с одной, так и с несколькими концепциями. В экспериментах, использующих различные числа концепций, было показано, что наш метод не только точно захватывает каждую индивидуальную идентичность, но и генерирует составные изображения, руководствуясь текстовыми подсказками.

Количественные Результаты

По количественным оценкам LoRACLR достигла высоких показателей по всем метрикам, что подчеркивает ее эффективность в сохранении идентичности и точности при генерации изображений. В частности, наша методика показала значительное улучшение в выравнивании изображений и идентичности по сравнению с другими современными методами.

Заключение

LoRACLR представляет собой новый подход к кастомизации диффузионных моделей, который позволяет эффективно объединять несколько моделей LoRA для генерации изображений с несколькими концепциями. Используя контрастивное обучение, наш метод сохраняет уникальные идентичности концепций и обеспечивает высокое качество генерации изображений. LoRACLR не требует повторного обучения и может быть легко интегрирован с существующими моделями, что делает его перспективным инструментом для создания персонализированного контента.

В будущем мы планируем расширить возможности LoRACLR, исследуя его применение в различных областях, таких как создание виртуального контента, персонализированное повествование и цифровое искусство.