LSceneLLM: Улучшение понимания больших 3D-сцен с помощью адаптивных визуальных предпочтений

С развитием технологий 3D-визуализации и обработки данных, понимание 3D-сцен стало важной задачей для различных приложений, таких как робототехника, навигация и взаимодействие с окружающей средой. Одним из ключевых направлений в этой области является создание моделей, которые могут эффективно обрабатывать и интерпретировать сложные 3D-сцены. В этой статье мы рассмотрим LSceneLLM, новую архитектуру, которая предлагает адаптивный подход к пониманию больших 3D-сцен, используя возможности больших языковых моделей (LLM).

Проблема и мотивация

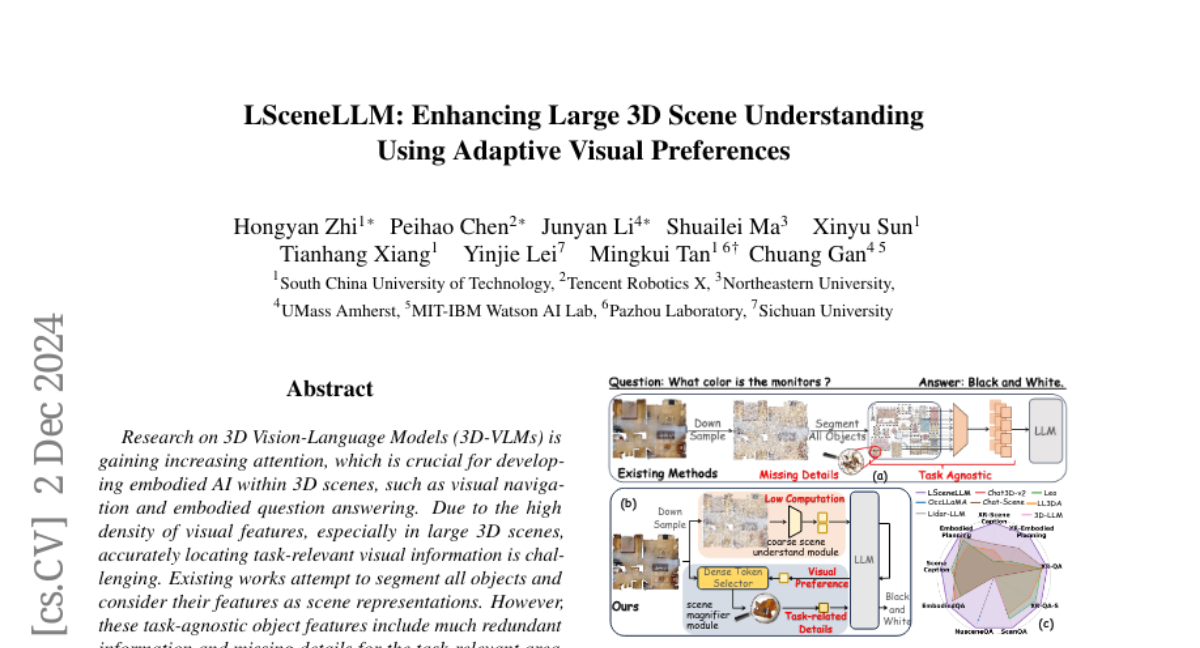

Существующие 3D-модели, основанные на языке (3D-VLM), часто сталкиваются с двумя основными ограничениями. Во-первых, при работе с большими сценами задача поиска визуально релевантной информации становится сложной из-за высокой плотности визуальных признаков. Во-вторых, традиционные подходы, такие как сегментация объектов, могут приводить к избыточной информации и потере деталей, необходимых для выполнения конкретных задач. Это создает потребность в более эффективных методах, которые могут адаптироваться к различным задачам и выделять важные визуальные элементы.

Архитектура LSceneLLM

LSceneLLM предлагает новую архитектуру, состоящую из двух основных модулей: модуля грубого понимания сцены и модуля увеличения сцены. Эта архитектура позволяет модели сначала получить общее представление о сцене, а затем сосредоточиться на деталях в выбранных областях интереса.

Модуль грубого понимания сцены

На первом этапе LSceneLLM использует модуль грубого понимания сцены для обработки входных данных, получая основные визуальные признаки из 3D-точечного облака. Этот модуль преобразует плотные признаки в разреженные визуальные токены, которые затем используются для создания общего представления сцены.

Модуль увеличения сцены

После получения общего представления, модуль увеличения сцены анализирует внимание LLM для определения областей, которые требуют более детального изучения. Он использует выборщик плотных визуальных токенов, который выбирает наиболее релевантные области на основе карты внимания, а затем извлекает детализированные визуальные признаки из этих областей.

Адаптивный механизм самовнимания

Ключевым элементом архитектуры LSceneLLM является адаптивный механизм самовнимания, который интегрирует информацию из выбранных плотных визуальных токенов с исходным состоянием скрытых слоев. Это позволяет модели более эффективно обрабатывать информацию и сосредотачиваться на важных деталях, что значительно улучшает понимание сцены.

Бенчмарки для оценки

Для оценки производительности LSceneLLM был разработан новый бенчмарк под названием XR-Scene, который включает в себя задачи, такие как XR-QA (вопрос-ответ), XR-Embodied Planning (планирование встраивания) и XR-Scene Caption (описание сцены). Этот бенчмарк позволяет всесторонне оценить способности модели в понимании больших 3D-сцен.

Результаты экспериментов

Эксперименты, проведенные с использованием LSceneLLM, показали значительное улучшение по сравнению с существующими методами. Модель продемонстрировала высокую точность в задачах понимания сцен и успешно справилась с вызовами, связанными с большими и сложными 3D-сценами. В частности, LSceneLLM превзошла другие подходы в задачах, требующих глубокого понимания отношений между объектами и их пространственными характеристиками.

Заключение

LSceneLLM представляет собой значительный шаг вперед в области понимания больших 3D-сцен. Используя адаптивные визуальные предпочтения и модуль увеличения сцены, модель эффективно справляется с задачами, которые традиционные методы не могут решить. В будущем мы надеемся увидеть дальнейшие улучшения в области 3D-обработки и применения LSceneLLM в различных приложениях, включая робототехнику и виртуальную реальность.