Causal Diffusion: Новый взгляд на генерацию данных

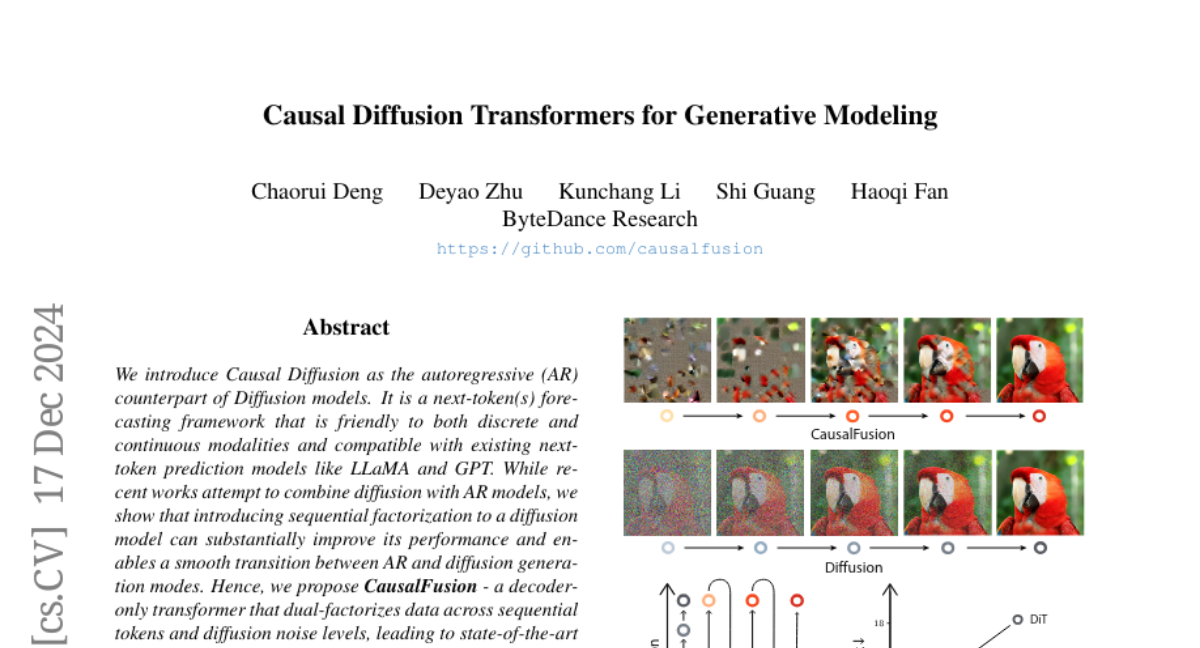

Мы представляем Кausal Diffusion как авторегрессионный (AR) аналог диффузионных моделей. Это фреймворк прогнозирования следующего токена(ов), который удобен как для дискретных, так и для непрерывных модальностей и совместим с существующими моделями предсказания следующего токена, такими как LLaMA и GPT. В то время как недавние работы пытаются объединить диффузионные модели с AR моделями, мы показываем, что введение последовательной факторизации в диффузионную модель может значительно улучшить ее производительность и обеспечить плавный переход между режимами генерации AR и диффузии. Поэтому мы предлагаем CausalFusion - трансформер только декодер, который двуфакторизует данные по последовательным токенам и уровням диффузионного шума, что приводит к достижениям на уровне лучших результатов в бенчмарке генерации ImageNet, одновременно используя преимущество AR для генерации произвольного количества токенов для контекстного вывода. Мы также демонстрируем мультимодальные возможности CausalFusion через совместную модель генерации изображений и создания заголовков, и показываем способность CausalFusion к манипуляциям с изображениями в контексте без обучения. Мы надеемся, что эта работа сможет предоставить сообществу новый взгляд на обучение мультимодальных моделей на дискретных и непрерывных данных.