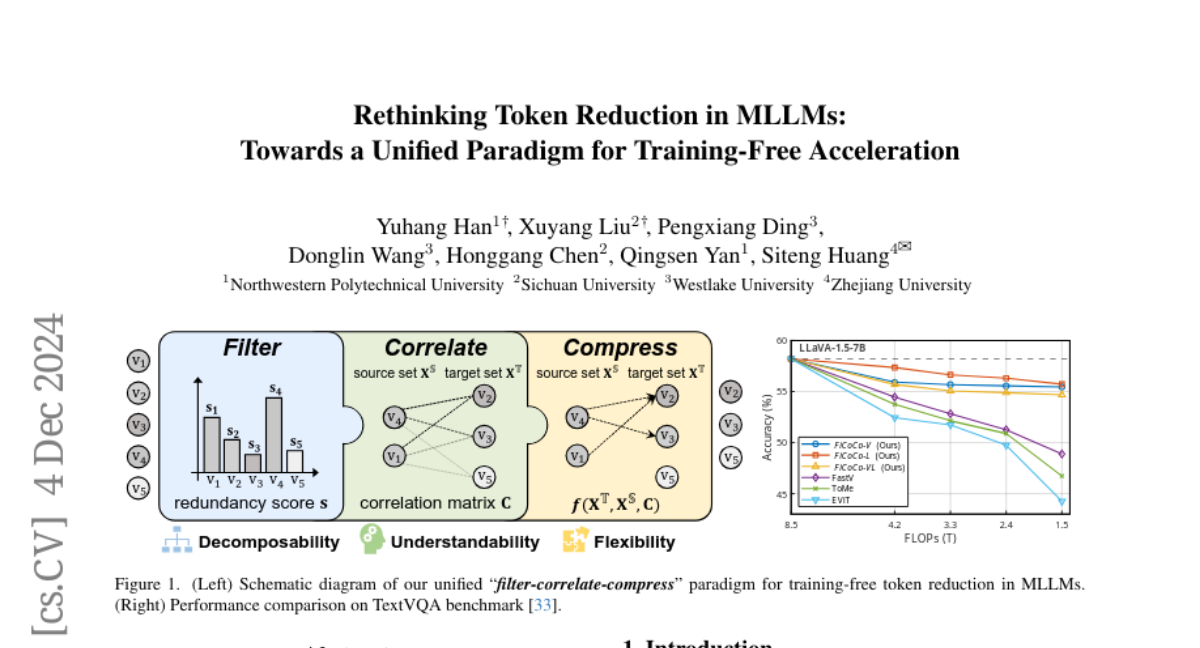

Переосмысление сокращения токенов в MLLMs: К единому подходу для ускорения без обучения

Для ускорения инференса сложных мультимодальных крупных языковых моделей (MLLMs) данное исследование переосмысливает текущий ландшафт исследований по сокращению токенов без обучения. Мы с сожалением отмечаем, что ключевые компоненты существующих методов тесно переплетены, и их взаимосвязи и эффекты остаются неясными для сравнения, переноса и расширения. Поэтому мы предлагаем унифицированный подход "фильтровать-связывать-сжимать", который разделяет процесс сокращения токенов на три отдельные стадии в рамках конвейера, сохраняя при этом последовательные цели и элементы дизайна, но позволяя уникальные реализации. Кроме того, мы объясняем популярные работы и включаем их в наш подход, чтобы продемонстрировать его универсальность. Наконец, мы предлагаем набор методов, основанных на этом подходе, которые находят баланс между скоростью и точностью на разных этапах инференса. Результаты экспериментов на 10 бенчмарках показывают, что наши методы могут достигать сокращения FLOPs до 82.4% с минимальным влиянием на производительность, одновременно превосходя современные методы без обучения. Страница нашего проекта находится по адресу https://ficoco-accelerate.github.io/.