Переосмысление сокращения токенов в MLLMs: К единому подходу для ускорения без обучения

Мультимодальные большие языковые модели (MLLMs) представляют собой инновационные системы, которые объединяют обработку визуальных и текстовых данных, позволяя создавать инструкции, смешивающие различные модальности. Эти модели, такие как LLaVA-1.5, используют предварительно обученные языковые модели (LLM) для интерпретации визуальной информации в контексте текстовых инструкций. Однако, несмотря на их высокую производительность, MLLMs сталкиваются с проблемой увеличения вычислительной сложности с ростом длины последовательности входных данных, что ограничивает их практическое применение из-за высоких требований к вычислительным ресурсам и памяти.

Проблемы и текущий ландшафт

Существующие методы сокращения токенов в MLLMs, такие как ToMe, EViT и FastV, часто переплетают свои ключевые компоненты, что делает их взаимосвязи и эффекты неясными. Это затрудняет сравнение, перенос и расширение методов. Кроме того, эти методы обычно не предоставляют четких формул для описания своих операций, что усложняет понимание и модификацию.

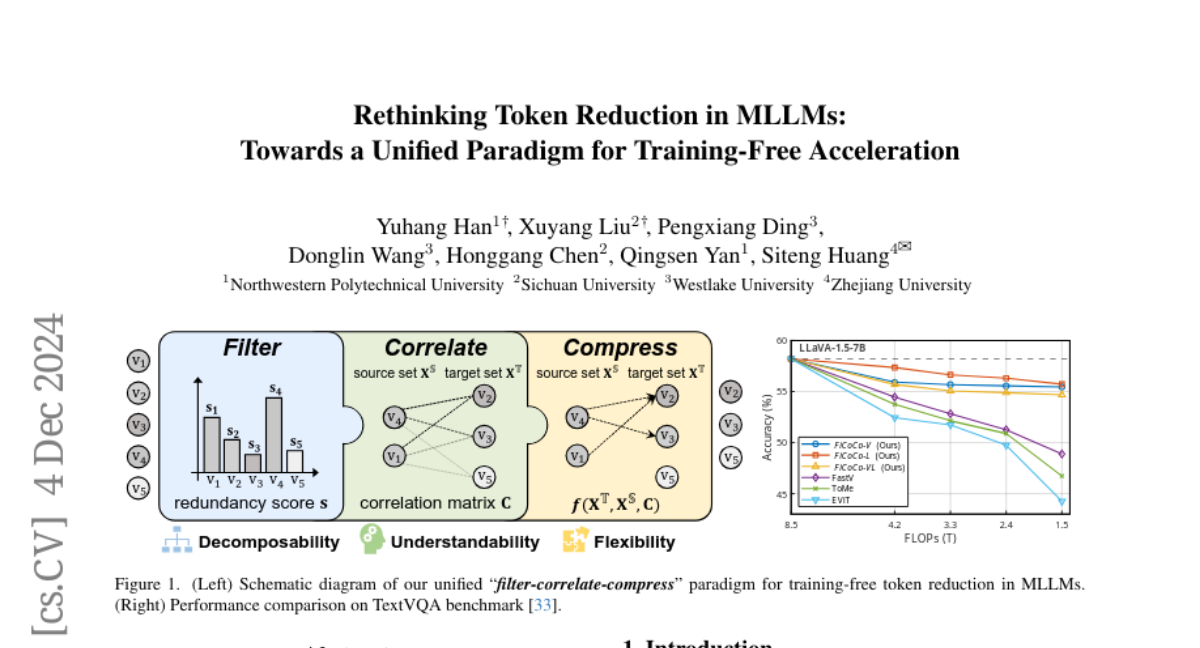

Предложенный подход: "Фильтр-Корреляция-Сжатие"

Мы предлагаем новый парадигм "фильтр-корреляция-сжатие" для унификации методов сокращения токенов без обучения. Этот подход разделяет процесс на три четких этапа:

-

Фильтрация: Определение, какие токены следует удалить, основываясь на их избыточности.

-

Корреляция: Определение, куда следует перенести информацию из удаляемых токенов.

-

Сжатие: Объединение токенов для сохранения важной информации.

Этапы парадигмы

-

Фильтрация: На этом этапе мы оцениваем избыточность токенов, используя их локальные и глобальные характеристики. Например, в FiCoCo-V мы рассчитываем избыточность на основе весов внимания и семантической значимости токенов.

-

Корреляция: Здесь мы определяем, как токены связаны друг с другом, что позволяет нам понять, куда следует перенести информацию из удаляемых токенов. В FiCoCo-L мы учитываем как прямую, так и косвенную корреляцию через текстовые токены.

-

Сжатие: Этот этап включает в себя объединение токенов, где информация из удаляемых токенов распределяется среди сохраняемых токенов. Мы используем адаптивный подход, где каждый токен может быть объединен с несколькими другими, в зависимости от их корреляции.

Методы FiCoCo

На основе предложенной парадигмы мы разработали серию методов, известных как FiCoCo:

-

FiCoCo-V: Сокращает токены в визуальном энкодере, используя локальную и задачную избыточность.

-

FiCoCo-L: Сокращает токены в LLM декодере, учитывая внимание между визуальными и текстовыми токенами.

-

FiCoCo-VL: Комбинирует подходы FiCoCo-V и FiCoCo-L для сокращения токенов на обоих этапах инференции MLLMs.

Эксперименты и результаты

Мы провели обширные эксперименты на 10 бенчмарках, включая TextVQA и ScienceQA, используя модели LLaVA-1.5-7B/13B. Наши методы FiCoCo показали значительное улучшение в скорости инференции, сократив FLOPs до 17.6% от исходного значения, при этом сохраняя высокую точность. Например, FiCoCo-L на бенчмарке SQA снизил FLOPs до 1.5T, при этом улучшив точность на 1.7% по сравнению с IVTP.

Заключение

Наш подход "фильтр-корреляция-сжатие" предоставляет унифицированный и гибкий метод для сокращения токенов в MLLMs без необходимости дополнительного обучения. Это не только упрощает понимание и модификацию существующих методов, но и открывает путь для разработки новых подходов к ускорению инференции в мультимодальных моделях.