Video-3D LLM: Понимание 3D-сцен с помощью видео-репрезентаций

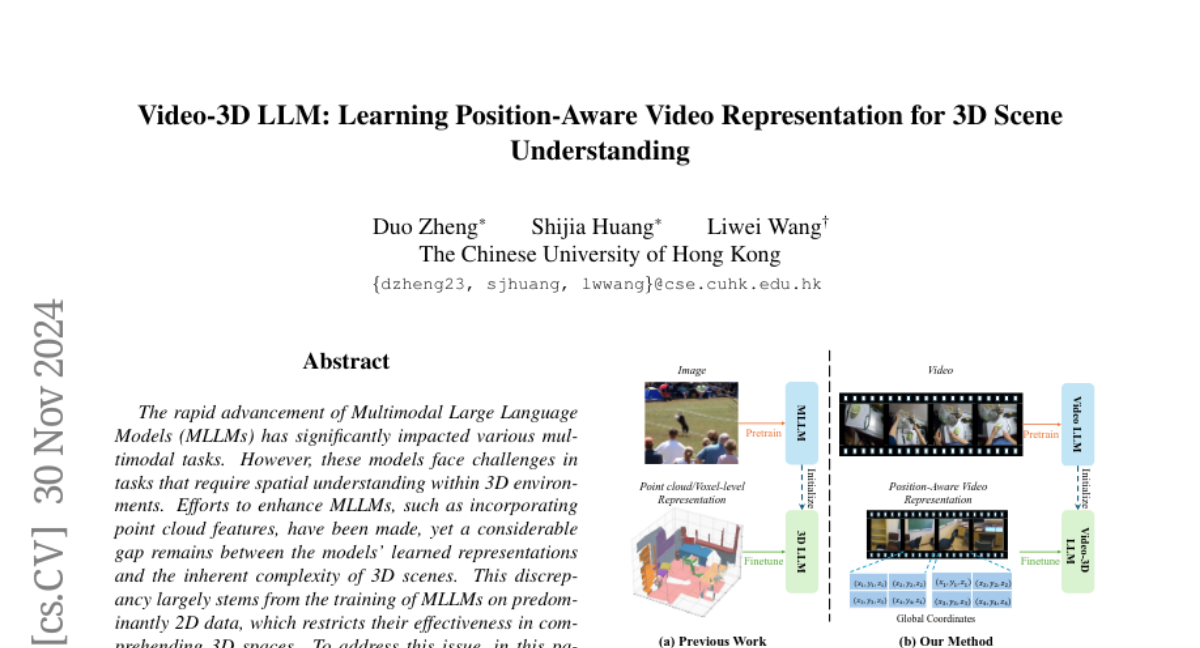

С развитием многомодальных больших языковых моделей (MLLM) наблюдается значительный прогресс в различных мультимодальных задачах. Однако, несмотря на успехи, эти модели сталкиваются с трудностями в задачах, требующих пространственного понимания в 3D-средах. Проблема заключается в том, что многие MLLM обучаются на данных в основном в 2D-формате, что ограничивает их способность понимать сложные 3D-пространства. В данной статье мы представляем новую модель, названную Video-3D LLM, которая направлена на решение этой проблемы.

Проблема и мотивация

Текущие MLLM, такие как LLaVA-3D, показывают отличные результаты в 2D-задачах, но их возможности в 3D-сценах остаются ограниченными. Это связано с тем, что большинство моделей обучаются на изображениях и текстах, что не позволяет им эффективно обрабатывать информацию о пространственных взаимосвязях в 3D. В то время как некоторые исследования пытались интегрировать 3D-данные, такие как облака точек, в MLLM, остаётся значительный разрыв между изученными представлениями и сложностью реальных 3D-сцен.

Модель Video-3D LLM

Video-3D LLM предлагает новый подход к пониманию 3D-сцен, рассматривая их как динамические видео и интегрируя 3D-позиционное кодирование в эти представления. Это позволяет более точно сопоставлять видео-репрезентации с реальными пространственными контекстами. Модель использует максимальную стратегию выборки, чтобы оптимизировать баланс между вычислительными затратами и эффективностью производительности.

Архитектура модели

Video-3D LLM состоит из нескольких ключевых компонентов:

- Визуальный энкодер: Он преобразует видео-кадры в визуальные представления.

- Модуль 3D-позиционного кодирования: Этот модуль отвечает за интеграцию 3D-координат в видео-представления.

- Основной модуль Video LLM: Он обрабатывает позиционно-осознанные видео-представления для выполнения различных задач.

Стратегия выборки кадров

Одной из основных задач является эффективная выборка кадров из 3D-сцен. Для этого мы применяем стратегию максимального охвата, которая позволяет выбрать наименьшее количество кадров, максимально покрывающих 3D-сцену. Это можно формализовать как задачу максимального покрытия, где цель состоит в том, чтобы найти подмножество кадров, максимизирующее покрытие вокселей в 3D-сцене.

Позиционно-осознанные видео-представления

После выборки кадров мы преобразуем информацию о глубине в 3D-координаты и кодируем эти координаты вместе с визуальными представлениями. Мы используем синусоидальное кодирование для представления 3D-координат, что позволяет сохранить пространственную информацию.

Обучение модели

Модель обучается с использованием комбинированного набора данных, который охватывает различные задачи понимания 3D-сцен. Мы применяем кросс-энтропийную потерю для задач генерации текста и специальную потерю для более точной локализации объектов.

Эксперименты

Мы провели обширные эксперименты на нескольких бенчмарках, таких как ScanRefer, Multi3DRefer, Scan2Cap, ScanQA и SQA3D. Результаты показывают, что Video-3D LLM достигает состояния наилучшего искусства в понимании 3D-сцен, превосходя предыдущие модели, такие как LLaVA-3D, при использовании значительно меньшего объема данных.

Сравнение с другими моделями

Video-3D LLM демонстрирует высокую точность в задачах визуального закрепления, плотного аннотирования и ответов на вопросы, связанных с 3D-сценами. Например, в задаче визуального закрепления модель достигает 58.1% точности при пороге 0.25 и 51.7% при пороге 0.5 на наборе данных ScanRefer.

Заключение

Video-3D LLM представляет собой значительный шаг вперед в области понимания 3D-сцен. Интеграция 3D-координат в видео-представления не только улучшает точность, но и расширяет возможности применения MLLM в 3D-средах. Мы надеемся, что этот подход станет основой для дальнейших исследований в области пространственного понимания и взаимодействия с 3D-сценами.