p-MoD: Эффективные Мультимодальные Большие Языковые Модели

С недавним развитием мультимодальных больших языковых моделей (MLLMs), таких как LLaVA и LLaVA-NeXT, наблюдается значительный прогресс в задачах понимания визуального языка. Однако, несмотря на их впечатляющую производительность, высокая вычислительная стоимость обучения и инференса остаётся серьёзной проблемой для дальнейшего развития этой области. Основная часть вычислительной нагрузки возникает из-за огромного количества визуальных токенов, обрабатываемых декодером трансформера. В данной статье мы рассмотрим новый подход, предложенный в работе "p-MoD: Building Mixture-of-Depths MLLMs via Progressive Ratio Decay", который направлен на улучшение эффективности MLLMs.

Проблема избыточности токенов

Современные MLLMs обрабатывают визуальные данные, которые могут включать высококачественные изображения и видео. Это приводит к значительному увеличению количества визуальных токенов, пропорционально количеству пикселей и количеству обрабатываемых кадров. В результате, вычислительная сложность возрастает, что затрудняет применение MLLMs в реальных задачах.

Текущие подходы и их ограничения

Существующие подходы к оптимизации MLLMs в основном сосредоточены на предварительном сжатии визуальных токенов перед их подачей в декодер. Это может включать использование легковесных коннекторов, свёрток и других методов. Однако такие подходы игнорируют потенциал самой языковой модели для сжатия визуальных токенов в процессе обработки. Это и стало основой для разработки нового механизма, известного как Mixture-of-Depths (MoD).

Mixture-of-Depths (MoD)

MoD — это механизм, который позволяет каждой слою трансформера выбирать наиболее важные визуальные токены для обработки, пропуская избыточные. Однако интеграция MoD в MLLMs представляет собой непростую задачу. Основные проблемы включают:

- Обучение и стабильность инференса: Встраивание MoD в предварительно обученную языковую модель может нарушить её языковые способности.

- Ограниченные данные для обучения: Мультимодальные данные, используемые для обучения MLLMs, могут быть значительно меньше по объёму, чем текстовые данные для LLM.

Улучшения MoD

Для преодоления этих проблем были предложены два основных улучшения:

- Tanh-gated Weight Normalization (TanhNorm): Эта функция нормализации обеспечивает правильную инициализацию весов и улучшает стабильность обучения и инференса.

- Symmetric Token Reweighting (STRing): Этот модуль использует сигналы языкового супервайзинга для более точной оценки важности токенов, даже при ограниченных данных для обучения.

Прогрессивное уменьшение соотношения токенов (PRD)

Одним из ключевых нововведений является стратегия прогрессивного уменьшения соотношения токенов (PRD). Исследования показали, что визуальные токены имеют более высокую избыточность на более глубоких слоях трансформера. PRD последовательно уменьшает соотношение токенов, обрабатываемых на каждом слое, что позволяет модели более эффективно использовать ресурсы.

Формально, для l-го слоя соотношение токенов R_l определяется как:

[ R_l = \frac{1}{2} \cos\left(\frac{\pi l}{L}\right) + \beta ]

где L — общее количество слоев, а β — сдвиговой коэффициент, позволяющий гибко контролировать общую вычислительную нагрузку модели.

Архитектура p-MoD

Модель p-MoD состоит из слоев, улучшенных с помощью TanhNorm и STRing, а также использует стратегию PRD. Каждый слой модели сначала присваивает веса токенам, а затем выбирает наиболее важные токены для обработки.

Процесс выбора токенов

- Присвоение весов: Входные токены проходят через линейный предсказатель, чтобы получить набор весов.

- Выбор токенов: Токены с весами выше определённого порога выбираются для обработки, в то время как остальные пропускаются.

- Нормализация весов: Применяется TanhNorm для нормализации весов перед обработкой токенов.

Эксперименты и результаты

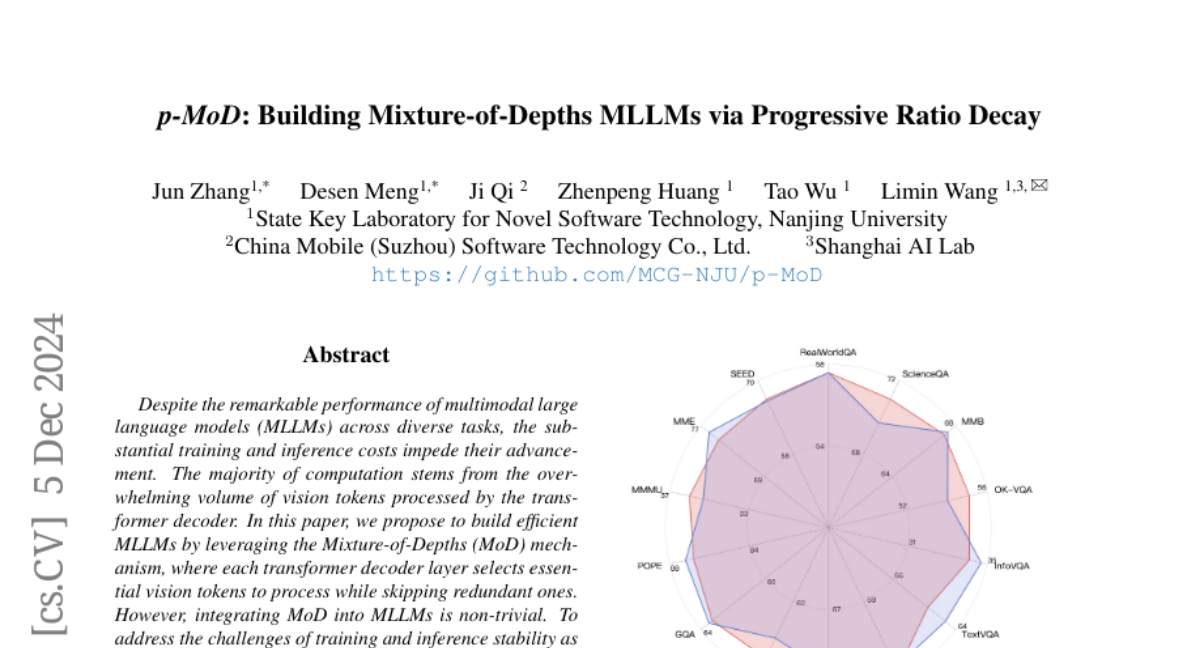

Для проверки эффективности p-MoD были проведены обширные эксперименты на двух базовых моделях (LLaVA-1.5 и LLaVA-NeXT) по 14 различным бенчмаркам. Результаты показали, что p-MoD достигает сопоставимой или даже лучшей производительности по сравнению с базовыми моделями, с заметным снижением вычислительных затрат:

- TFLOPs: 55.6% по сравнению с базовой моделью.

- Хранилище KV: 53.8% по сравнению с базовой моделью.

- Часы GPU: 77.7% по сравнению с базовой моделью.

Сравнение с другими подходами

p-MoD также был протестирован по сравнению с другими методами, основанными на оценках внимания. В отличие от методов, которые отбрасывают токены, p-MoD выбирает токены для обработки, что позволяет избежать потерь информации.

Заключение

В данной работе представлен новый подход к созданию эффективных MLLMs с использованием механизма Mixture-of-Depths и стратегии прогрессивного уменьшения соотношения токенов. Модель p-MoD продемонстрировала значительное улучшение в эффективности при сохранении или улучшении производительности на различных бенчмарках. Это делает p-MoD многообещающей основой для будущих исследований в области разработки эффективных мультимодальных языковых моделей.

Перспективы дальнейших исследований

Хотя p-MoD был протестирован на моделях, работающих с одиночными изображениями, есть потенциал для применения этой модели в более сложных задачах, таких как обработка видео или наборов изображений. Будущие исследования могут сосредоточиться на расширении применения p-MoD для более сложных мультимодальных задач.