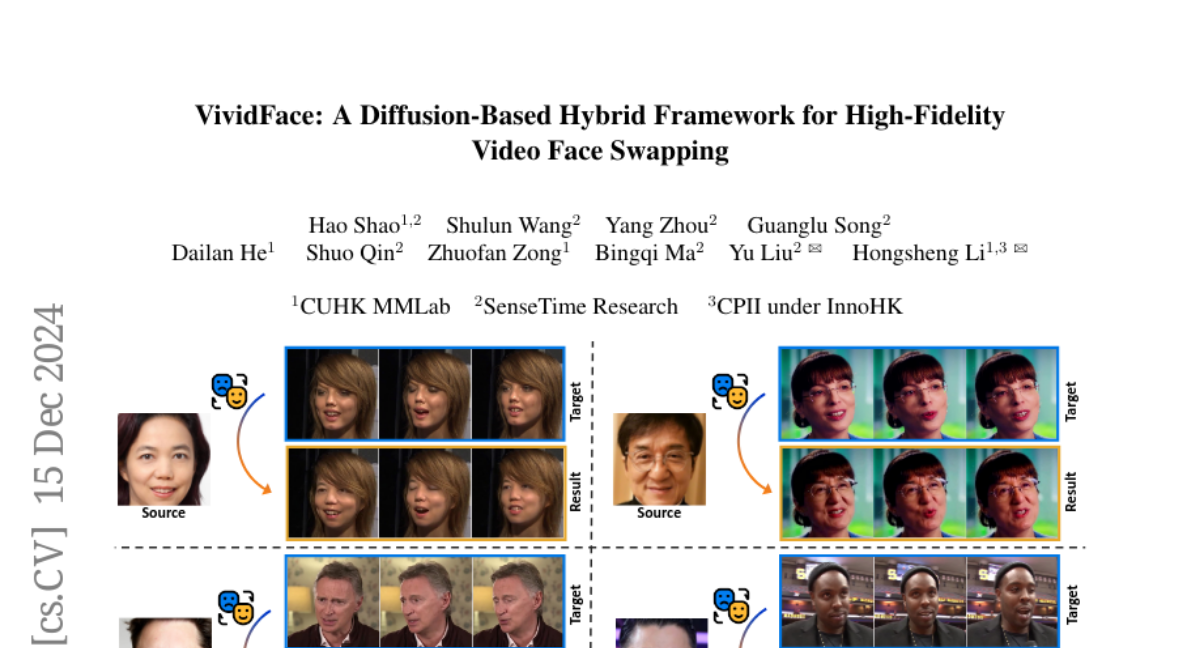

VividFace: Диффузионная гибридная система для высококачественного видео-замены лиц

Смена лиц на видео становится все более популярной в различных приложениях, однако существующие методы в основном сосредоточены на статических изображениях и испытывают трудности с заменой лиц на видео из-за временной согласованности и сложных сценариев. В этой статье мы представляем первую основанную на диффузии структуру, специально разработанную для замены лиц на видео. Наш подход вводит новую гибридную структуру обучения изображений и видео, которая использует как обильные статические данные изображений, так и временные видео последовательности, решая врожденные ограничения обучения только на видео. Структура включает специально разработанную диффузионную модель, связанную с VidFaceVAE, которая эффективно обрабатывает оба типа данных, чтобы лучше поддерживать временную согласованность генерируемых видео. Чтобы дополнительно разъединить идентичность и позу, мы создаем набор данных Attribute-Identity Disentanglement Triplet (AIDT), в котором каждый тройник состоит из трех лицевых изображений, два из которых имеют одинаковую позу, а два имеют одинаковую идентичность. Улучшенный с помощью комплексного увеличения окклюзии, этот набор данных также повышает устойчивость к окклюзиям. Кроме того, мы интегрируем технологии 3D-реконструкции в качестве условия ввода в нашу сеть для обработки больших вариаций позы. Обширные эксперименты показывают, что наша структура достигает превосходных результатов в сохранении идентичности, временной согласованности и визуального качества по сравнению с существующими методами, при этом требуя меньше шагов вывода. Наш подход эффективно смягчает ключевые проблемы в замене лиц на видео, включая временные мерцания, сохранение идентичности и устойчивость к окклюзиям и вариациям поз.