Пути на образном многообразии: Редактирование изображений через генерацию видео

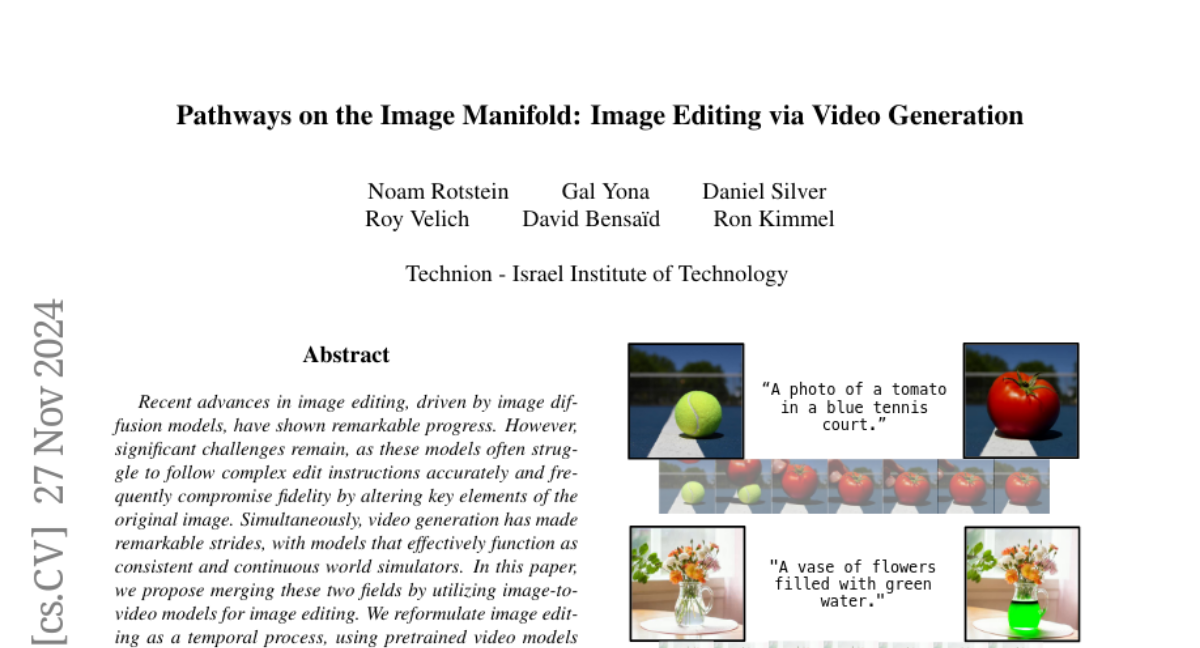

Редактирование изображений с помощью глубокого обучения и текстовых инструкций достигло значительных успехов, но по-прежнему сталкивается с ограничениями в точности редактирования и сохранении ключевых характеристик исходного изображения. В данной статье мы предлагаем новый подход к редактированию изображений, используя модели генерации видео для создания плавных переходов от исходного изображения к желаемому результату. Этот метод, названный Frame2Frame (F2F), позволяет не только улучшить точность редактирования, но и сохранить ключевые аспекты исходного изображения, что является значительным шагом вперед по сравнению с традиционными методами.

Основные концепции

1. Редактирование как временной процесс

Вместо того чтобы рассматривать редактирование изображения как однократное преобразование, мы представляем его как последовательность временных изменений. Это позволяет нам использовать модели генерации видео, которые уже обладают пониманием временных связей и могут создавать последовательные и физически правдоподобные переходы между кадрами.

2. Использование предобученных моделей

Мы используем предобученные модели генерации видео, такие как CogVideoX, которые были обучены на больших объемах данных интернета. Эти модели способны создавать видео, где каждый кадр логически следует за предыдущим, что идеально подходит для нашего подхода к редактированию изображений.

3. Создание временных описаний редактирования

Для каждого редактирования мы создаем "временные описания редактирования" (Temporal Editing Captions), которые описывают, как изменения должны происходить во времени. Это позволяет модели видео-генерации создавать плавные переходы, следуя заданным инструкциям.

4. Выбор оптимального кадра

После генерации видео, мы автоматически выбираем кадр, который наилучшим образом соответствует желаемому результату редактирования. Это делается с помощью Vision-Language Model (VLM), который анализирует каждый кадр на предмет соответствия текстовому описанию и сохранения исходного содержания.

Технические детали

Архитектура Frame2Frame

- Входные данные: Исходное изображение и текстовое описание желаемого редактирования.

- Шаг 1: Генерация временного описания редактирования с помощью VLM.

- Шаг 2: Генерация видео на основе исходного изображения и временного описания с использованием модели генерации видео.

- Шаг 3: Автоматический выбор оптимального кадра из сгенерированного видео.

Преимущества подхода

- Сохранение ключевых элементов: Наш метод позволяет сохранять ключевые элементы исходного изображения, что часто теряется при традиционных методах редактирования.

- Плавность переходов: Использование видео-генерации обеспечивает плавные и естественные переходы, что делает результат более реалистичным.

- Универсальность: Метод может быть применен не только для редактирования изображений, но и для других задач компьютерного зрения, таких как дефокусировка, удаление шума и перераспределение света.

Ограничения

- Камера и перспектива: Иногда модель может вносить нежелательные изменения в перспективу или движение камеры.

- Ограничения обучающих данных: Модели генерации видео обучены на определенных данных, что может ограничить их способность создавать необычные или фантазийные редактирования.

- Ресурсоемкость: Генерация видео требует значительных вычислительных ресурсов, что может быть ограничивающим фактором.

Заключение

Наш подход Frame2Frame демонстрирует, как можно использовать модели генерации видео для решения задач редактирования изображений, обходя многие ограничения традиционных методов. Он обеспечивает высокую точность редактирования и сохранение ключевых характеристик исходного изображения, что делает его перспективным направлением для дальнейших исследований и разработок в области машинного зрения и искусственного интеллекта.