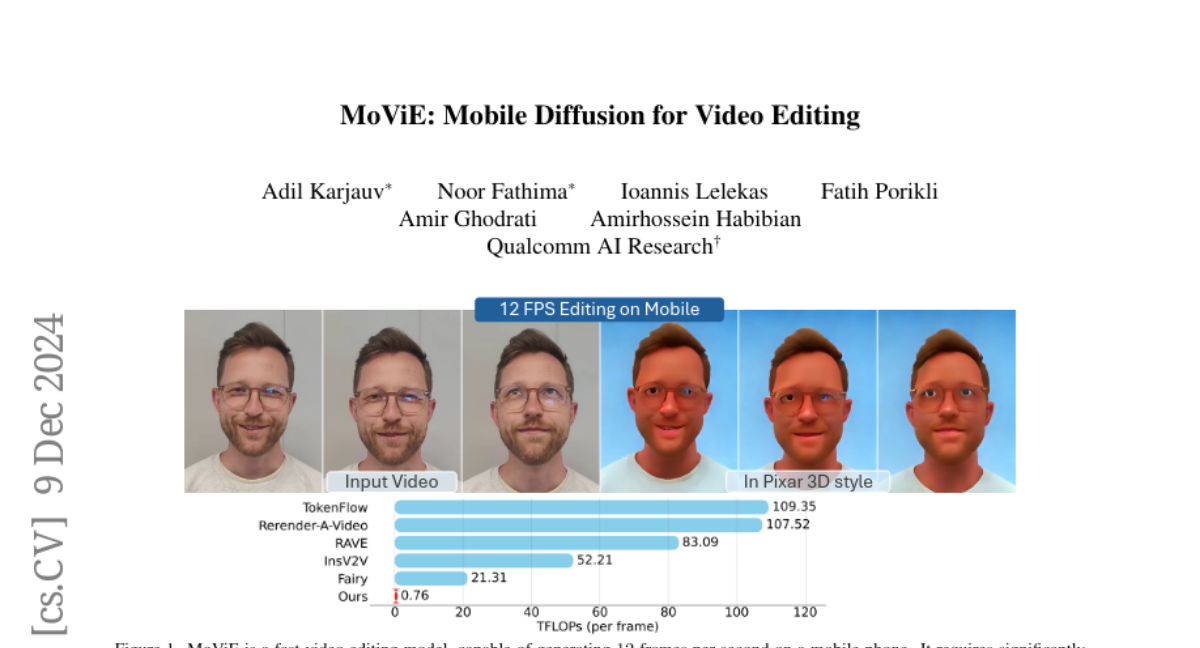

MoViE: Мобильная диффузия для видеомонтажа

Недавний прогресс в редактировании видео на основе диффузии продемонстрировал выдающийся потенциал для практического применения. Тем не менее, эти методы остаются prohibitively дорогими и сложными для развертывания на мобильных устройствах. В этом исследовании мы представляем ряд оптимизаций, которые делают мобильное редактирование видео осуществимым. Основываясь на существующей модели редактирования изображений, мы сначала оптимизируем её архитектуру и внедряем легкий автоэнкодер. Затем мы расширяем дистилляцию без классификатора для нескольких модальностей, что приводит к троекратному ускорению работы на устройстве. Наконец, мы уменьшаем количество шагов выборки до одного, представив новую схему противостоящей дистилляции, которая сохраняет контролируемость процесса редактирования. В совокупности эти оптимизации позволяют редактировать видео со скоростью 12 кадров в секунду на мобильных устройствах, сохраняя при этом высокое качество. Наши результаты доступны по адресу https://qualcomm-ai-research.github.io/mobile-video-editing/.