Устойчивость к исключениям в коде: Применение LLM и многоагентной системы Seeker

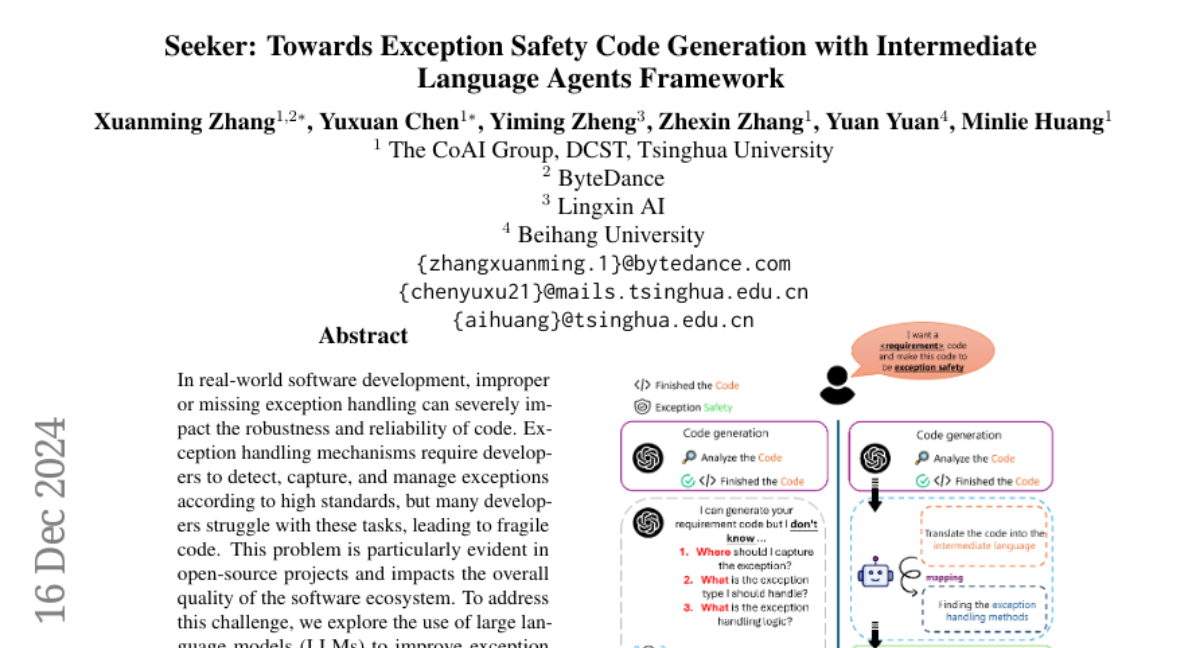

В реальной разработке программного обеспечения неправильная или отсутствующая обработка исключений может серьезно повлиять на надежность и устойчивость кода. Механизмы обработки исключений требуют от разработчиков выявления, захвата и управления исключениями в соответствии с высокими стандартами, однако многие разработчики сталкиваются с трудностями в этих задачах, что приводит к хрупкому коду. Эта проблема особенно очевидна в проектах с открытым исходным кодом и влияет на общее качество программного обеспечения. Чтобы решить эту проблему, мы исследуем использование больших языковых моделей (LLM) для улучшения обработки исключений в коде. В результате обширного анализа мы выявили три основные проблемы: нечувствительное обнаружение хрупкого кода, неточный захват блока исключений и искаженное решение по обработке. Эти проблемы распространены среди реальных репозиториев, что указывает на то, что надежные практики обработки исключений часто игнорируются или неправильно обрабатываются. В ответ на это мы предлагаем Seeker, многоагентную структуру, вдохновленную стратегиями экспертных разработчиков по обработке исключений. Seeker использует агентов: Сканер, Датчик, Хищник, Ранжировщик и Обработчик, чтобы помочь LLM более эффективно выявлять, захватывать и разрешать исключения. Наша работа является первым систематическим исследованием о том, как использовать LLM для улучшения практик обработки исключений в реальных сценариях разработки, предоставляя ценные идеи для будущих улучшений надежности кода.