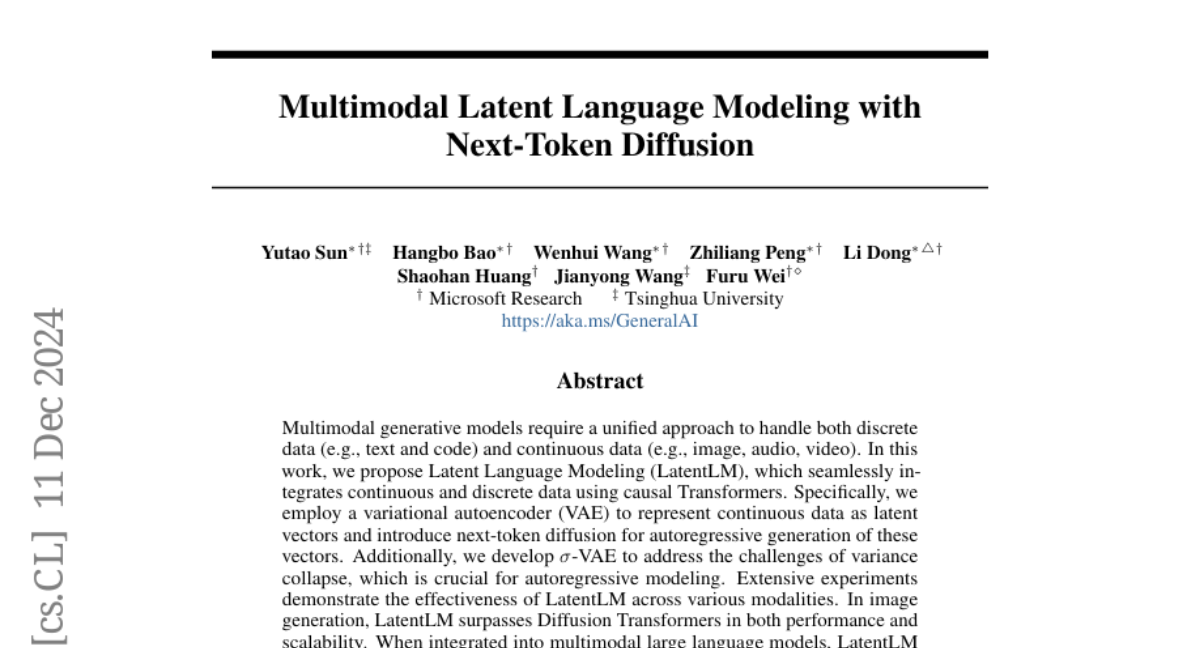

Мультимодальное латентное языковое моделирование с помощью диффузии следующего токена

Мультимодальные генеративные модели требуют единого подхода для обработки как дискретных данных (например, текста и кода), так и непрерывных данных (например, изображений, аудио, видео). В этой работе мы предлагаем Моделирование Языка в Скрытом Пространстве (Latent Language Modeling, LatentLM), которое бесшовно интегрирует непрерывные и дискретные данные с использованием причинных трансформеров. В частности, мы используем вариационный автокодировщик (VAE) для представления непрерывных данных в виде скрытых векторов и вводим диффузию следующего токена для авторегрессионной генерации этих векторов. Кроме того, мы разрабатываем sigma-VAE, чтобы решить проблемы коллапса дисперсии, что имеет решающее значение для авторегрессионного моделирования. Обширные эксперименты демонстрируют эффективность LatentLM в различных модальностях. В генерации изображений LatentLM превосходит диффузионные трансформеры как по производительности, так и по масштабируемости. При интеграции в мультимодальные большие языковые модели LatentLM предоставляет универсальный интерфейс, который объединяет мультимодальную генерацию и понимание. Экспериментальные результаты показывают, что LatentLM достигает положительных результатов по сравнению с Transfusion и векторизованными моделями в контексте увеличения токенов для обучения. В синтезе текста в речь LatentLM превосходит передовую модель VALL-E 2 по сходству с говорящим иrobustness, при этом требуя на 10 раз меньше шагов декодирования. Результаты подтверждают, что LatentLM является высокоэффективным и масштабируемым подходом для продвижения больших мультимодальных моделей.