SVDQuant: Поглощение выбросов с помощью низкоранговых компонентов для 4-битных диффузионных моделей

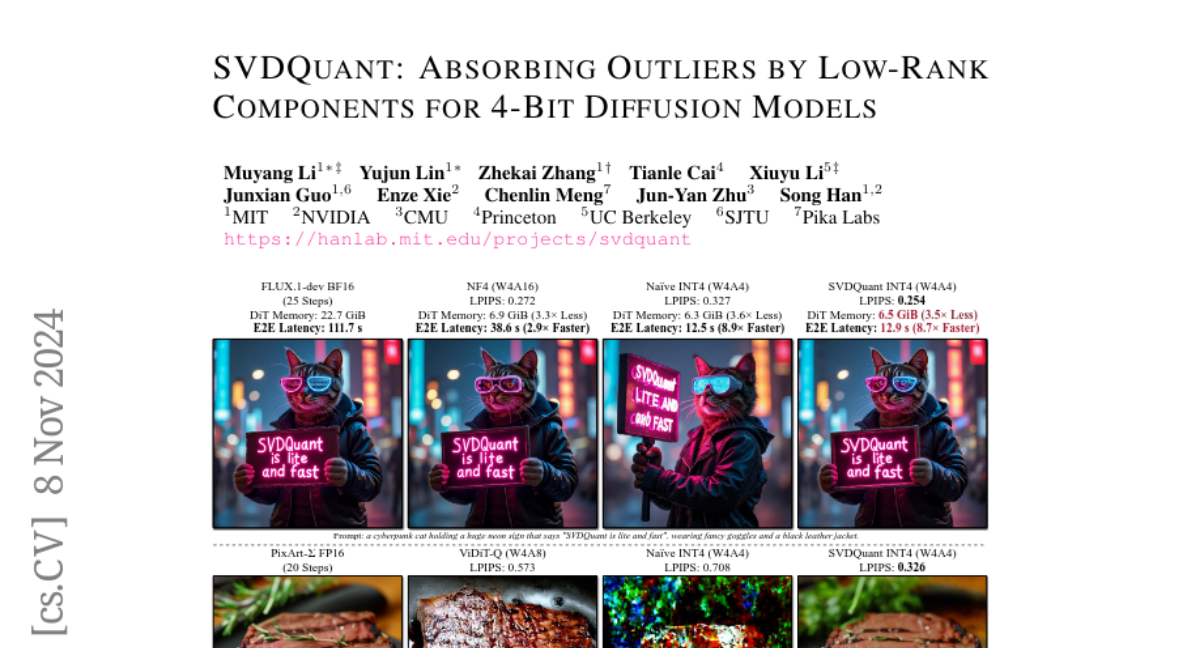

Модели диффузии доказали свою высокую эффективность в генерации изображений высокого качества. Однако, по мере увеличения размеров этих моделей, они требуют значительно больше памяти и страдают от более высокой задержки, что создает существенные проблемы для развертывания. В данной работе мы ставим цель ускорить модели диффузии, квантуя их веса и активации до 4 бит. На таком агрессивном уровне как веса, так и активации становятся очень чувствительными, где традиционные методы посттренинговой квантизации для больших языковых моделей, такие как сглаживание, становятся недостаточными. Чтобы преодолеть это ограничение, мы предлагаем SVDQuant, новый парадигм квантизации на 4 бита. В отличие от сглаживания, которое перераспределяет выбросы между весами и активациями, наш подход поглощает эти выбросы с помощью низкоранговой ветви. Сначала мы консолидируем выбросы, перемещая их с активаций на веса, затем используем высокоточную низкоранговую ветвь для приема весовых выбросов с помощью Сингулярного Разложения (SVD). Этот процесс облегчает квантизацию с обеих сторон. Однако, наивное запускание низкоранговой ветви независимо приводит к значительным накладным расходам из-за дополнительного перемещения данных активаций, что сводит на нет ускорение от квантизации. Для решения этой проблемы, мы разрабатываем совместно инференционный движок Nunchaku, который сливает ядра низкоранговой ветви в ядра низкобитовой ветви, чтобы избежать избыточного доступа к памяти. Он также может без проблем поддерживать готовые низкоранговые адаптеры (LoRAs) без необходимости переквантизации. Обширные эксперименты на SDXL, PixArt-Sigma и FLUX.1 подтверждают эффективность SVDQuant в сохранении качества изображения. Мы уменьшили использование памяти для моделей FLUX.1 объемом 12B в 3.5 раза, достигнув ускорения в 3.0 раза по сравнению с базовым квантизованным только весами на 4 бита на ноутбуке с 16GB GPU 4090, что открывает путь к более интерактивным приложениям на ПК. Наша библиотека квантизации и инференционный движок являются открытым исходным кодом.