Prompt2Perturb: Текстово-ориентированные атакующие методы диффузионного типа для изображений ультразвука молочной железы

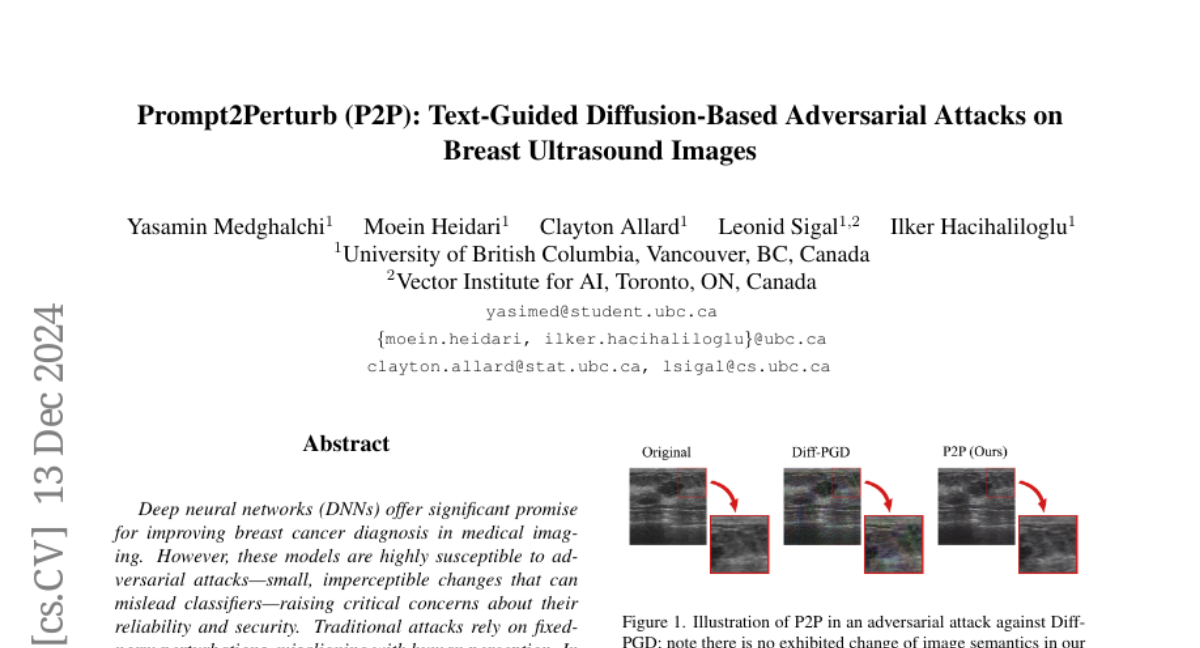

Глубокие нейронные сети (DNN) предлагают значительные перспективы для улучшения диагностики рака молочной железы в медицинской визуализации. Однако эти модели крайне подвержены атакам с противодействием – небольшим, незаметным изменениям, которые могут вводить классификаторы в заблуждение, что вызывает серьезные опасения относительно их надежности и безопасности. Традиционные атаки полагаются на фиксированные нормы возмущений, которые не совпадают с человеческим восприятием. В contrast, атаки на основе диффузии требуют предварительно обученных моделей, что требует значительных данных, когда эти модели недоступны, ограничивая практическое использование в условиях нехватки данных. Однако в медицинской визуализации это часто невозможно из-за ограниченной доступности наборов данных. Основываясь на недавних достижениях в обучаемых подсказках, мы предлагаем Prompt2Perturb (P2P), новый метод атаки, основанный на языке, способный генерировать значимые примеры атак, движимые текстовыми инструкциями. На этапе обучения подсказкам наш подход использует обучаемые подсказки в текстовом энкодере для создания тонких, но значительных возмущений, которые остаются незаметными, направляя модель к целевым результатам. В отличие от текущих подходов, основанных на обучении подсказкам, наш P2P выделяется тем, что непосредственно обновляет текстовые встраивания, избегая необходимости повторной тренировки диффузионных моделей. Более того, мы используем вывод, что оптимизация только ранних обратных шагов диффузии увеличивает эффективность, при этом обеспечивая, чтобы созданные примеры противодействия включали тонкий шум, сохраняя при этом качество ультразвуковых изображений без введения заметных артефактов. Мы показываем, что наш метод превосходит передовые методы атаки по трем наборам данных ультразвука молочной железы по FID и LPIPS. Более того, созданные изображения выглядят более естественно и более эффективно по сравнению с существующими атаками с противодействием. Наш код будет доступен публике https://github.com/yasamin-med/P2P.