Дисентанглинг позы: управление анимацией человеческих изображений

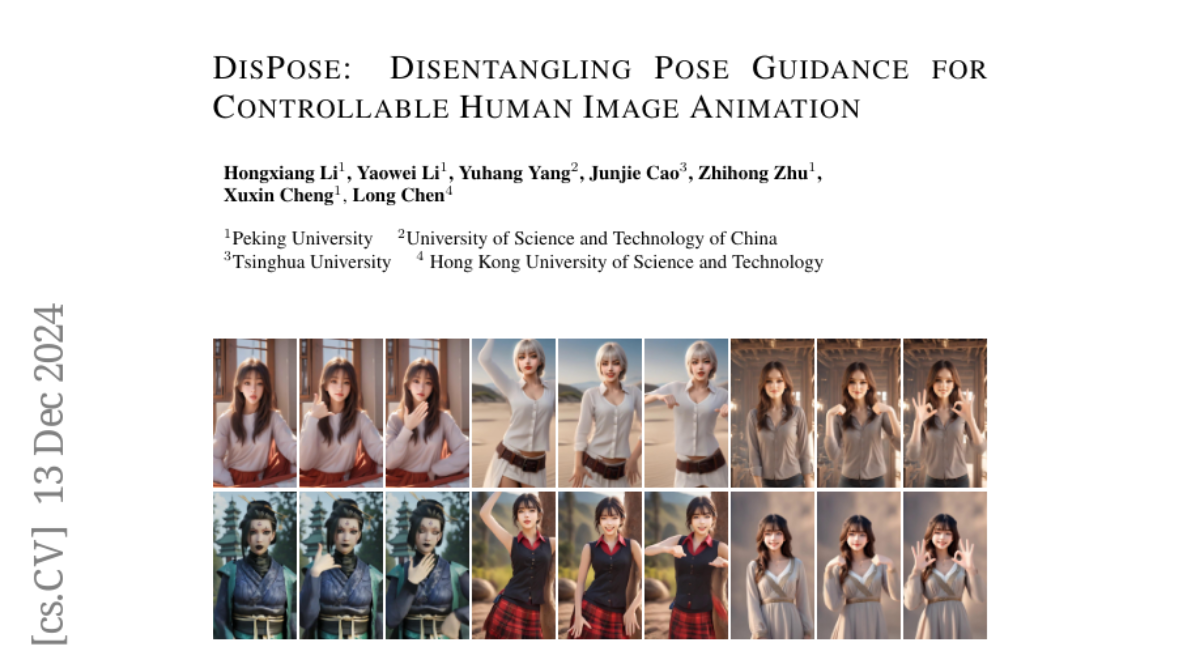

Контролируемая анимация человеческого изображения направлена на генерацию видео из эталонных изображений с использованием управляющих видеозаписей. Из-за ограниченных контрольных сигналов, предоставляемых разреженным управлением (например, поза скелета), в недавних работах были предприняты попытки ввести дополнительные плотные условия (например, карту глубины), чтобы обеспечить согласование движений. Однако такое строгое плотное управление ухудшает качество сгенерированного видео, когда форма тела эталонного персонажа значительно отличается от формы тела в управляющем видео. В этой статье мы представляем DisPose, чтобы извлечь более универсальные и эффективные контрольные сигналы без дополнительного плотного ввода, который разделяет разреженную позу скелета в анимации человеческого изображения на руководство полем движений и соответствие ключевым точкам. В частности, мы генерируем плотное поле движений из разреженного поля движений и эталонного изображения, что обеспечивает плотное руководство на уровне регионов, сохраняя возможность обобщения разреженного контроля позы. Мы также извлекаем диффузионные признаки, соответствующие ключевым точкам позы из эталонного изображения, и затем эти точечные признаки передаются на целевую позу для предоставления четкой идентификационной информации. Чтобы бесшовно интегрироваться в существующие модели, мы предлагаем гибридный ControlNet, который улучшает качество и согласованность сгенерированных видео, замораживая параметры существующей модели. Обширные качественные и количественные эксперименты демонстрируют превосходство DisPose по сравнению с текущими методами. Код: https://github.com/lihxxx/DisPose.