LAION-SG: Новый Подход к Генерации Сложных Изображений с Аннотациями Структурных Графов

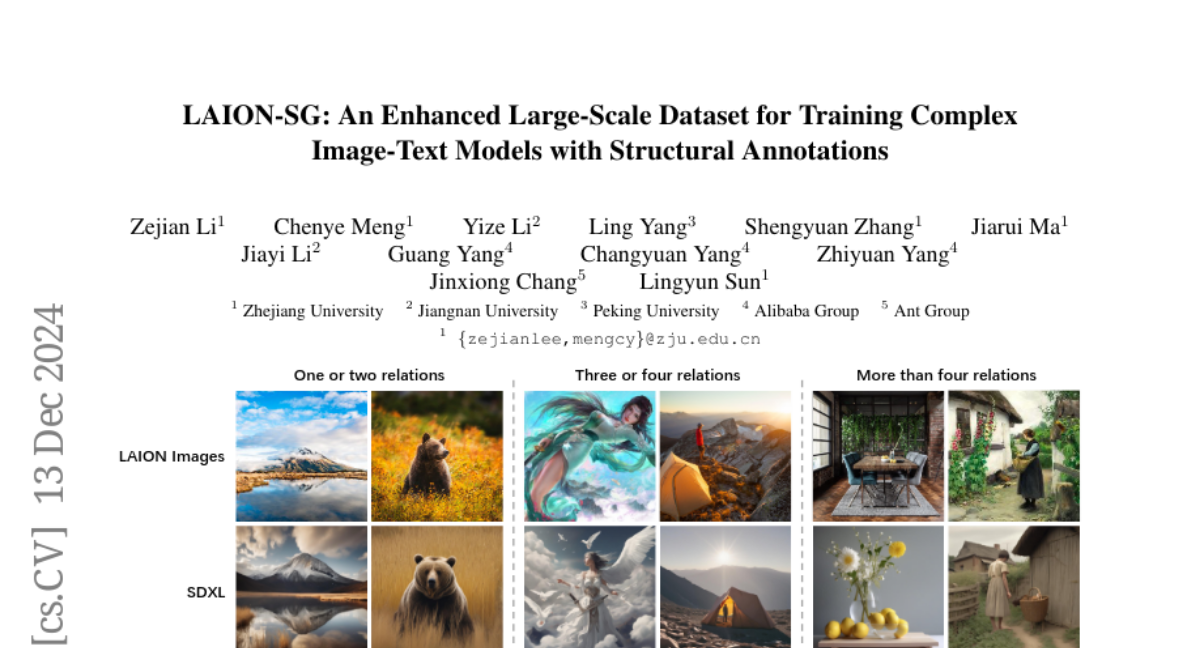

Недавние достижения в генерации изображений из текста (T2I) продемонстрировали выдающиеся результаты в создании высококачественных изображений на основе текста. Однако существующие модели T2I демонстрируют ухудшение производительности в генерации составных изображений с участием нескольких объектов и сложными взаимосвязями. Мы связываем эту проблему с ограничениями существующих наборов данных пар изображений и текста, которые не содержат точных аннотаций взаимосвязей между объектами и имеют только подсказки. Чтобы решить эту проблему, мы создаем LAION-SG, крупномасштабный набор данных с высококачественными структурными аннотациями графов сцен (SG), которые точно описывают атрибуты и взаимосвязи нескольких объектов, эффективно представляя семантическую структуру в сложных сценах. На основе LAION-SG мы обучаем новую базовую модель SDXL-SG, чтобы интегрировать информацию о структурных аннотациях в процесс генерации. Обширные эксперименты показывают, что продвинутые модели, обученные на нашем наборе данных LAION-SG, демонстрируют значительные улучшения производительности в генерации сложных сцен по сравнению с моделями на существующих наборах данных. Мы также представляем CompSG-Bench, бенчмарк, который оценивает модели по генерации составных изображений, устанавливая новый стандарт в этой области.