Когда говорить, когда воздерживаться: Контрастное декодирование с воздержанием

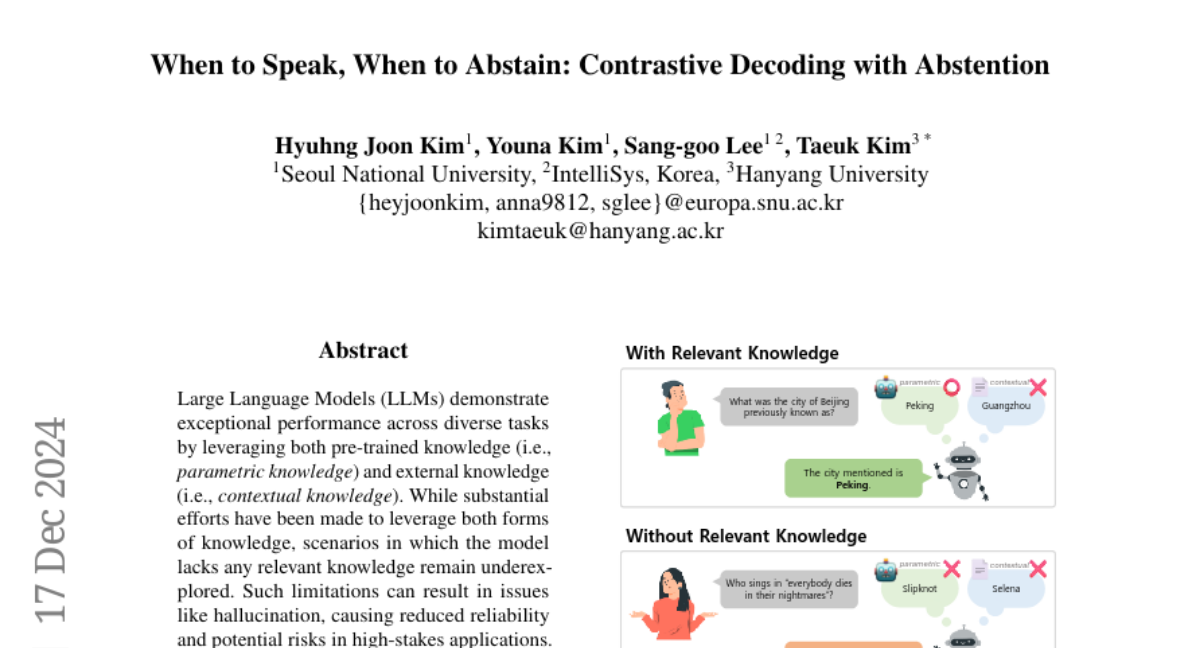

Большие языковые модели (LLM) демонстрируют исключительную производительность по различным задачам, используя как предобученные знания (т.е. параметрические знания), так и внешние знания (т.е. контекстуальные знания). Хотя было предпринято значительное количество усилий для использования обоих видов знаний, сценарии, в которых модель не обладает соответствующими знаниями, остаются недостаточно исследованными. Такие ограничения могут вызывать проблемы, такие как галлюцинации, что приводит к снижению надежности и потенциальным рискам в ситуациях с высокой ставкой. Чтобы устранить такие ограничения, эта статья расширяет область задач, охватывая случаи, когда запрос пользователя не может быть выполнен из-за отсутствия соответствующих знаний. Для этой цели мы представляем Контрастное Декодирование с Воздержанием (CDA), метод декодирования без обучения, который позволяет LLM генерировать ответы, когда соответствующие знания доступны, и воздерживаться в противном случае. CDA оценивает релевантность каждого знания для данного запроса, адаптивно определяя, какие знания следует приоритизировать или какие полностью игнорировать. Обширные эксперименты с четырьмя LLM на трех наборах данных для вопросов и ответов показывают, что CDA может эффективно выполнять точную генерацию и воздержание одновременно. Эти результаты подчеркивают потенциал CDA для расширения применимости LLM, повышения надежности и сохранения доверия пользователей.