Когда говорить, когда воздерживаться: Контрастное декодирование с воздержанием

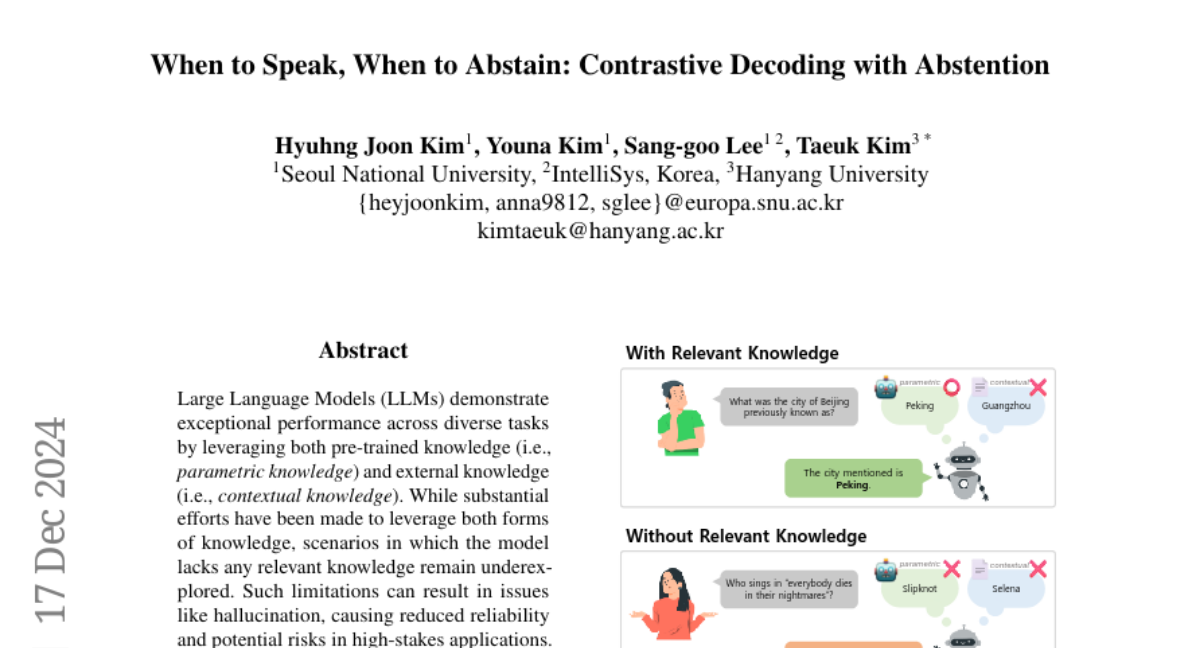

Современные большие языковые модели (LLM) продемонстрировали выдающиеся результаты в различных задачах, используя как предобученные знания (параметрические знания), так и внешние знания (контекстуальные знания). Несмотря на это, существует множество сценариев, в которых модели сталкиваются с отсутствием актуальной информации, что может привести к проблемам, таким как галлюцинации и снижение надежности, особенно в критически важных приложениях. В этой статье мы представим метод, который расширяет возможности LLM, позволяя им не только генерировать ответы, когда у них есть соответствующие знания, но и воздерживаться от генерации в противном случае.

Контрастное декодирование с воздержанием (CDA)

В данной работе предлагается метод контрастного декодирования с воздержанием (CDA), который позволяет моделям LLM адаптивно оценивать релевантность каждого источника знаний для заданного запроса. CDA делает это без необходимости дополнительного обучения, что значительно упрощает его интеграцию в существующие модели. В процессе декодирования CDA определяет, какие знания приоритизировать, а какие игнорировать, а также направляет модель к воздержанию, если релевантные знания отсутствуют.

Задача и ее формулировка

Основная задача заключается в том, чтобы для заданного запроса и контекста модель должна либо генерировать правильный ответ, если релевантные знания доступны, либо воздерживаться от ответа, если знания отсутствуют. Это требует точной оценки как параметрических, так и контекстуальных знаний.

Экспериментальная установка

Для проверки эффективности CDA были проведены эксперименты с использованием четырех LLM на трех наборах данных по вопросно-ответным задачам. Результаты показали, что CDA позволяет моделям одновременно выполнять точную генерацию и воздержание, что значительно повышает надежность и сохраняет доверие пользователей.

Связанные работы

Контрастное декодирование

Контрастное декодирование (CD) управляет генерацией текста, контрастируя различные распределения выходов и направляя модель в нужном направлении. В последнее время возрос интерес к контекстно-осведомленному контрастному декодированию (CCD), которое позволяет моделям использовать как параметрические, так и контекстуальные знания. Однако существующие методы сталкиваются с ограничениями, когда ни один из типов знаний не доступен.

Воздержание в LLM

Модели LLM часто генерируют нежелательные или неточные ответы, такие как галлюцинации и предвзятости. В таких случаях важно, чтобы модель могла воздерживаться от генерации ответов. Воздержание может быть реализовано с помощью оценок уверенности в генерации или путем обучения модели к адекватному воздержанию, что и было предложено в CDA.

Анализ неопределенности модели

Для оценки неопределенности модели используются меры энтропии, которые позволяют определить уровень уверенности модели относительно ее знаний. В CDA мы используем эти меры для калибровки релевантности знаний и дальнейшего управления процессом генерации.

Процесс CDA

Предварительные шаги

На первом этапе CDA определяет распределения параметрических и контекстуальных знаний для каждого шага декодирования. Затем, используя эти распределения, CDA вычисляет окончательное распределение выходов, учитывая как релевантные, так и нерелевантные источники знаний.

Интеграция воздержания

CDA включает распределение воздержания в окончательное распределение, что позволяет модели воздерживаться от генерации, если уверенность в знаниях низка. Это достигается путем динамического изменения веса, присваиваемого каждому источнику знаний, в зависимости от уровня неопределенности.

Оценка релевантности знаний

Релевантность знаний оценивается на основе калибровки неопределенности, что позволяет модели динамически адаптироваться к различным сценариям. Это обеспечивает более точное управление генерацией и воздержанием.

Экспериментальные результаты

Установка экспериментов

Эксперименты проводились на трех наборах данных: Natural Questions, HotpotQA и TriviaQA. Для каждого набора данных были оценены различные аспекты производительности CDA, включая точность генерации ответов и эффективность воздержания.

Результаты

CDA продемонстрировала высокую производительность как в точности ответов, так и в способности воздерживаться от генерации в случаях, когда знания отсутствуют. В сравнении с другими методами, CDA и CDA-M (версия с моментумом) показали лучшие результаты по всем метрикам.

Заключение

Метод контрастного декодирования с воздержанием (CDA) представляет собой значительный шаг вперед в области обработки естественного языка. Он не только позволяет моделям LLM генерировать точные ответы, но и эффективно управлять ситуациями, когда знания отсутствуют, что значительно повышает надежность и безопасность применения этих технологий в критически важных приложениях. В дальнейшем необходимо исследовать возможности расширения CDA для более сложных сценариев, включая многоконтекстные задачи и долгосрочные генерации.