FreeScale: Разблокировка разрешения диффузионных моделей с помощью слияния масштабов без настройки

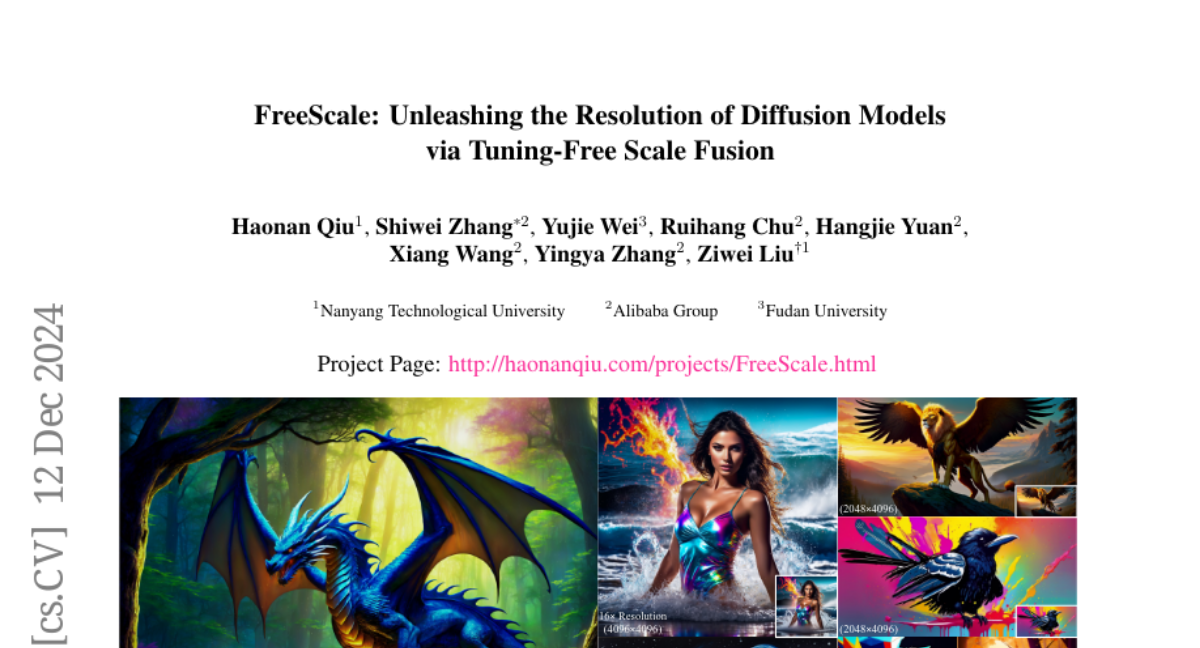

Визуальные диффузионные модели достигают замечательного прогресса, однако они обычно обучаются на ограниченных разрешениях из-за нехватки данных высокого разрешения и ограниченных вычислительных ресурсов, что сдерживает их способность генерировать изображения или видеоролики высокого качества на больших разрешениях. Недавние усилия исследовали стратегии без настройки, чтобы продемонстрировать неиспользованный потенциал генерации визуальных изображений более высокого разрешения с использованием предварительно обученных моделей. Однако эти методы все еще склонны к производству визуального контента низкого качества с повторяющимися паттернами. Ключевое препятствие заключается в неизбежном увеличении высокочастотной информации, когда модель генерирует визуальный контент, превышающий разрешение ее обучения, что приводит к нежелательным повторяющимся паттернам, возникшим из накопленных ошибок. Чтобы справиться с этой проблемой, мы предлагаем FreeScale, парадигму вывода без настройки, которая позволяет осуществлять генерацию визуального контента более высокого разрешения с помощью слияния масштабов. В частности, FreeScale обрабатывает информацию с разных восприимчивых масштабов, а затем сливает ее, извлекая необходимые частотные компоненты. Обширные эксперименты подтверждают превосходство нашей парадигмы в расширении возможностей генерации визуального контента более высокого разрешения как для моделей изображений, так и для видеомоделей. Особенно примечательно, что по сравнению с предыдущим лучшим методом, FreeScale впервые открывает возможность генерации изображений разрешением 8k.