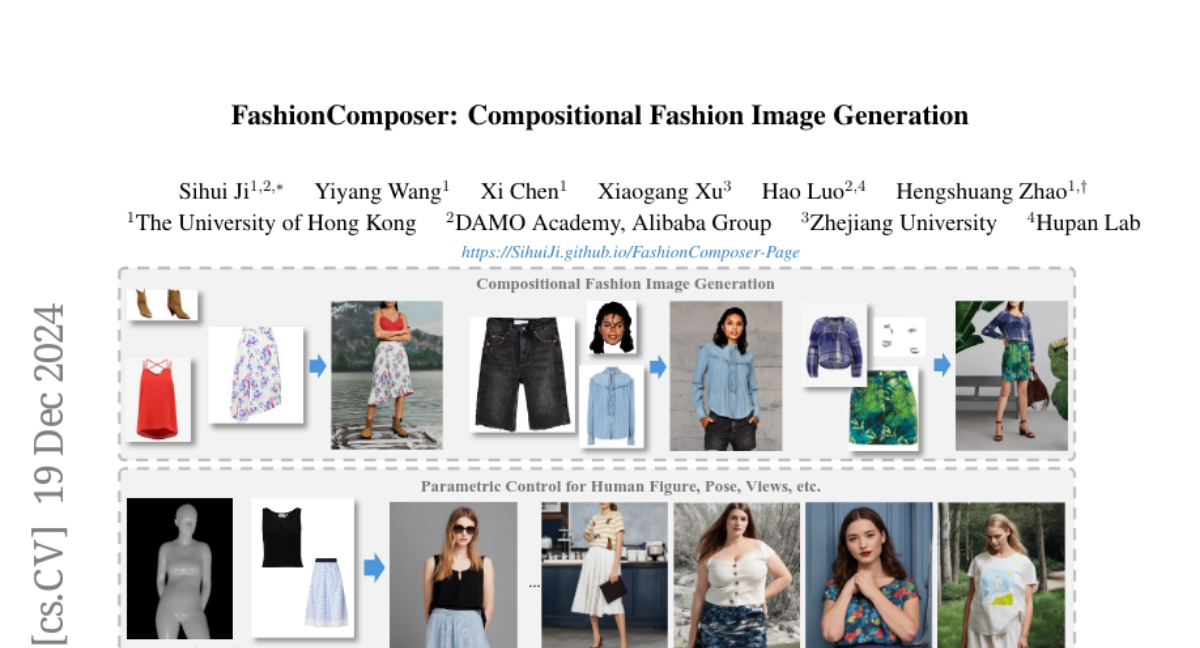

FashionComposer: Генерация Композиционных Модных Изображений

Мы представляем FashionComposer для генерации композиционных модных изображений. В отличие от прежних методов, FashionComposer обладает высокой гибкостью. Он принимает многомодульный ввод (т.е. текстовый запрос, параметрическую модель человека, изображение одежды и изображение лица) и поддерживает персонализацию внешнего вида, позы и фигуры человека, а также назначение нескольких предметов одежды за один проход. Для достижения этого мы сначала развиваем универсальную структуру, способную обрабатывать различные входные модули. Мы строим масштабированные учебные данные, чтобы улучшить надежные композиционные способности модели. Чтобы бесшовно интегрировать несколько изображений-ссылок (одежды и лиц), мы организуем эти ссылки в одном изображении как «библиотеку активов» и используем UNet ссылок для извлечения внешних характеристик. Чтобы ввести внешние характеристики в правильные пиксели в сгенерированном результате, мы предлагаем привязку внимания к субъекту. Она связывает внешние характеристики из разных «активов» с соответствующими текстовыми характеристиками. Таким образом, модель может понимать каждый актив в соответствии с их семантикой, поддерживая произвольные числа и типы изображений-ссылок. Как комплексное решение, FashionComposer также поддерживает многие другие приложения, такие как генерация альбома человека, различные виртуальные задания по примерке и т.д.