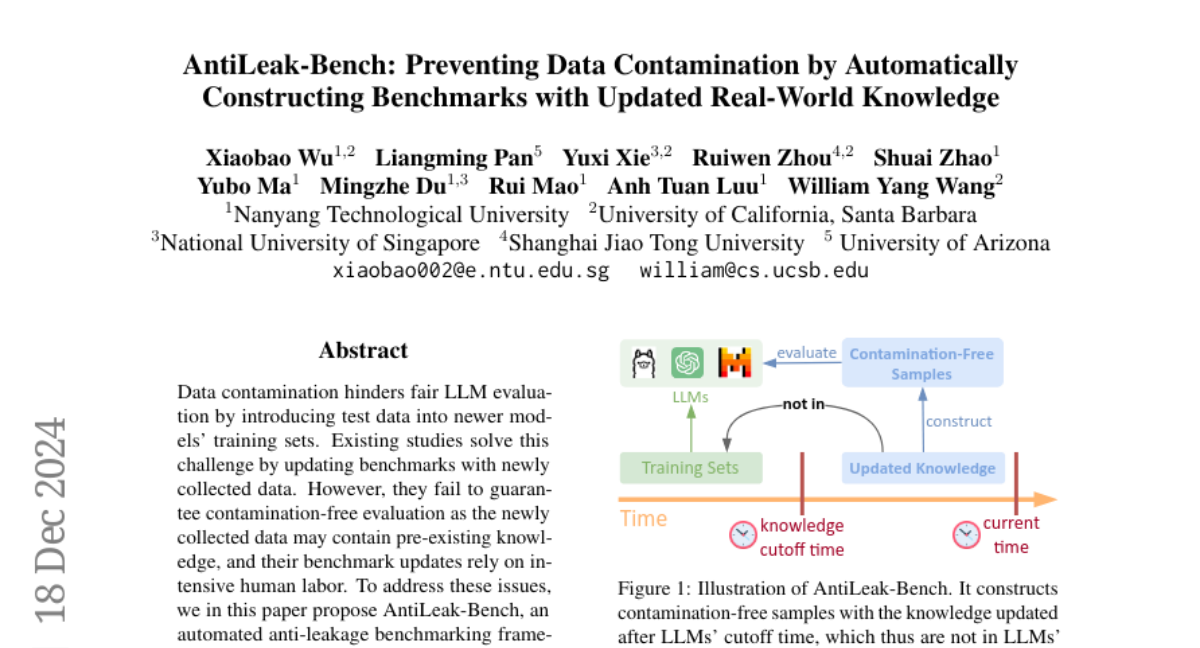

AntiLeak-Bench: Автоматизированная система для предотвращения загрязнения данных в оценке LLM

Загрязнение данных затрудняет справедливую оценку LLM, вводя тестовые данные в обучающие наборы более новых моделей. Существующие исследования решают эту задачу, обновляя эталоны с использованием вновь собранных данных. Однако они не гарантируют оценку без загрязнения, так как вновь собранные данные могут содержать уже существующие знания, и их обновления эталонов зависят от интенсивного человеческого труда. Чтобы решить эти проблемы, мы в этой статье предлагаем AntiLeak-Bench, автоматизированную рамочную систему для тестирования на утечку. Вместо того чтобы просто использовать вновь собранные данные, мы создаем образцы с явно новыми знаниями, отсутствующими в обучающих наборах LLM, что тем самым гарантирует строгое отсутствие загрязнения при оценке. Мы также разрабатываем полностью автоматизированный рабочий процесс для построения и обновления нашего эталона без человеческого труда. Это значительно снижает затраты на поддержание эталона, чтобы удовлетворить потребности новых LLM. В ходе обширных экспериментов мы подчеркиваем, что загрязнение данных, вероятно, существует до времени ограничения LLM, и демонстрируем, что AntiLeak-Bench эффективно преодолевает эту проблему.