AntiLeak-Bench: Автоматизированная система для предотвращения загрязнения данных в оценке LLM

В последние годы большие языковые модели (LLM) продемонстрировали впечатляющие способности в различных областях, таких как обработка естественного языка, генерация текста и решение математических задач. Однако для адекватной оценки их производительности необходимо учитывать проблему загрязнения данных. Загрязнение данных возникает, когда тестовые данные из бенчмарков попадают в тренировочные наборы новых моделей, что может привести к завышенным показателям производительности и подорвать надежность оценок.

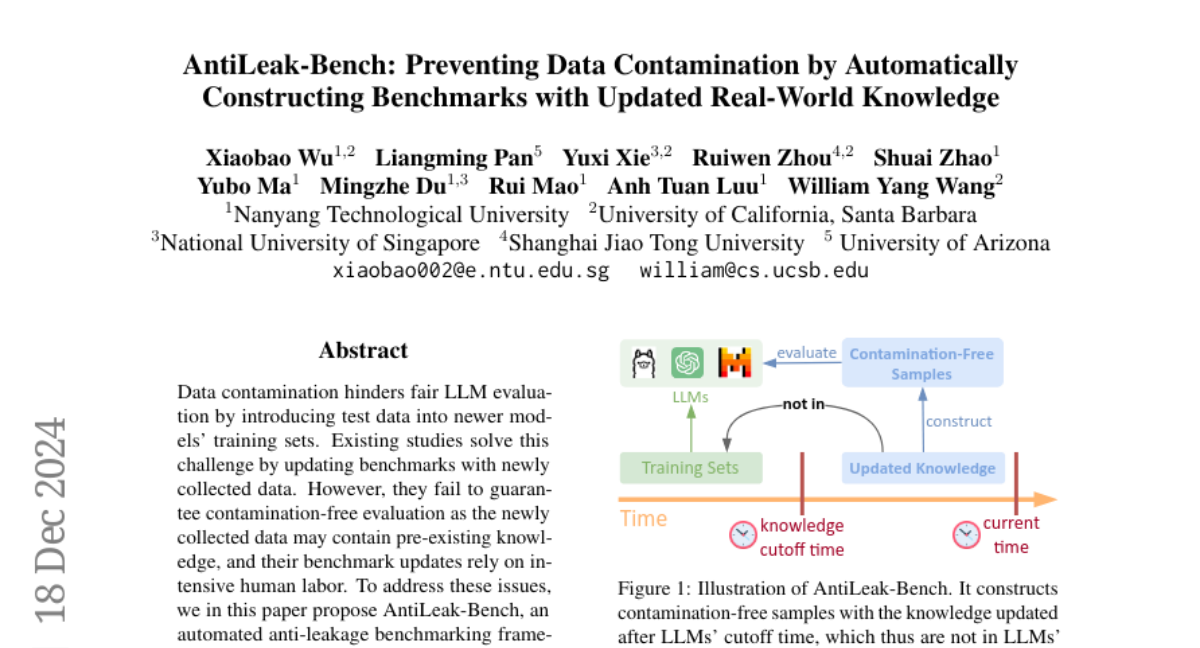

Существующие исследования пытаются решать эту проблему, обновляя бенчмарки новыми данными, собранными после времени отсечения знаний LLM. Однако эти подходы не гарантируют отсутствие загрязнения, так как новые данные могут содержать предсуществующие знания. Более того, обновления бенчмарков часто требуют значительных затрат человеческого труда.

В данной статье мы представляем AntiLeak-Bench, автоматизированную платформу для бенчмаркинга, которая предотвращает загрязнение данных, создавая тестовые образцы с явно новыми знаниями, отсутствующими в тренировочных наборах LLM. Это обеспечивает строгое оценивание без загрязнения. Мы также разработали полностью автоматизированный рабочий процесс для создания и обновления нашего бенчмарка без необходимости в человеческом труде, что значительно снижает затраты на его обслуживание.

Проблема загрязнения данных

Определение

Загрязнение данных в контексте LLM происходит, когда тестовые наборы данных содержат информацию, которая уже была использована для обучения модели. Это может привести к тому, что модель будет демонстрировать завышенные результаты на тестах, так как она фактически "знает" ответы, основываясь на ранее увиденных данных, а не на своей способности обрабатывать и понимать информацию.

Влияние на оценку

Загрязнение данных может негативно сказаться на надежности и валидности оценок LLM. Например, если модель была обучена на вопросах из математических экзаменов, а затем эти же вопросы используются в тестах, это приведет к искажению результатов. Модели, которые на самом деле не обладают необходимыми знаниями, могут показать высокие результаты просто потому, что они "знают" ответы.

Существующие подходы

Некоторые современные исследования пытаются динамически обновлять бенчмарки, собирая новые данные, выпущенные после времени отсечения знаний модели. Например, системы, такие как RealTimeQA и LiveBench, собирают новые вопросы из различных источников. Однако эти методы сталкиваются с двумя основными ограничениями:

- Слабая гарантия отсутствия загрязнения: Новые данные могут содержать уже известные модели знания, что делает их неэффективными для оценки.

- Высокая зависимость от человеческого труда: Обновления бенчмарков часто требуют значительных затрат времени и ресурсов для аннотирования собранных данных.

AntiLeak-Bench: Автоматизированный подход

Основная идея

AntiLeak-Bench предлагает решение проблемы загрязнения данных путем создания тестовых образцов, основанных на новых знаниях, которые отсутствуют в тренировочных наборах LLM. Это достигается путем автоматизированного извлечения и обработки данных из актуальных источников, таких как Wikidata и Wikipedia.

Рабочий процесс

Рабочий процесс AntiLeak-Bench состоит из трех основных этапов:

- Идентификация обновленных знаний: Мы определяем новые факты и утверждения, которые появились после времени отсечения знаний LLM.

- Создание поддерживающих документов: Для каждого нового знания мы собираем контекстные документы из надежных источников, чтобы обеспечить точность информации.

- Конструирование образцов без загрязнения: На основе собранных данных мы создаем тестовые образцы, которые гарантированно не содержат информации из тренировочных наборов LLM.

Преимущества

- Строгое отсутствие загрязнения: AntiLeak-Bench обеспечивает создание образцов, которые не содержат знаний из LLM, что позволяет проводить оценку без загрязнения.

- Полная автоматизация: Рабочий процесс полностью автоматизирован, что снижает затраты на обслуживание и позволяет быстро адаптироваться к новым моделям.

- Многоязычность: AntiLeak-Bench поддерживает создание образцов на различных языках, что позволяет оценивать LLM в разных языковых контекстах.

Эксперименты и результаты

Настройка эксперимента

Мы провели серию экспериментов с использованием 12 различных открытых LLM, чтобы продемонстрировать эффективность AntiLeak-Bench. Мы создали два типа тестовых образцов: до и после времени отсечения знаний. Образцы до отсечения содержат знания, которые могли быть включены в тренировочные наборы, в то время как образцы после отсечения содержат исключительно новые знания.

Анализ загрязнения данных

Результаты показали, что производительность большинства LLM снижается после времени отсечения. Это указывает на наличие загрязнения в образцах до отсечения, которые могут приводить к завышенным показателям производительности. В то же время образцы после отсечения оказались более сложными и позволили более точно оценить способности LLM.

Общая производительность

Результаты наших экспериментов показали, что AntiLeak-Bench представляет собой значительный вызов для LLM. Большинство моделей показали результаты ниже 50% на тестах, что подчеркивает необходимость улучшения их способностей к пониманию и обработке информации.

Анализ сложности

Мы также провели анализ сложности различных типов задач. Многообразие форматов вопросов (одиночные и многошаговые) показало, что многошаговые задачи значительно сложнее для LLM. Это требует от моделей способности к более глубокому пониманию и интеграции информации из длинных контекстов.

Заключение

AntiLeak-Bench представляет собой значительный шаг вперед в области автоматизированного бенчмаркинга LLM. Он обеспечивает строгое отсутствие загрязнения данных и позволяет проводить более надежную и точную оценку моделей. Автоматизация рабочего процесса значительно снижает затраты на обслуживание и делает систему более доступной для широкого круга исследователей и разработчиков.

Ограничения и будущее

Несмотря на свои преимущества, AntiLeak-Bench имеет некоторые ограничения. В будущем стоит рассмотреть возможность расширения задач для более разнообразной оценки LLM и интеграции дополнительных источников данных для повышения точности и надежности.