MALT: Улучшение рассуждений с помощью обучения многоагентных LLM

Современные большие языковые модели (LLM) продемонстрировали впечатляющие результаты в различных областях, включая решение математических задач, помощь в исследованиях и создание контента. Однако, несмотря на их потенциал, использование LLM в качестве отдельных генераторов часто приводит к недостаточной эффективности при решении сложных задач, требующих комплексного рассуждения. В данной статье мы рассмотрим подход, известный как Multi-Agent LLM Training (MALT), который предлагает новый способ обучения LLM для совместного выполнения задач через многоагентные системы.

Проблематика

Одной из основных проблем, с которой сталкиваются LLM, является их ограниченная способность к совместному решению задач. Хотя недавние исследования показали, что модели могут эффективно взаимодействовать в рамках многопользовательских систем, большинство из них обучены индивидуально и не оптимизированы для совместной работы. Это приводит к необходимости разработки новых методов, которые позволят моделям работать вместе, улучшая общую производительность.

Основные концепции MALT

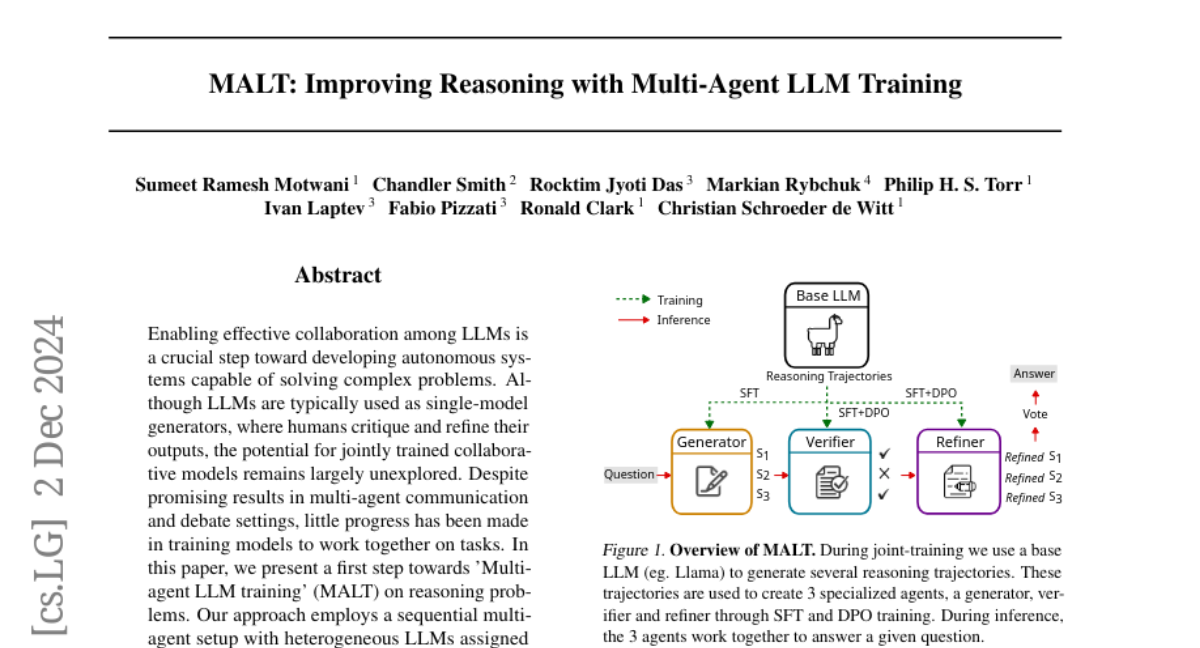

MALT представляет собой подход, в рамках которого несколько LLM обучаются совместно, выполняя специализированные роли: генератор, проверяющий и модель уточнения. Эти модели работают последовательно для решения задач, что позволяет улучшить качество их ответов и повысить общую эффективность.

Структура MALT

- Генератор (Generator): Эта модель отвечает за создание первоначального ответа на заданный вопрос.

- Проверяющий (Verifier): Проверяет ответ генератора на наличие ошибок и предлагает корректировки.

- Модель уточнения (Refinement Model): Интегрирует обратную связь от проверяющего для улучшения окончательного ответа.

Такой подход напоминает человеческую командную работу, где каждый участник выполняет свою специализированную роль для достижения общей цели.

Процесс обучения

Обучение в MALT включает несколько этапов:

- Генерация данных: Генератор создает множество рассуждений по заданным вопросам.

- Проверка данных: Проверяющий анализирует ответы генератора, определяя их корректность.

- Уточнение данных: Модель уточнения использует информацию от проверяющего для улучшения окончательного ответа.

Каждый из этих этапов создает синтетические данные, которые затем используются для дообучения каждой модели с использованием методов, таких как Supervised Fine-Tuning (SFT) и Direct Preference Optimization (DPO).

Методология MALT

Генерация синтетических данных

Одной из ключевых особенностей MALT является метод генерации синтетических данных, который использует стратегию расширения траекторий. На каждом этапе генерации, модель создает множество возможных ответов, которые затем проверяются и уточняются. Это позволяет создать большое количество полезных данных для обучения.

Стратегия назначения кредитов

В MALT также используется стратегия назначения кредитов, основанная на бинарных вознаграждениях. Это позволяет автоматически определять, какая модель внесла ошибку, что упрощает процесс обучения и улучшает производительность каждой модели.

Применение MALT

MALT был протестирован на нескольких наборах данных, включая MATH, GSM8k и CSQA, где он продемонстрировал значительные улучшения по сравнению с базовыми моделями. Например, MALT, использующий модели Llama 3.1 8B, достиг улучшений на 14.14%, 7.12% и 9.40% соответственно на этих задачах.

Связанные работы

Работа MALT пересекается с множеством исследований в области проектирования агентов, самосовершенствования, рассуждений и обучения с подкреплением. В частности, методы, такие как SFT и DPO, играют важную роль в дообучении моделей для повышения их эффективности.

Методы дообучения

- Supervised Fine-Tuning (SFT): Использует размеченные данные для адаптации предобученных моделей к конкретным задачам.

- Direct Preference Optimization (DPO): Оптимизирует модель на основе предпочтений, что значительно улучшает согласование с человеческими ожиданиями.

Генерация синтетических данных

Генерация синтетических данных становится все более популярной стратегией для улучшения возможностей LLM. Например, в проектах, таких как Self-Taught Reasoner (STaR), модели итеративно уточняют свои рассуждения, создавая полезные данные для дальнейшего обучения.

Экспериментальные результаты

MALT был протестирован на трех основных наборах данных: GSM8K, MATH и CSQA. Результаты показали, что MALT значительно превосходит все базовые модели и другие методы, достигая высоких показателей точности.

Данные о производительности

- GSM8K: 84.25% точности

- MATH: 56.25% точности

- CSQA: 81.5% точности

Эти результаты подтверждают, что MALT является эффективным методом для улучшения рассуждений и производительности LLM в сложных задачах.

Заключение и будущее

MALT представляет собой значительный шаг вперед в области обучения многоагентных LLM, предлагая новые методы для улучшения их совместной работы и производительности. В будущем исследование может сосредоточиться на расширении этого метода для более сложных задач и улучшении его адаптивности к новым условиям.

Перспективы

Будущие направления исследований могут включать использование других методов оптимизации, таких как Proximal Policy Optimization (PPO), а также изучение различных архитектур многоагентных систем для повышения их эффективности.

Заключение

MALT открывает новые горизонты в обучении LLM, показывая, как многоагентные системы могут улучшить качество рассуждений и производительность моделей. Этот подход может стать основой для разработки более сложных и эффективных AI-систем, способных решать реальные задачи в различных областях.